Tauchen Sie mit uns ein in die Rolle der KI in der Musik, von der Analyse von Audiodaten bis zur Generierung neuer Musik. Entdecken Sie ihre Auswirkungen und Anwendungen in der Musikindustrie.

Tauchen Sie mit uns ein in die Rolle der KI in der Musik, von der Analyse von Audiodaten bis zur Generierung neuer Musik. Entdecken Sie ihre Auswirkungen und Anwendungen in der Musikindustrie.

Bei der künstlichen Intelligenz (KI) geht es darum, die menschliche Intelligenz in Maschinen nachzubilden. Ein wichtiger Teil des Menschseins ist unsere Verbindung zur Kunst, insbesondere zur Musik. Musik beeinflusst unsere Kultur und unsere Emotionen tiefgreifend. Dank der Fortschritte in der KI können Maschinen heute Musik erzeugen, die so klingt, als wäre sie von Menschen komponiert worden. KI-Musik eröffnet neue Möglichkeiten für innovative Kooperationen zwischen Mensch und KI und verändert die Art und Weise, wie wir Musik erleben und mit ihr interagieren.

In diesem Artikel werden wir untersuchen, wie KI zur Erstellung von Musik eingesetzt wird. Wir werden auch die Verbindung zwischen KI und Musik-Tagging-Tools wie MusicBrainz Picard und deren Auswirkungen auf Künstler, Produzenten und die Unterhaltungsindustrie insgesamt diskutieren.

KI kann verschiedene Datentypen verarbeiten, einschließlich Ton. Tondaten, oft auch als Audiodaten bezeichnet, sind eine Mischung aus Wellenfrequenzen unterschiedlicher Intensität im Zeitverlauf. Genau wie Bilder oder Zeitreihendaten können Audiodaten in ein Format umgewandelt werden, das KI-Systeme verarbeiten und analysieren können. Schallwellen können in numerische Daten umgewandelt werden, die von KI-Modellen analysiert werden können.

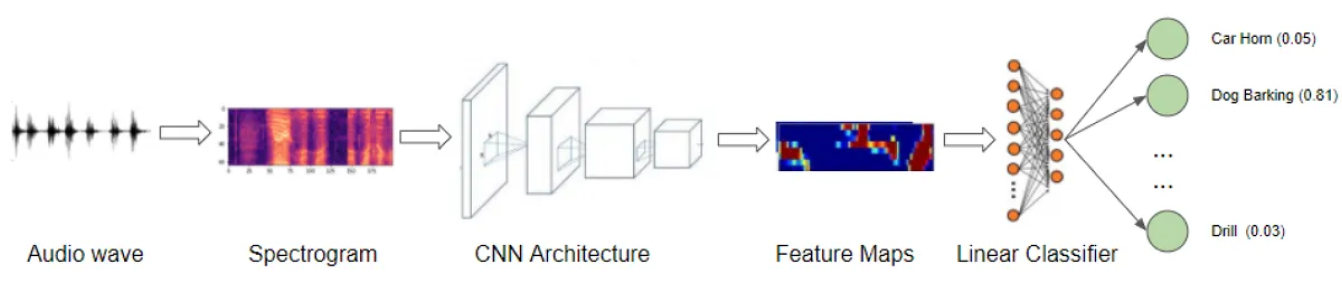

Eine weitere interessante Methode ist die Verwendung von Fourier-Transformationen, die Schallwellen in ein Spektrogramm umwandeln. Ein Spektrogramm ist eine visuelle Darstellung, die zeigt, wie sich verschiedene Frequenzen des Schalls im Laufe der Zeit verändern. KI-Modelle können Bilderkennungs-Techniken anwenden, um die Audiodaten zu analysieren und zu interpretieren, indem sie dieses Spektrogramm wie ein Bild behandeln. KI kann Muster und Merkmale innerhalb des Klangs identifizieren, ähnlich wie bei visuellen Daten.

Der Einsatz von KI zur Analyse, Manipulation und Erzeugung von Audiodaten ermöglicht eine Vielzahl von Anwendungen. Hier sind einige Beispiele:

KI-Songgeneratoren funktionieren, indem sie von bestehender Musik lernen und diese analysieren, ähnlich wie bei der Bildgenerierung. Es ist wichtig, den Unterschied zwischen der Verwendung von KI zum Verständnis von Musik und der Verwendung von KI zur Generierung von Musik zu verstehen. Das Verständnis von Musik beinhaltet das Analysieren und Identifizieren von Mustern, während das Generieren von Musik das Erstellen neuer Kompositionen auf der Grundlage dieser gelernten Muster beinhaltet.

.png)

Der Prozess der KI-Musikgenerierung beginnt mit dem Sammeln eines großen Datensatzes von Musik, der verschiedene Genres und Stile umfasst. Der Datensatz wird dann in kleinere Komponenten wie Noten, Akkorde und Rhythmen zerlegt, die in numerische Daten umgewandelt werden, die die KI verarbeiten kann.

Es gibt viele verschiedene generative KI-Modelle, die trainiert werden können, um Musik zu erzeugen. Beispielsweise können KI-Modelle wie Transformers und Variational Autoencoders (VAEs) zusammenarbeiten, um Musik zu erzeugen. VAEs können Eingangsgeräusche in einen latenten Raum komprimieren, indem sie ähnliche Musikstücke eng zusammen gruppieren, um die Vielfalt und den Reichtum der Musik zu erfassen. Transformers verwenden dann diesen latenten Raum, um neue Musik zu erzeugen, indem sie Muster verstehen und sich auf wichtige Noten in einer Sequenz konzentrieren.

Sobald ein KI-Modell mit diesen Daten trainiert wurde, kann die KI neue Musik generieren, indem sie die nächste Note oder den nächsten Akkord auf der Grundlage des Gelernten vorhersagt. Es kann ganze Kompositionen erstellen, indem es diese Vorhersagen aneinanderreiht. Die generierte Musik kann so abgestimmt werden, dass sie bestimmten Stilen oder Vorlieben entspricht.

Wir sehen immer mehr Musikgeneratoren, die diese Technologie nutzen. Hier sind einige Beispiele:

KI-Innovationen schaffen neue Möglichkeiten und Herausforderungen für Musiker, Zuhörer und Produzenten, was zu Situationen führt, die sie möglicherweise noch nicht erlebt haben. Es ist interessant zu sehen, wie sich jede Gruppe an diese Fortschritte anpasst, neue Werkzeuge einsetzt und Bedenken hinsichtlich Originalität und Ethik ausräumt. Neben der Musikgenerierung hat KI in der Musikindustrie noch weitere spannende Potenziale, wie z. B. die Verbesserung von Live-Auftritten, die Verbesserung der Musikerkennung und die Unterstützung von Produktionsprozessen. Sehen wir uns genauer an, wie sich KI auf Musiker, Zuhörer und Produzenten in der Musikindustrie auswirkt.

.png)

KI verändert die Art und Weise, wie Musiker Musik machen. Tools, die mit generativer KI integriert sind, können helfen, neue Melodien, Akkordfolgen und Texte zu generieren, was es Musikern erleichtert, kreative Blockaden zu überwinden. KI wurde auch verwendet, um unvollendete Werke zu vollenden, wie z. B. den neuen Song der Beatles "Now And Then", der mit John Lennons Gesang aus einem alten Demo erstellt wurde. Der Aufstieg von KI-generierter Musik, die den Stil etablierter Künstler nachahmt, wirft jedoch Bedenken hinsichtlich der Originalität auf. So sind beispielsweise Künstler wie Bad Bunny besorgt darüber, dass KI ihre Stimmen und Stile ohne Zustimmung repliziert.

Neben der Erstellung von Musik können KI und Computer Vision Musikern dabei helfen, bessere Auftritte und Musikvideos zu erstellen. Ein Musikvideo besteht aus vielen verschiedenen Elementen, und eines dieser Elemente ist das Tanzen. Modelle zur Schätzung der Körperhaltung wie Ultralytics YOLOv8 können menschliche Posen in Bildern und Videos verstehen und eine Rolle bei der Erstellung von choreografierten Tanzsequenzen spielen, die mit der Musik synchronisiert sind.

Ein weiteres gutes Beispiel dafür, wie KI für Choreografien eingesetzt werden kann, ist das Projekt"Dance to Music" von NVIDIA. In diesem Projekt wurden mithilfe von KI und einem zweistufigen Prozess neue Tanzbewegungen generiert, die vielfältig und stilistisch konsistent sind und zum Beat passen. Zunächst wurden Posenschätzung und ein kinematischer Beat-Detektor verwendet, um verschiedene Tanzbewegungen im Takt aus einer großen Sammlung von Tanzvideos zu lernen. Dann wurde ein generatives KI-Modell verwendet, um diese Tanzbewegungen in eine Choreografie zu organisieren, die dem Rhythmus und dem Stil der Musik entspricht. KI-choreografierte Tanzbewegungen fügen den Musikvideos ein interessantes visuelles Element hinzu und helfen den Künstlern, kreativer zu sein.

Für Zuhörer kann KI die Musikentdeckung und das Hörerlebnis verbessern. Plattformen wie Spotify und Apple Music nutzen KI, um personalisierte Wiedergabelisten zusammenzustellen und neue Musik basierend auf den Hörgewohnheiten der Nutzer zu empfehlen. Wenn Sie auf diesen Plattformen neue Künstler und Genres entdecken, ist das die Magie der KI.

KI-gestützte Virtual Reality (VR) verbessert auch Live-Konzerterlebnisse. Zum Beispiel nutzt Travis Scott VR, um virtuelle Auftritte zu schaffen, die ein globales Publikum erreichen. Die Fülle an KI-generierter Musik auf Plattformen wie TikTok kann die Musikentdeckung jedoch überwältigend machen. Es könnte es neuen Künstlern erschweren, sich abzuheben.

Produzenten profitieren auf verschiedene Weise von KI. KI-Tools, die bei der Tonhöhenkorrektur, dem Mischen und dem Mastering helfen, rationalisieren den Produktionsprozess. KI-gestützte virtuelle Instrumente und Synthesizer, wie IBMs Watson Beat, können neue Klänge und Texturen erzeugen, die die kreativen Möglichkeiten erweitern.

KI auf Streaming-Plattformen ist nicht nur ein Vorteil für die Zuhörer, sondern hilft auch den Produzenten, ein breiteres Publikum zu erreichen. So wie Musiker besorgt sind, wirft die Fähigkeit der KI, den Stil etablierter Künstler nachzuahmen, ethische und rechtliche Fragen hinsichtlich der Ausbeutung der einzigartigen Stimmen und Stile von Künstlern auf. Dies hat zu rechtlichen Auseinandersetzungen geführt, wie z. B. Klagen von großen Musikkonzernen wie Universal, Sony und Warner gegen KI-Startups wie Suno und Udio, weil diese angeblich urheberrechtlich geschützte Werke verwendet haben, um ihre Modelle ohne Genehmigung zu trainieren.

Wir haben kurz einige Anwendungen von KI in der Musik erforscht, indem wir ihre Auswirkungen auf verschiedene Akteure in der Musikindustrie verstanden haben. Jetzt wollen wir eine spezifischere Anwendung von KI in der Musik verstehen: KI-gestützte Musikverwaltungstools wie MusicBrainz Picard. Diese Tools sind unglaublich nützlich, um digitale Musikbibliotheken zu organisieren und zu verwalten.

Sie identifizieren und kennzeichnen Musikdateien automatisch mit genauen Metadaten wie Künstlernamen, Albumtiteln und track . MusicBrainz Picard macht es einfacher, Musiksammlungen übersichtlich zu halten. Eine der Schlüsseltechnologien, die in MusicBrainz Picard integriert sind, sind die AcoustID Audio Fingerprints. Diese Fingerabdrücke identifizieren Musikdateien anhand ihres tatsächlichen Audioinhalts, auch wenn die Dateien keine Metadaten enthalten.

Warum ist das so wichtig? Große Organisationen wie die BBC, Google, Amazon, Spotify und Pandora verlassen sich auf MusicBrainz-Daten, um ihre musikbezogenen Dienste zu verbessern. Die Metadaten, die von Tools wie MusicBrainz Picard erstellt werden, sind entscheidend für Entwickler, die Musikdatenbanken, Tagger-Anwendungen oder andere musikbezogene Software entwickeln. Das Rückgrat der künstlichen Intelligenz sind Daten, und ohne Tools wie Picard wäre es sehr schwierig, über saubere, genaue Daten zu verfügen, die für die Analyse und Anwendungsentwicklung notwendig sind. Es ist faszinierend, dass KI-verbesserte Tools KI nutzen und dabei helfen, die für KI-Anwendungen benötigten Daten zu erstellen, wodurch ein nützlicher Kreislauf der Verbesserung und Innovation entsteht.

Wir haben die Wellen besprochen, die KI in der Musik schlägt. Auch die rechtliche Landschaft rund um KI-generierte Musik entwickelt sich weiter. Aktuelle Bestimmungen, wie die des U.S. Copyright Office, legen fest, dass Werke, die vollständig von KI generiert wurden, nicht urheberrechtlich geschützt werden können, da ihnen die menschliche Urheberschaft fehlt. Wenn jedoch ein Mensch wesentlich zum kreativen Prozess beiträgt, kann das Werk urheberrechtlich geschützt werden. Da KI immer stärker in die Musikindustrie integriert wird, werden fortlaufende rechtliche und ethische Diskussionen entscheidend sein, um diese Herausforderungen zu bewältigen. Mit Blick auf die Zukunft hat KI ein enormes Potenzial in der Musik, indem sie Technologie mit menschlicher Kreativität kombiniert, um die Möglichkeiten der Musikschaffung und Produktion zu erweitern.

Entdecken Sie KI, indem Sie unser GitHub-Repository besuchen und unserer lebendigen Community beitreten. Erfahren Sie mehr über KI-Anwendungen in der Fertigung und Landwirtschaft auf unseren Lösungsseiten.