Bereitstellung von Computer-Vision-Anwendungen auf Edge-KI-Geräten

Erfahren Sie, wie Edge AI und NVIDIA Innovationen, wie Jetson, Triton und TensorRT, den Einsatz von Computer Vision Anwendungen vereinfachen.

Erfahren Sie, wie Edge AI und NVIDIA Innovationen, wie Jetson, Triton und TensorRT, den Einsatz von Computer Vision Anwendungen vereinfachen.

Dank der jüngsten Fortschritte in der Computer Vision und der künstlichen Intelligenz (KI) treibt das, was einst nur ein Forschungsgebiet war, heute wirkungsvolle Anwendungen in einer Reihe von Branchen voran. Von selbstfahrenden Autos über medizinische Bildgebung bis hin zur Sicherheit lösen Computer-Vision-Systeme reale Probleme in großem Maßstab.

Viele dieser Anwendungen beinhalten die Analyse von Bildern und Videos in Echtzeit, und die Nutzung von Cloud Computing ist aufgrund von Latenz, Kosten und Datenschutzbedenken nicht immer praktikabel. Edge AI ist in diesen Situationen eine großartige Lösung. Durch die Ausführung von Vision-AI-Modellen direkt auf Edge-Geräten können Unternehmen Daten schneller, kostengünstiger und sicherer verarbeiten, wodurch Echtzeit-KI zugänglicher wird.

Während der YOLO Vision 2024 (YV24), der jährlichen Hybrid-Veranstaltung von Ultralytics, war eines der zentralen Themen die Demokratisierung von Vision AI durch eine benutzerfreundlichere und effizientere Bereitstellung. Guy Dahan, Senior Solutions Architect bei NVIDIA, erläuterte, wie NVIDIAHardware- und Softwarelösungen, darunter Edge-Computing-Geräte, Inferenz-Server, Optimierungs-Frameworks und KI-Implementierungs-SDKs, Entwicklern bei der Optimierung von KI im Edge-Bereich helfen.

In diesem Artikel erfahren Sie die wichtigsten Erkenntnisse aus Guy Dahans YV24-Keynote und wie die neuesten Innovationen von NVIDIAdie Bereitstellung von Vision AI schneller und skalierbarer machen.

Guy Dahan begann seinen Vortrag, indem er seine Begeisterung für die Teilnahme an YV24 und sein Interesse an dem Ultralytics Python und den Ultralytics YOLO zum Ausdruck brachte: "Ich benutze Ultralytics seit dem Tag, an dem es herauskam. Ich mag Ultralytics wirklich - ich habe YOLOv5 schon vorher benutzt und bin ein echter Enthusiast dieses Pakets."

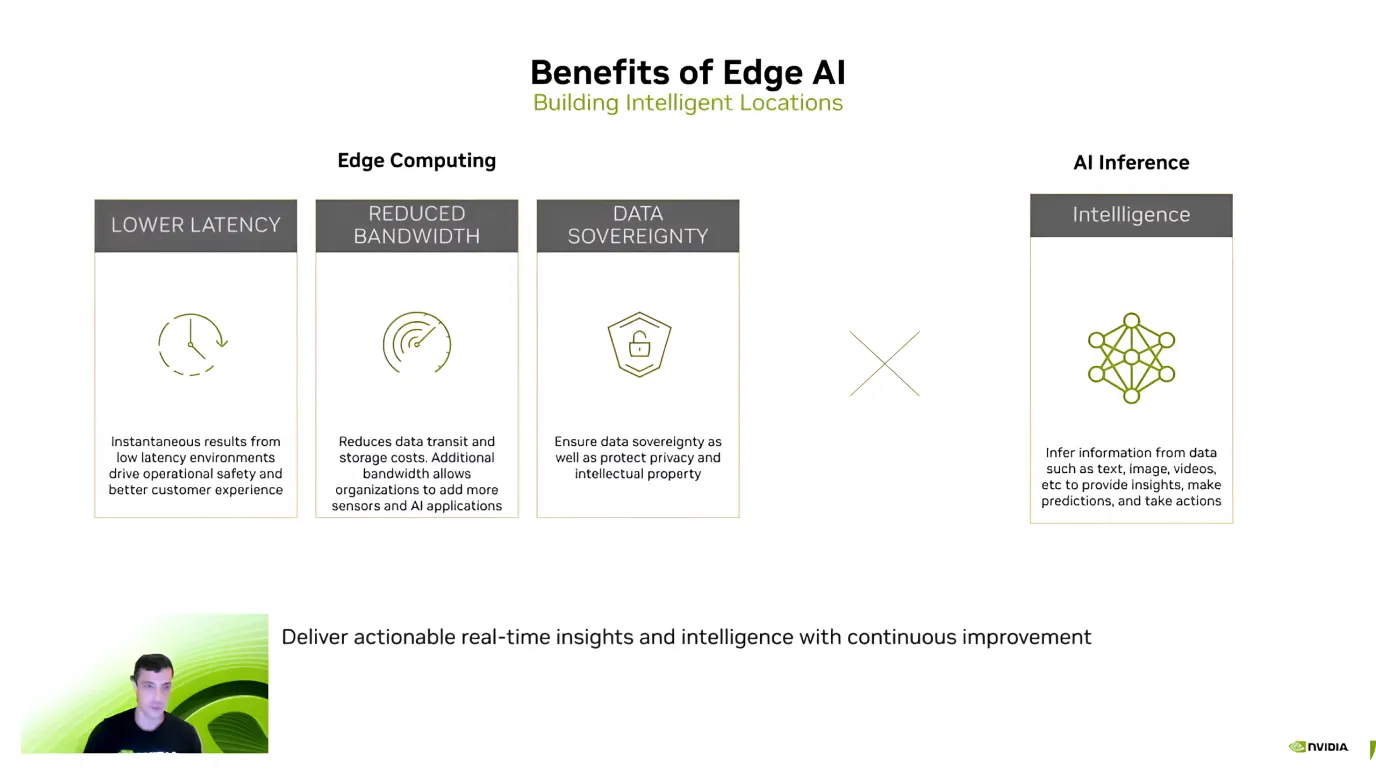

Anschließend führte er das Konzept von Edge AI ein und erklärte, dass es darum geht, KI-Berechnungen direkt auf Geräten wie Kameras, Drohnen oder Industriemaschinen auszuführen, anstatt Daten zur Verarbeitung an entfernte Cloud-Server zu senden.

Anstatt darauf zu warten, dass Bilder oder Videos hochgeladen, analysiert und dann mit Ergebnissen zurückgesendet werden, ermöglicht Edge AI die sofortige Analyse der Daten auf dem Gerät selbst. Dies macht Vision-KI-Systeme schneller, effizienter und weniger abhängig von der Internetverbindung. Edge AI ist besonders nützlich für Echtzeit-Entscheidungsanwendungen wie selbstfahrende Autos, Überwachungskameras und intelligente Fabriken.

Nach der Einführung von Edge AI hob Guy Dahan die wichtigsten Vorteile hervor und konzentrierte sich auf Effizienz, Kosteneinsparungen und Datensicherheit. Er erklärte, dass einer der größten Vorteile die geringe Latenz ist - da KI-Modelle Daten direkt auf dem Gerät verarbeiten, ist es nicht erforderlich, Informationen an die Cloud zu senden und auf eine Antwort zu warten.

Edge AI trägt auch dazu bei, Kosten zu senken und sensible Daten zu schützen. Das Senden großer Datenmengen in die Cloud, insbesondere Videostreams, kann teuer sein. Die lokale Verarbeitung reduziert jedoch die Bandbreiten- und Speicherkosten.

Ein weiterer wichtiger Vorteil ist der Datenschutz, da die Informationen auf dem Gerät verbleiben, anstatt an einen externen Server übertragen zu werden. Dies ist besonders wichtig für Anwendungen im Gesundheitswesen, im Finanzwesen und im Sicherheitsbereich, wo die lokale und sichere Aufbewahrung von Daten oberste Priorität hat.

Aufbauend auf diesen Vorteilen kommentierte Guy Dahan die wachsende Akzeptanz von Edge AI. Er stellte fest, dass sich die Nutzung seit der Einführung von Jetson NVIDIA im Jahr 2014 verzehnfacht hat. Heute arbeiten über 1,2 Millionen Entwickler mit Jetson-Geräten.

Guy Dahan konzentrierte sich dann auf die NVIDIA Jetson-Geräte, eine Familie von KI-Edge-Computing-Geräten, die hohe Leistung bei geringem Stromverbrauch bieten. Jetson-Geräte sind ideal für Computer-Vision-Anwendungen in Bereichen wie Robotik, Landwirtschaft, Gesundheitswesen und industrielle Automatisierung. "Jetsons sind Edge-KI-Geräte, die speziell auf KI zugeschnitten sind. Ich könnte sogar hinzufügen, dass sie ursprünglich vor allem für Computer Vision entwickelt wurden", fügte Guy Dahan hinzu.

Jetson-Geräte gibt es in drei Stufen, die jeweils für unterschiedliche Anforderungen geeignet sind:

Guy Dahan sprach auch über den kommenden Jetson AGX Thor, der noch in diesem Jahr auf den Markt kommen wird, und sagte, dass er die achtfache GPU (Graphics Processing Unit), die doppelte Speicherkapazität und eine verbesserte CPU (Central Processing Unit) bieten wird. Er wurde speziell für die humanoide Robotik und fortschrittliche Edge AI-Anwendungen entwickelt.

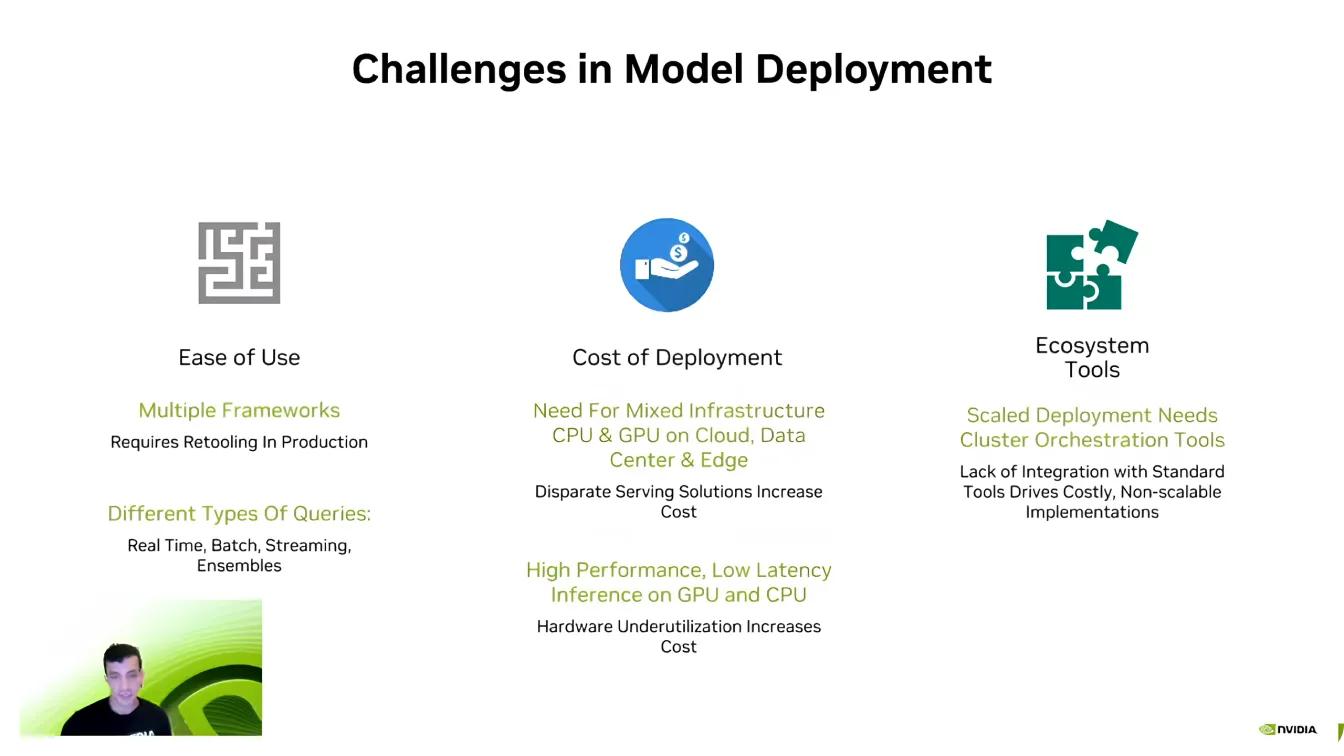

Guy Dahan ging dann dazu über, die Softwareseite von Edge AI zu erörtern, und erklärte, dass selbst mit leistungsstarker Hardware die effiziente Bereitstellung von Modellen eine Herausforderung darstellen kann.

Eine der größten Hürden ist die Kompatibilität, da KI-Entwickler oft mit verschiedenen KI-Frameworks wie PyTorch und TensorFlow arbeiten. Der Wechsel zwischen diesen Frameworks kann sich als schwierig erweisen, da die Entwickler ihre Umgebungen neu erstellen müssen, um sicherzustellen, dass alles korrekt läuft.

Skalierbarkeit ist eine weitere zentrale Herausforderung. KI-Modelle benötigen erhebliche Rechenleistung, und wie Dahan es formulierte: "Es gab noch nie ein KI-Unternehmen, das weniger Rechenleistung wollte." Die Ausweitung von KI-Anwendungen auf mehrere Geräte kann schnell teuer werden, was die Optimierung unerlässlich macht.

KI-Pipelines sind zudem komplex und umfassen oft verschiedene Datentypen, Echtzeitverarbeitung und Systemintegration. Entwickler investieren viel Aufwand, um sicherzustellen, dass ihre Modelle nahtlos mit bestehenden Software-Ökosystemen interagieren. Die Bewältigung dieser Herausforderungen ist ein entscheidender Schritt, um KI-Bereitstellungen effizienter und skalierbarer zu gestalten.

Als nächstes widmete Guy Dahan seine Aufmerksamkeit dem Triton Inference Server von NVIDIA. Er wies darauf hin, dass viele Unternehmen und Start-ups mit der KI-Entwicklung beginnen, ohne ihre Modelle vollständig zu optimieren. Die Neugestaltung einer gesamten KI-Pipeline von Grund auf kann störend und zeitaufwendig sein, was eine effiziente Skalierung erschwert.

Statt einer kompletten Systemüberholung ermöglicht Triton Entwicklern, ihre KI-Workflows schrittweise zu verfeinern und zu optimieren und effizientere Komponenten zu integrieren, ohne ihr bestehendes Setup zu verändern. Durch die Unterstützung mehrerer KI-Frameworks, darunter TensorFlow, PyTorch, ONNX und TensorRT, ermöglicht Triton eine nahtlose Bereitstellung in Cloud-Umgebungen, Rechenzentren und Edge-Geräten mit minimalen Anpassungen.

Hier sind einige der wichtigsten Vorteile von NVIDIA Triton Inference Server:

Nehmen wir an, Sie suchen nach noch mehr Beschleunigung; NVIDIA TensorRT ist eine interessante Option zur Optimierung Ihrer KI-Modelle. Guy Dahan erläuterte, dass TensorRT ein hochleistungsfähiger Deep-Learning-Optimierer ist, der für NVIDIA entwickelt wurde. Modelle aus TensorFlow, PyTorch, ONNX und MXNet können mit TensorRT in hocheffiziente GPU Dateien konvertiert werden.

Was TensorRT so zuverlässig macht, sind seine hardwarespezifischen Optimierungen. Ein für Jetson-Geräte optimiertes Modell wird auf anderen GPUs nicht so effizient arbeiten, weil TensorRT die Leistung auf der Grundlage der Zielhardware fein abstimmt. Ein feinabgestimmtes Computer Vision Modell kann zu einer bis zu 36-fachen Steigerung der Inferenzgeschwindigkeit im Vergleich zu nicht optimierten Modellen führen.

Guy Dahan wies auch auf die Unterstützung Ultralytics für TensorRT hin und erläuterte, wie diese die Bereitstellung von KI-Modellen schneller und effizienter macht. Ultralytics YOLO können direkt in das TensorRT exportiert werden, so dass Entwickler sie für NVIDIA optimieren können, ohne irgendwelche Änderungen vornehmen zu müssen.

Zum Abschluss seines Vortrags stellte Guy Dahan DeepStream 7.0 vor - ein KI-Framework, das für die Echtzeitverarbeitung von Video-, Audio- und Sensordaten mit NVIDIA entwickelt wurde. Es wurde zur Unterstützung von High-Speed-Computer-Vision-Anwendungen entwickelt und ermöglicht Objekterkennung, -verfolgung und -analyse in autonomen Systemen, Sicherheit, Industrieautomatisierung und intelligenten Städten. Da DeepStream KI direkt auf Edge-Geräten ausführt, entfällt die Abhängigkeit von der Cloud, wodurch Latenzzeiten reduziert und die Effizienz verbessert werden.

Insbesondere kann DeepStream die KI-gestützte Videoverarbeitung von Anfang bis Ende übernehmen. Es unterstützt End-to-End-Workflows, von der Videodecodierung und -vorverarbeitung bis hin zur KI-Inferenz und -Nachbearbeitung.

Vor kurzem hat DeepStream mehrere Aktualisierungen eingeführt, um die KI-Bereitstellung zu verbessern und sie zugänglicher und skalierbarer zu machen. Neue Tools vereinfachen die Entwicklung, verbessern die Multi-Kamera-Verfolgung und optimieren KI-Pipelines für eine bessere Leistung.

Entwickler profitieren jetzt von erweitertem Support für Windows-Umgebungen, verbesserten Sensorfusionsfunktionen zur Integration von Daten aus verschiedenen Quellen und dem Zugriff auf vorgefertigte Referenzanwendungen, um die Bereitstellung zu beschleunigen. Diese Verbesserungen machen DeepStream zu einer flexibleren und effizienteren Lösung für KI-Echtzeitanwendungen und helfen Entwicklern, intelligente Videoanalysen problemlos zu skalieren.

Wie Guy Dahan in seiner Keynote auf der YV24 veranschaulichte, definiert Edge AI die Anwendungen von Computer Vision neu. Mit den Fortschritten bei Hard- und Software wird die Echtzeitverarbeitung schneller, effizienter und kostengünstiger.

Da immer mehr Branchen Edge AI einführen, wird die Bewältigung von Herausforderungen wie Fragmentierung und Bereitstellungskomplexität der Schlüssel zur Erschließung ihres vollen Potenzials sein. Die Akzeptanz dieser Innovationen wird intelligentere, reaktionsschnellere KI-Anwendungen vorantreiben und die Zukunft von Computer Vision gestalten.

Werden Sie Teil unserer wachsenden Community! Erkunden Sie unser GitHub-Repository, um mehr über KI zu erfahren, und informieren Sie sich über unsere Lizenzoptionen, um Ihre Vision-AI-Projekte zu starten. Neugierig auf Innovationen wie KI im Gesundheitswesen und Computer Vision in der Fertigung? Besuchen Sie unsere Lösungsseiten, um mehr zu erfahren!