Entdecken Sie OpenAI's neues GPT-4o, mit fortschrittlicher KI und lebensechten Interaktionen, die die Art und Weise verändern, wie wir mit Technologie kommunizieren. Entdecken Sie die bahnbrechenden Funktionen!

Entdecken Sie OpenAI's neues GPT-4o, mit fortschrittlicher KI und lebensechten Interaktionen, die die Art und Weise verändern, wie wir mit Technologie kommunizieren. Entdecken Sie die bahnbrechenden Funktionen!

Am Montag, den 13. Mai 2024, kündigte OpenAI die Einführung seines neuen Vorzeigemodells GPT-4o an, wobei das 'o' für 'omni' steht. GPT-4o ist ein fortschrittliches multimodales KI-Modell für Echtzeit-Text-, Audio- und Visionsinteraktionen, das eine schnellere Verarbeitung, mehrsprachige Unterstützung und erhöhte Sicherheit bietet.

Es bringt nie dagewesene generative KI-Funktionen auf den Tisch. Aufbauend auf den konversationellen Stärken von ChatGPT stellen die Funktionen von GPT-4o einen wesentlichen Fortschritt in der Art und Weise dar, wie Menschen KI wahrnehmen. Wir können jetzt mit GPT-4o sprechen, als wäre er ein echter Mensch. Lassen Sie uns eintauchen und sehen, was GPT-4o alles kann!

Auf dem Frühjahrs-Update von OpenAI wurde bekannt, dass GPT-4o zwar genauso intelligent ist wie GPT-4, aber Daten schneller verarbeiten kann und besser für die Verarbeitung von Text, Bild und Ton geeignet ist. Im Gegensatz zu früheren Versionen, bei denen der Schwerpunkt auf der Verbesserung der Intelligenz der Modelle lag, wurde diese Version unter Berücksichtigung der Notwendigkeit entwickelt, KI für das allgemeine Publikum einfacher zu bedienen.

.png)

Im Sprachmodus von ChatGPT, der Ende letzten Jahres veröffentlicht wurde, kamen drei verschiedene Modelle zusammen, um Spracheingaben zu transkribieren, schriftliche Antworten zu verstehen und zu generieren und Text in Sprache umzuwandeln, damit der Benutzer eine Antwort hören konnte. Dieser Modus hatte mit Latenzproblemen zu kämpfen und wirkte nicht sehr natürlich. GPT-4o kann Text, Bild und Ton in einem Durchgang verarbeiten, um dem Benutzer den Eindruck zu vermitteln, dass er an einem natürlichen Gespräch teilnimmt.

Anders als im Sprachmodus können Sie GPT-4o jetzt unterbrechen, während es spricht, und es reagiert genau wie eine Person. Es pausiert und hört zu und gibt dann seine Echtzeit-Antwort basierend auf dem, was Sie gesagt haben. Es kann auch Emotionen durch seine Stimme ausdrücken und Ihren Tonfall verstehen.

Die Modellevaluierung von GPT-4o zeigt, wie fortschrittlich es ist. Eines der interessantesten Ergebnisse war, dass GPT-4o die Spracherkennung im Vergleich zu Whisper-v3 in allen Sprachen erheblich verbessert, insbesondere in solchen, die weniger verbreitet sind.

Die Audio-ASR-Leistung (Automatic Speech Recognition) misst, wie genau ein Modell gesprochene Sprache in Text transkribiert. Die Leistung von GPT-4o wird anhand der Word Error Rate (WER) verfolgt, die den Prozentsatz der falsch transkribierten Wörter angibt (eine niedrigere WER bedeutet eine bessere Qualität). Die folgende Grafik zeigt die niedrigere WER von GPT-4o in verschiedenen Regionen und demonstriert seine Wirksamkeit bei der Verbesserung der Spracherkennung für Sprachen mit geringeren Ressourcen.

.png)

Hier ist ein Blick auf einige weitere der einzigartigen Funktionen von GPT-4o:

Sie können GPT-4o jetzt auf Ihrem Telefon herausholen, Ihre Kamera einschalten und GPT-4o bitten, wie Sie es einem Freund tun würden, Ihre Stimmung anhand Ihres Gesichtsausdrucks zu erraten. GPT-4o kann Sie durch die Kamera sehen und antworten.

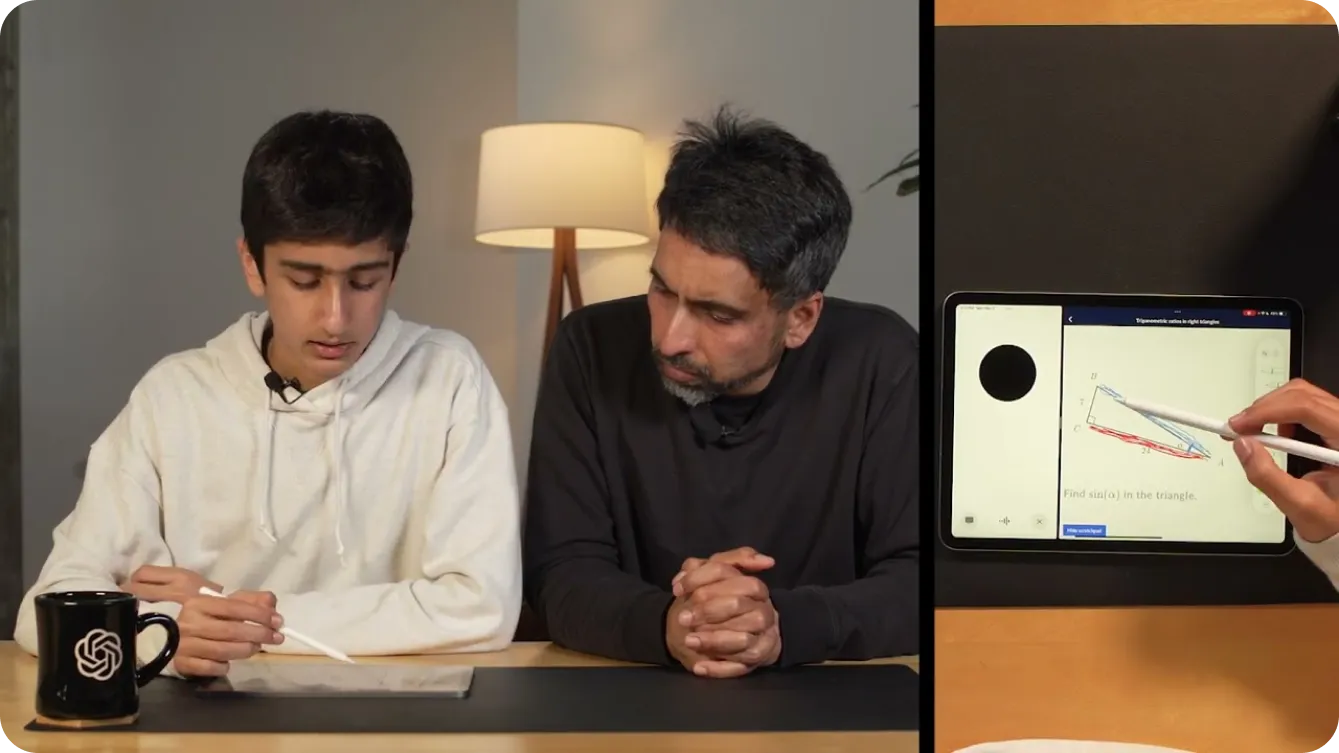

Sie können es sogar verwenden, um mathematische Probleme zu lösen, indem Sie GPT-4o per Video zeigen, was Sie schreiben. Alternativ können Sie Ihren Bildschirm freigeben, und es kann ein hilfreicher Tutor auf Khan Academy werden, der Sie auffordert, verschiedene Teile eines Dreiecks in der Geometrie zu zeigen, wie unten dargestellt.

Neben der Unterstützung von Kindern in Mathematik können Entwickler Gespräche mit GPT-4o führen, um ihren Code zu debuggen. Dies ist dank der Einführung von ChatGPT als Desktop-App möglich. Wenn Sie Ihren Code mit STRG "C" markieren und kopieren, während Sie mit der Desktop-Sprachapplikation GPT-4o sprechen, kann diese Ihren Code lesen. Oder Sie können damit Gespräche zwischen Entwicklern, die verschiedene Sprachen sprechen, übersetzen.

Die Möglichkeiten mit GPT-4o scheinen endlos. Eine der interessantesten Demos von OpenAI verwendete zwei Telefone, um zu zeigen, wie GPT-4o mit verschiedenen Instanzen von sich selbst spricht und zusammen singt.

Wie in einer Demo gezeigt, kann GPT-4o die Welt für Menschen mit Sehbehinderungen zugänglicher machen. Es kann ihnen helfen, sicherer und unabhängiger zu interagieren und sich zu bewegen. Benutzer können beispielsweise ihr Video einschalten und GPT-4o eine Ansicht der Straße zeigen. GPT-4o kann dann Echtzeitbeschreibungen der Umgebung liefern, z. B. Hindernisse identifizieren, Straßenschilder lesen oder sie zu einem bestimmten Ort führen. Es kann ihnen sogar helfen, ein Taxi zu rufen, indem es sie benachrichtigt, wenn sich ein Taxi nähert.

.png)

In ähnlicher Weise kann GPT-4o mit seinen fortschrittlichen Fähigkeiten verschiedene Branchen verändern. Im Einzelhandel kann es den Kundenservice verbessern, indem es Echtzeit-Unterstützung bietet, Fragen beantwortet und Kunden hilft, Produkte online und im Geschäft zu finden. Nehmen wir an, Sie betrachten ein Regal mit Produkten und können das gesuchte Produkt nicht auswählen, GPT-4o kann Ihnen helfen.

Im Gesundheitswesen kann GPT-4o bei der Diagnose helfen, indem es Patientendaten analysiert, mögliche Erkrankungen basierend auf Symptomen vorschlägt und Anleitungen zu Behandlungsoptionen gibt. Es kann auch medizinisches Fachpersonal unterstützen, indem es Patientenakten zusammenfasst, schnellen Zugriff auf medizinische Literatur ermöglicht und sogar eine Echtzeit-Sprachübersetzung anbietet, um mit Patienten zu kommunizieren, die verschiedene Sprachen sprechen. Dies sind nur einige Beispiele. Die Anwendungen von GPT-4o erleichtern das tägliche Leben, indem sie maßgeschneiderte, kontextbezogene Unterstützung bieten und Informations- und Kommunikationsbarrieren abbauen.

Genau wie die vorherigen Versionen von GPT, die Hunderte Millionen von Leben beeinflusst haben, wird GPT-4o wahrscheinlich weltweit mit Echtzeit-Audio und -Video interagieren, was die Sicherheit zu einem entscheidenden Element in diesen Anwendungen macht. OpenAI hat sehr darauf geachtet, GPT-4o mit einem Fokus auf die Minderung potenzieller Risiken zu entwickeln.

Um Sicherheit und Zuverlässigkeit zu gewährleisten, hat OpenAI strenge Sicherheitsmaßnahmen implementiert. Dazu gehören das Filtern von Trainingsdaten, die Verfeinerung des Modellverhaltens nach dem Training und die Integration neuer Sicherheitssysteme für die Verwaltung von Sprachausgaben. Darüber hinaus wurde GPT-4o von über 70 externen Experten in Bereichen wie Sozialpsychologie, Voreingenommenheit und Fairness sowie Fehlinformationen umfassend getestet. Externe Tests stellen sicher, dass alle Risiken, die durch die neuen Funktionen eingeführt oder verstärkt werden, identifiziert und behoben werden.

Um hohe Sicherheitsstandards aufrechtzuerhalten, veröffentlicht OpenAI die Funktionen von GPT-4o schrittweise über die nächsten Wochen. Ein phasenweiser Rollout ermöglicht es OpenAI, die Leistung zu überwachen, alle Probleme zu beheben und Benutzerfeedback zu sammeln. Ein sorgfältiger Ansatz stellt sicher, dass GPT-4o fortschrittliche Funktionen bietet und gleichzeitig die höchsten Standards für Sicherheit und ethische Nutzung einhält.

GPT-4o ist für den kostenlosen Zugang verfügbar. Um die oben erwähnten Echtzeit-Unterhaltungsmöglichkeiten auszuprobieren, können Sie die ChatGPT aus dem Google Play Store oder dem Apple App Store direkt auf Ihr Telefon herunterladen.

Nach der Anmeldung können Sie GPT-4o aus der angezeigten Liste auswählen, indem Sie auf die drei Punkte in der oberen rechten Ecke des Bildschirms tippen. Nachdem Sie zu einem Chat navigiert haben, der mit GPT-4o aktiviert ist, sehen Sie mehrere Eingabeoptionen, wenn Sie auf das Pluszeichen in der unteren linken Ecke des Bildschirms tippen. In der unteren rechten Ecke des Bildschirms sehen Sie ein Kopfhörersymbol. Wenn Sie auf das Kopfhörersymbol tippen, werden Sie gefragt, ob Sie eine Freisprechversion von GPT-4o ausprobieren möchten. Nach der Zustimmung können Sie GPT-4o ausprobieren, wie unten gezeigt.

Wenn Sie die fortschrittlichen Funktionen von GPT-4o in Ihre eigenen Projekte integrieren möchten, ist es als API für Entwickler verfügbar. Es ermöglicht Ihnen, die leistungsstarke Spracherkennung, die mehrsprachige Unterstützung und die Echtzeit-Konversationsfähigkeiten von GPT-4o in Ihre Anwendungen zu integrieren. Durch die Verwendung der API können Sie Benutzererlebnisse verbessern, intelligentere Apps entwickeln und modernste KI-Technologie in verschiedene Sektoren bringen.

Obwohl GPT-4o weitaus fortschrittlicher ist als frühere KI-Modelle, darf man nicht vergessen, dass GPT-4o auch seine eigenen Grenzen hat. OpenAI hat erwähnt, dass es manchmal zufällig die Sprache wechselt, während es spricht, von English zu Französisch. Es wurde auch beobachtet, dass GPT-4o nicht korrekt zwischen Sprachen übersetzt. Je mehr Leute das Modell ausprobieren, desto besser werden wir verstehen, wo GPT-4o seine Stärken hat und wo es noch verbessert werden muss.

GPT-4o von OpenAI eröffnet neue Türen für KI mit seiner fortschrittlichen Text-, Bild- und Audioverarbeitung und bietet natürliche, menschenähnliche Interaktionen. Es zeichnet sich durch Geschwindigkeit, Kosteneffizienz und mehrsprachige Unterstützung aus. GPT-4o ist ein vielseitiges Werkzeug für Bildung, Barrierefreiheit und Echtzeitunterstützung. Während Benutzer die Fähigkeiten von GPT-4o erkunden, wird Feedback seine Entwicklung vorantreiben. GPT-4o beweist, dass KI unsere Welt wirklich verändert und Teil unseres täglichen Lebens wird.

Entdecken Sie unser GitHub-Repository und treten Sie unserer Community bei, um tiefer in die KI einzutauchen. Besuchen Sie unsere Lösungsseiten, um zu sehen, wie KI Branchen wie Fertigung und Landwirtschaft verändert.