Erfahren Sie mehr über RCNN und seinen Einfluss auf die Objekterkennung. Wir behandeln seine Schlüsselkomponenten, Anwendungen und seine Rolle bei der Weiterentwicklung von Techniken wie Fast RCNN und YOLO.

Erfahren Sie mehr über RCNN und seinen Einfluss auf die Objekterkennung. Wir behandeln seine Schlüsselkomponenten, Anwendungen und seine Rolle bei der Weiterentwicklung von Techniken wie Fast RCNN und YOLO.

Die Objekterkennung ist eine Aufgabe der Computer Vision, die Objekte in Bildern oder Videos für Anwendungen wie autonomes Fahren, Überwachung und medizinische Bildgebung erkennen und lokalisieren kann. Frühere Methoden zur Objekterkennung, wie der Viola-Jones-Detektor und das Histogramm der orientierten Gradienten (HOG) mit Support Vector Machines (SVM), stützten sich auf handgefertigte Merkmale und gleitende Fenster. Diese Methoden hatten oft Schwierigkeiten, Objekte in komplexen Szenen mit mehreren Objekten unterschiedlicher Form und Größe genau detect .

Regionale Faltungsneuronale Netze (R-CNN) haben die Art und Weise, wie wir die Objekterkennung angehen, verändert. Es ist ein wichtiger Meilenstein in der Geschichte der Computer Vision. Um zu verstehen, wie Modelle wie YOLOv8 zustande gekommen sind, müssen wir zunächst Modelle wie R-CNN verstehen.

Die von Ross Girshick und seinem Team entwickelte R-CNN-Modellarchitektur generiert Regionenvorschläge, extrahiert Merkmale mit einem vortrainierten Convolutional Neural Network (CNN), klassifiziert Objekte und verfeinert Begrenzungsrahmen. Das mag zwar entmutigend erscheinen, aber am Ende dieses Artikels werden Sie ein klares Verständnis davon haben, wie R-CNN funktioniert und warum es so wirkungsvoll ist. Werfen wir einen Blick darauf!

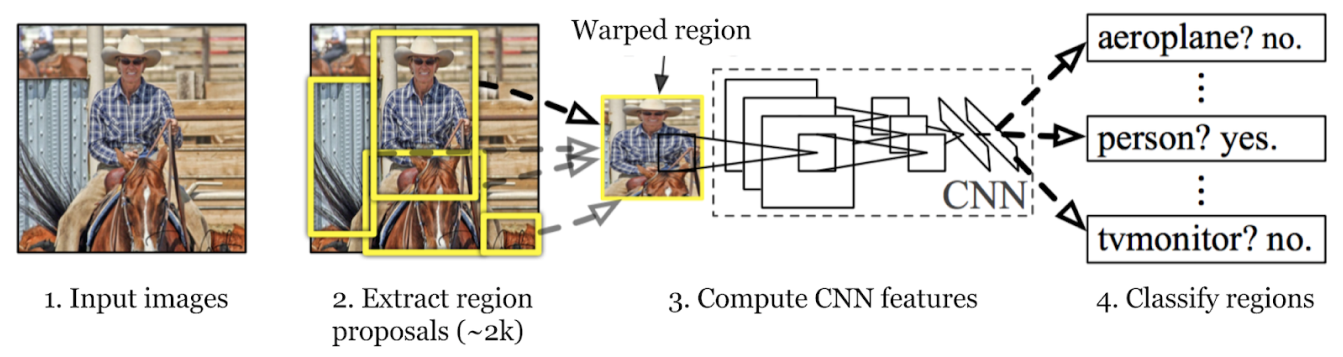

Der Objekterkennungsprozess des R-CNN-Modells umfasst drei Hauptschritte: Generierung von Regionsvorschlägen, Extraktion von Merkmalen und Klassifizierung von Objekten unter gleichzeitiger Verfeinerung ihrer Begrenzungsrahmen. Gehen wir jeden Schritt durch.

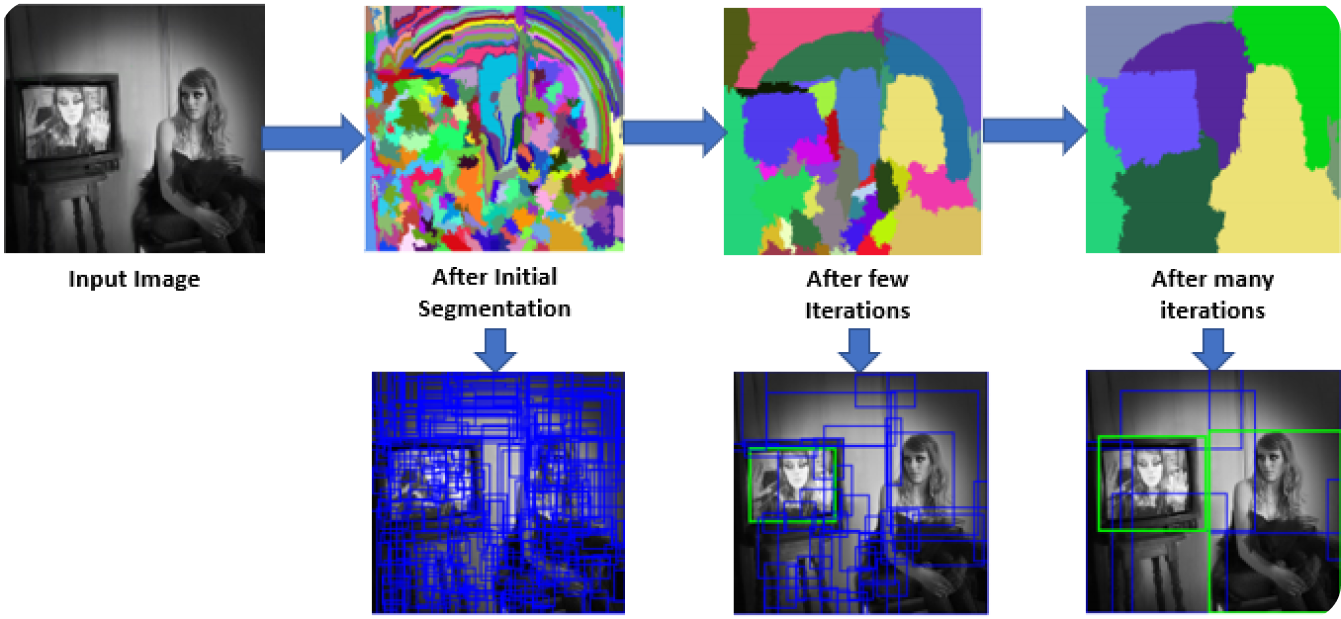

Im ersten Schritt scannt das R-CNN-Modell das Bild, um zahlreiche Regionenvorschläge zu erstellen. Regionenvorschläge sind potenzielle Bereiche, die Objekte enthalten könnten. Methoden wie Selective Search werden verwendet, um verschiedene Aspekte des Bildes zu betrachten, wie z. B. Farbe, Textur und Form, und es in verschiedene Teile zu zerlegen. Selective Search beginnt damit, das Bild in kleinere Teile zu unterteilen und dann ähnliche Teile zusammenzuführen, um größere Interessengebiete zu bilden. Dieser Prozess wird fortgesetzt, bis etwa 2.000 Regionenvorschläge generiert sind.

Diese Regionenvorschläge helfen dabei, alle möglichen Stellen zu identifizieren, an denen sich ein Objekt befinden könnte. In den folgenden Schritten kann das Modell die relevantesten Bereiche effizient verarbeiten, indem es sich auf diese spezifischen Bereiche und nicht auf das gesamte Bild konzentriert. Die Verwendung von Regionenvorschlägen sorgt für ein Gleichgewicht zwischen Gründlichkeit und Recheneffizienz.

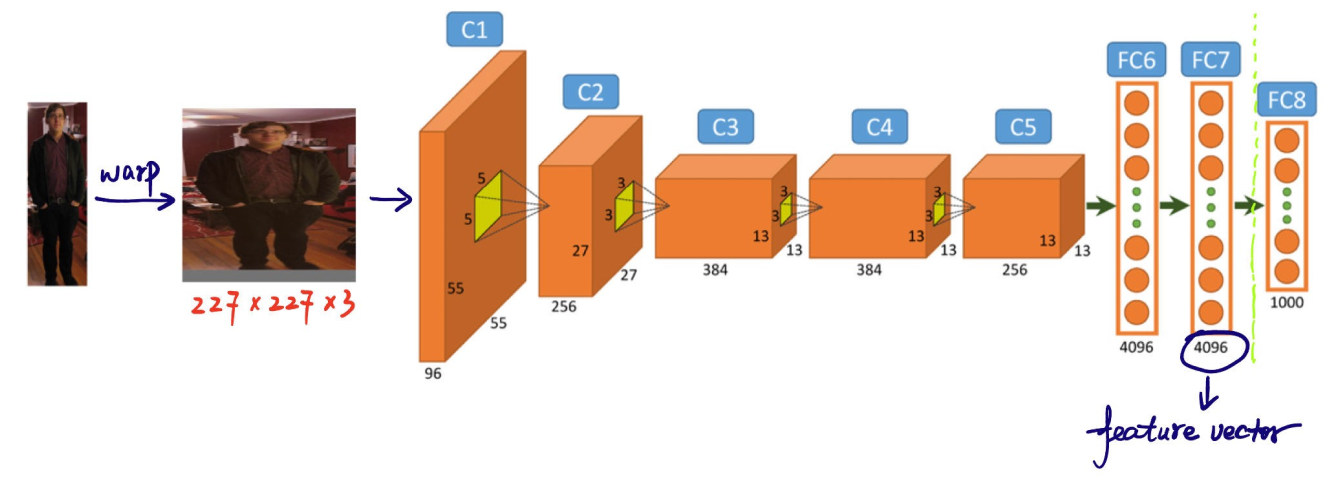

Der nächste Schritt im Objekterkennungsprozess des R-CNN-Modells ist das Extrahieren von Merkmalen aus Regionsvorschlägen. Jeder Regionsvorschlag wird auf eine einheitliche Größe skaliert, die die CNN erwartet (z. B. 224x224 Pixel). Die Größenänderung hilft der CNN, jeden Vorschlag effizient zu verarbeiten. Vor dem Warping wird die Größe jedes Regionsvorschlags leicht erweitert, um 16 Pixel zusätzlichen Kontext um die Region herum einzubeziehen, um mehr Umgebungsinformationen für eine bessere Merkmalsextraktion bereitzustellen.

Nach der Größenänderung werden diese Regionsvorschläge in ein CNN wie AlexNet eingespeist, das in der Regel auf einem großen Datensatz wie ImageNet vortrainiert wird. Das CNN verarbeitet jede Region, um hochdimensionale Merkmalsvektoren zu extrahieren, die wichtige Details wie Kanten, Texturen und Muster erfassen. Diese Merkmalsvektoren fassen die wesentlichen Informationen aus den Regionen zusammen. Sie transformieren die rohen Bilddaten in ein Format, das das Modell für die weitere Analyse verwenden kann. Die genaue Klassifizierung und Lokalisierung von Objekten in den nächsten Schritten hängt von dieser entscheidenden Umwandlung der visuellen Informationen in aussagekräftige Daten ab.

Der dritte Schritt besteht darin, die Objekte innerhalb dieser Regionen classify . Dies bedeutet, dass die Kategorie oder Klasse jedes in den Vorschlägen gefundenen Objekts bestimmt wird. Die extrahierten Merkmalsvektoren werden dann durch einen Klassifikator für maschinelles Lernen geleitet.

Im Fall von R-CNN werden häufig Support Vector Machines (SVMs) für diesen Zweck verwendet. Jede SVM wird trainiert, um eine bestimmte Objektklasse zu erkennen, indem sie die Feature-Vektoren analysiert und entscheidet, ob eine bestimmte Region eine Instanz dieser Klasse enthält. Im Wesentlichen gibt es für jede Objektkategorie einen dedizierten Klassifikator, der jeden Regionenvorschlag auf dieses spezifische Objekt überprüft.

Während des Trainings erhalten die Klassifikatoren gelabelte Daten mit positiven und negativen Beispielen:

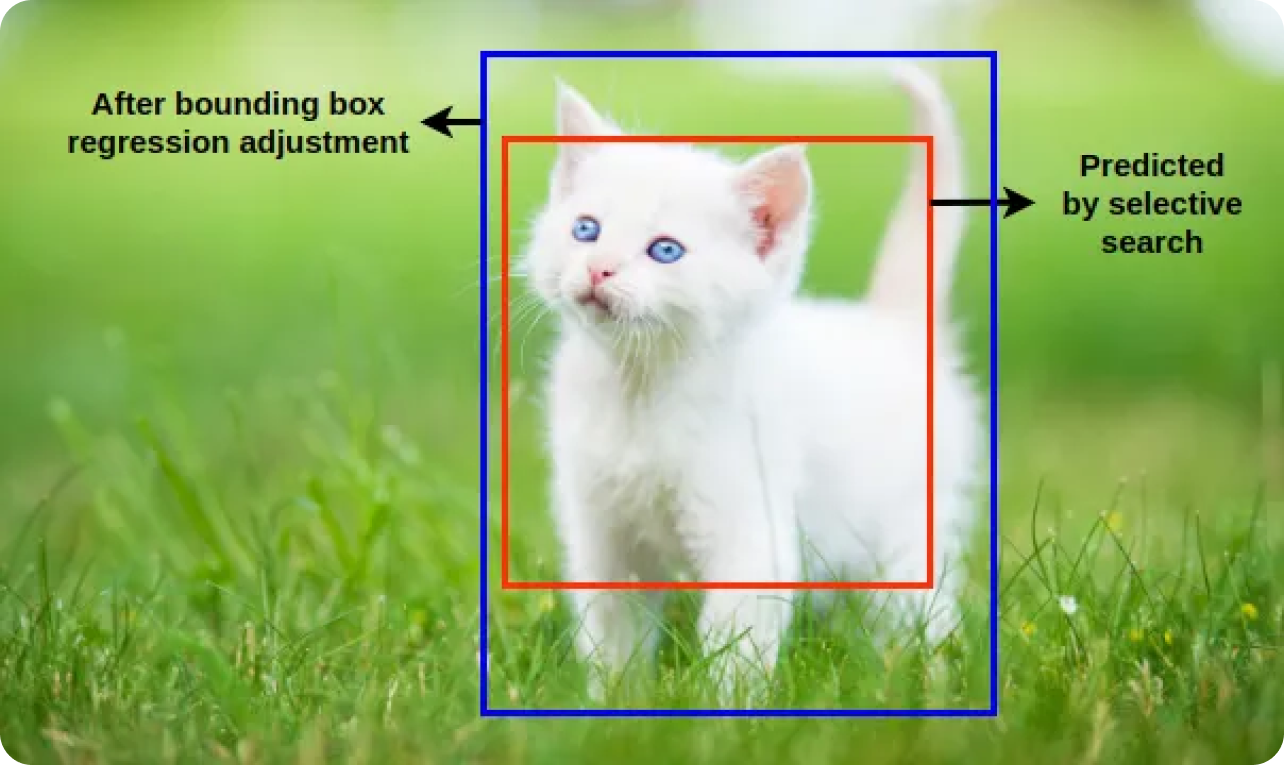

Die Klassifikatoren lernen, zwischen diesen Stichproben zu unterscheiden. Die Bounding-Box-Regression verfeinert ferner die Position und Größe erkannter Objekte, indem sie die anfänglich vorgeschlagenen Bounding Boxes anpasst, um sie besser an die tatsächlichen Objektgrenzen anzupassen. Das R-CNN-Modell kann Objekte durch die Kombination von Klassifizierung und Bounding-Box-Regression identifizieren und genau lokalisieren.

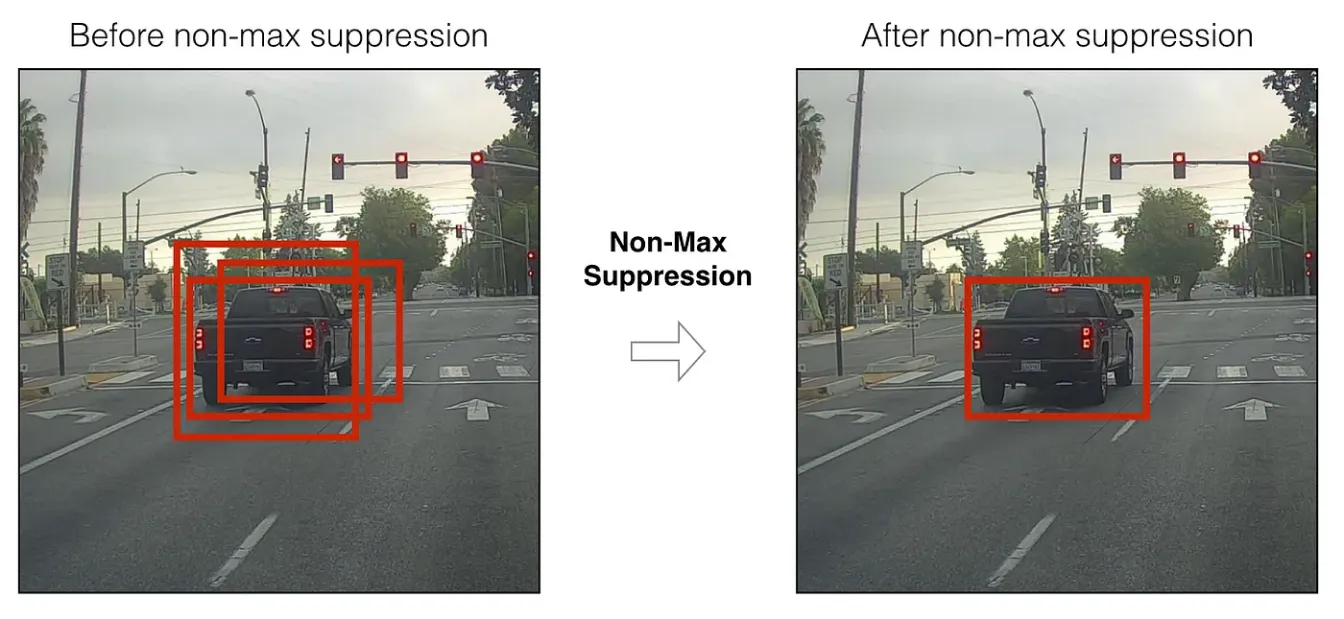

Nach der Klassifizierung und der Regression des Begrenzungsrahmens erzeugt das Modell oft mehrere sich überschneidende Begrenzungsrahmen für dasselbe Objekt. Non-Maximum SuppressionNMS) wird angewandt, um diese Erkennungen zu verfeinern und die genauesten Boxen zu behalten. Das Modell eliminiert redundante und überlappende Boxen durch Anwendung von NMS und behält nur die sichersten Erkennungen bei.

Bei NMS werden die Konfidenzwerte (die angeben, wie wahrscheinlich es ist, dass ein erkanntes Objekt tatsächlich vorhanden ist) aller Bounding Boxes ausgewertet und diejenigen unterdrückt, die sich erheblich mit Boxen mit höheren Werten überschneiden.

Hier finden Sie eine Aufschlüsselung der Schritte in den NMS:

Zusammenfassend lässt sich sagen, dass das R-CNN-Modell Objekte erkennt, indem es Regionsvorschläge generiert, Merkmale mit einem CNN extrahiert, Objekte klassifiziert und ihre Positionen mit Bounding-Box-Regression verfeinert und mit Non-Maximum SuppressionNMS) nur die genauesten Erkennungen behält.

R-CNN ist ein wegweisendes Modell in der Geschichte der Objekterkennung, da es einen neuen Ansatz einführte, der die Genauigkeit und Leistung erheblich verbesserte. Vor R-CNN hatten Objekterkennungsmodelle Schwierigkeiten, Geschwindigkeit und Präzision in Einklang zu bringen. Die R-CNN-Methode zur Generierung von Regionsvorschlägen und die Verwendung von CNNs zur Merkmalsextraktion ermöglichen eine präzise Lokalisierung und Identifizierung von Objekten innerhalb von Bildern.

R-CNN ebnete den Weg für Modelle wie Fast R-CNN, Faster R-CNN und Mask R-CNN, die Effizienz und Genauigkeit weiter verbesserten. Durch die Kombination von Deep Learning mit regionenbasierter Analyse setzte R-CNN einen neuen Standard in diesem Bereich und eröffnete Möglichkeiten für verschiedene Anwendungen in der realen Welt.

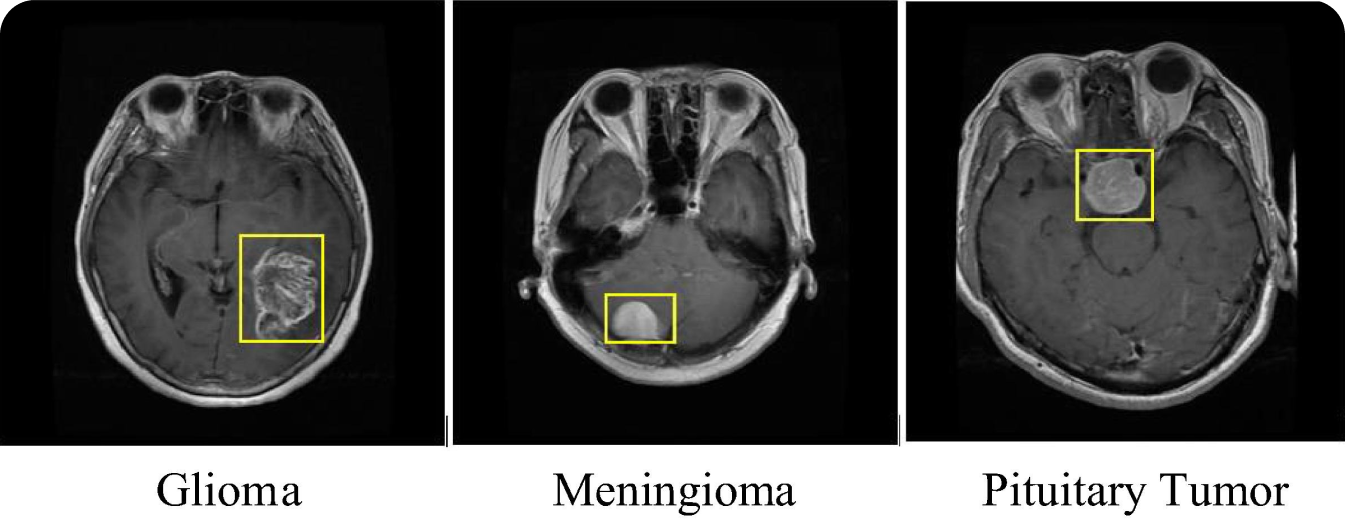

Ein interessanter Anwendungsfall von R-CNN ist die medizinische Bildgebung. R-CNN-Modelle wurden zur detect und classify verschiedener Tumorarten, z. B. von Hirntumoren, in medizinischen Scans wie MRT- und CT-Scans verwendet. Der Einsatz des R-CNN-Modells in der medizinischen Bildgebung verbessert die Diagnosegenauigkeit und hilft Radiologen, bösartige Erkrankungen in einem frühen Stadium zu erkennen. Die Fähigkeit von R-CNN, selbst kleine und frühe Tumore detect , kann einen bedeutenden Unterschied bei der Behandlung und Prognose von Krankheiten wie Krebs ausmachen.

Das R-CNN-Modell kann neben der Tumorerkennung auch für andere Aufgaben der medizinischen Bildgebung eingesetzt werden. Es kann zum Beispiel Frakturen identifizieren, Netzhauterkrankungen in Augenscans detect und Lungenbilder auf Krankheiten wie Lungenentzündung und COVID-19 analysieren. Unabhängig vom medizinischen Problem kann eine frühzeitige Erkennung zu besseren Behandlungsergebnissen führen. Durch die Anwendung der Präzision von R-CNN bei der Identifizierung und Lokalisierung von Anomalien können Gesundheitsdienstleister die Zuverlässigkeit und Geschwindigkeit der medizinischen Diagnostik verbessern. Da die Objekterkennung den Diagnoseprozess rationalisiert, können die Patienten von rechtzeitigen und genauen Behandlungsplänen profitieren.

Obwohl R-CNN beeindruckend ist, hat es bestimmte Nachteile, wie z. B. eine hohe Rechenkomplexität und langsame Inferenzzeiten. Diese Nachteile machen das R-CNN-Modell für Echtzeitanwendungen ungeeignet. Die Trennung von Regionenvorschlägen und Klassifizierungen in separate Schritte kann zu einer weniger effizienten Leistung führen.

Im Laufe der Jahre sind verschiedene Modelle zur Objekterkennung entstanden, die diese Bedenken ausgeräumt haben. Fast R-CNN kombiniert Regionenvorschläge und CNN-Merkmalsextraktion in einem einzigen Schritt, wodurch der Prozess beschleunigt wird. Faster R-CNN führt ein Region Proposal Network (RPN) ein, um die Vorschlagserzeugung zu rationalisieren, während Mask R-CNN eine Segmentierung auf Pixelebene für detailliertere Erkennungen hinzufügt.

Etwa zur gleichen Zeit wie Faster R-CNN begann die YOLO (You Only Look Once) mit der Weiterentwicklung der Objekterkennung in Echtzeit. YOLO sagen Bounding Boxes und Klassenwahrscheinlichkeiten in einem einzigen Durchgang durch das Netzwerk voraus. Zum Beispiel die Ultralytics YOLOv8 bietet verbesserte Genauigkeit und Geschwindigkeit mit erweiterten Funktionen für viele Computer-Vision-Aufgaben.

RCNN veränderte das Spiel in der Computer Vision und zeigte, wie Deep Learning die Objekterkennung verändern kann. Sein Erfolg inspirierte viele neue Ideen in diesem Bereich. Auch wenn neuere Modelle wie Faster R-CNN und YOLO die Schwächen von RCNN beheben, ist sein Beitrag ein wichtiger Meilenstein, an den man sich erinnern sollte.

Mit der Weiterentwicklung der Forschung werden wir noch bessere und schnellere Modelle zur Objekterkennung sehen. Diese Fortschritte werden nicht nur das Verständnis der Maschinen von der Welt verbessern, sondern auch in vielen Branchen zu Fortschritten führen. Die Zukunft der Objekterkennung sieht vielversprechend aus!

Möchten Sie weiter über AI forschen? Werden Sie Teil derUltralytics-Community! Erkunden Sie unser GitHub-Repository, um unsere neuesten Innovationen im Bereich der künstlichen Intelligenz kennenzulernen. Sehen Sie sich unsere KI-Lösungen für verschiedene Sektoren wie Landwirtschaft und Fertigung an. Schließen Sie sich uns an, um zu lernen und voranzukommen!