Distribuzione di applicazioni di computer vision su dispositivi edge AI

Scoprite come Edge AI e le innovazioni di NVIDIA, come Jetson, Triton e TensorRT, stanno semplificando l'implementazione delle applicazioni di computer vision.

Scoprite come Edge AI e le innovazioni di NVIDIA, come Jetson, Triton e TensorRT, stanno semplificando l'implementazione delle applicazioni di computer vision.

Grazie ai recenti progressi nella computer vision e nell'intelligenza artificiale (IA), quella che una volta era solo un campo di ricerca sta ora guidando applicazioni di grande impatto in una vasta gamma di settori. Dalle auto a guida autonoma all'imaging medicale e alla sicurezza, i sistemi di computer vision stanno risolvendo problemi reali su vasta scala.

Molte di queste applicazioni comportano l'analisi di immagini e video in tempo reale e l'affidamento al cloud computing non è sempre pratico a causa della latenza, dei costi e dei problemi di privacy. L'Edge AI è un'ottima soluzione in queste situazioni. Eseguendo i modelli di Vision AI direttamente sui dispositivi edge, le aziende possono elaborare i dati più velocemente, in modo più economico e con maggiore sicurezza, rendendo l'IA in tempo reale più accessibile.

Durante YOLO Vision 2024 (YV24), l'evento ibrido annuale ospitato da Ultralytics, uno dei temi centrali è stato la democratizzazione dell'IA di Vision rendendo la distribuzione più semplice ed efficiente. Guy Dahan, Senior Solutions Architect di NVIDIA, ha illustrato come le soluzioni hardware e software di NVIDIA, fra cui i dispositivi di edge computing, i server di inferenza, i framework di ottimizzazione e gli SDK per l'implementazione dell'IA, stiano aiutando gli sviluppatori a ottimizzare l'IA nell'edge.

In questo articolo analizzeremo i punti salienti del keynote di Guy Dahan all'YV24 e come le ultime innovazioni di NVIDIAstiano rendendo l'implementazione di Vision AI più rapida e scalabile.

Guy Dahan ha iniziato il suo intervento esprimendo il suo entusiasmo per essersi unito virtualmente a YV24 e il suo interesse per il pacchetto Ultralytics Python e imodelliYOLO Ultralytics , affermando: "Uso Ultralytics dal giorno in cui è uscito. Mi piace molto Ultralytics - ho usato YOLOv5 anche prima, e sono un vero appassionato di questo pacchetto".

Poi, ha introdotto il concetto di Edge AI, spiegando che implica l'esecuzione di calcoli di IA direttamente su dispositivi come telecamere, droni o macchine industriali, invece di inviare i dati a server cloud distanti per l'elaborazione.

Invece di aspettare che immagini o video vengano caricati, analizzati e quindi rispediti con i risultati, Edge AI rende possibile analizzare i dati istantaneamente sul dispositivo stesso. Ciò rende i sistemi Vision AI più veloci, più efficienti e meno dipendenti dalla connettività Internet. Edge AI è particolarmente utile per applicazioni di processo decisionale in tempo reale, come auto a guida autonoma, telecamere di sicurezza e fabbriche intelligenti.

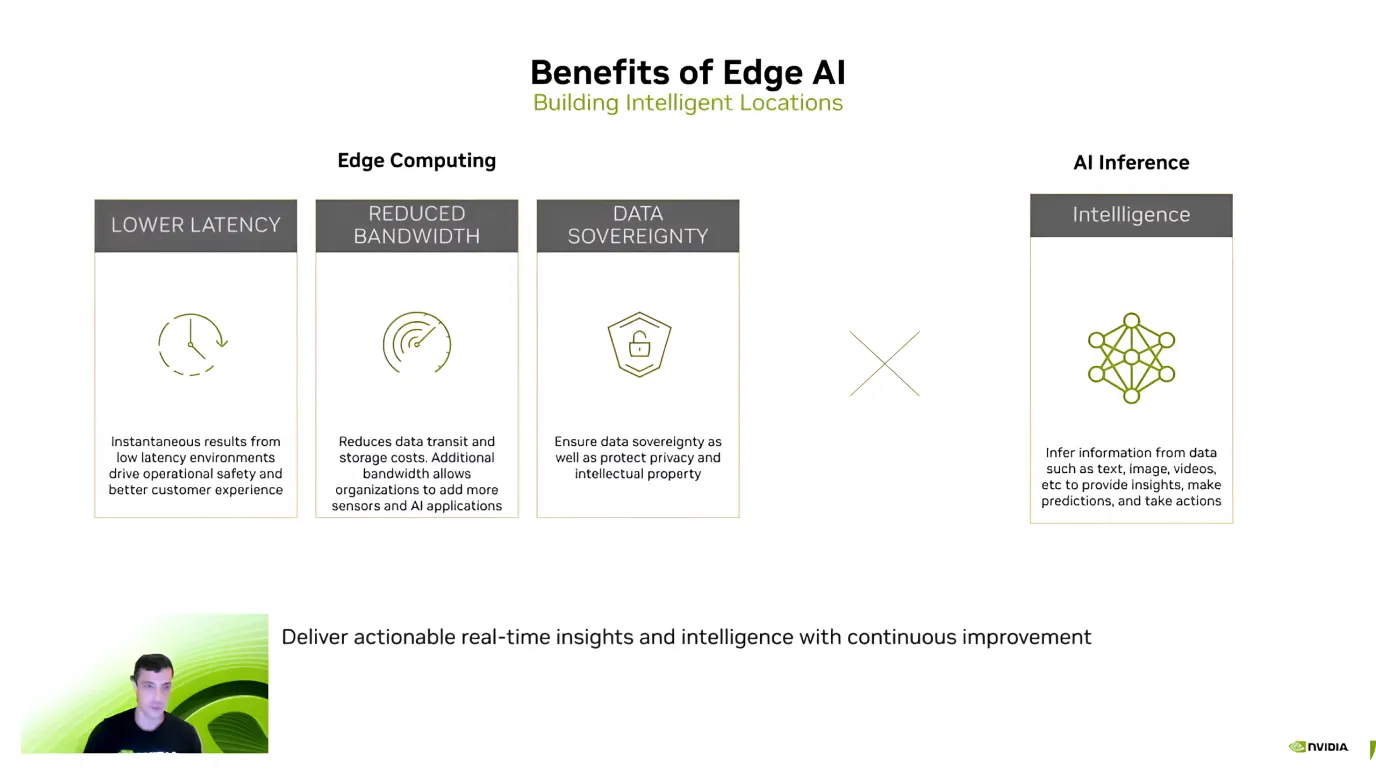

Dopo aver introdotto l'Edge AI, Guy Dahan ha evidenziato i suoi principali vantaggi, concentrandosi su efficienza, risparmio sui costi e sicurezza dei dati. Ha spiegato che uno dei maggiori vantaggi è la bassa latenza: poiché i modelli di AI elaborano i dati direttamente sul dispositivo, non è necessario inviare informazioni al cloud e attendere una risposta.

L'Edge AI aiuta anche a ridurre i costi e a proteggere i dati sensibili. L'invio di grandi quantità di dati al cloud, specialmente i flussi video, può essere costoso. Tuttavia, l'elaborazione locale riduce i costi di larghezza di banda e di archiviazione.

Un altro vantaggio fondamentale è la privacy dei dati, poiché le informazioni rimangono sul dispositivo invece di essere trasferite a un server esterno. Questo è particolarmente importante per le applicazioni sanitarie, finanziarie e di sicurezza, dove mantenere i dati locali e sicuri è una priorità assoluta.

Basandosi su questi vantaggi, Guy Dahan ha commentato la crescente adozione di Edge AI. Ha fatto notare che da quando NVIDIA ha introdotto Jetson nel 2014, l'utilizzo è decuplicato. Oggi, oltre 1,2 milioni di sviluppatori lavorano con i dispositivi Jetson.

Guy Dahan si è poi soffermato sui dispositiviNVIDIA Jetson, una famiglia di dispositivi di AI edge computing progettati per offrire prestazioni elevate con un consumo energetico ridotto. I dispositivi Jetson sono ideali per le applicazioni di visione artificiale in settori come la robotica, l'agricoltura, la sanità e l'automazione industriale. "I Jetson sono dispositivi Edge AI fatti su misura per l'AI. Potrei anche aggiungere che in origine erano stati progettati soprattutto per la computer vision", ha aggiunto Guy Dahan.

I dispositivi Jetson sono disponibili in tre livelli, ognuno adatto a esigenze diverse:

Guy Dahan ha inoltre parlato dell'imminente Jetson AGX Thor, che verrà lanciato quest'anno, e ha dichiarato che offrirà prestazioni della GPU (Graphics Processing Unit) otto volte superiori, una capacità di memoria doppia e prestazioni CPU (Central Processing Unit) migliorate. È stato progettato specificamente per la robotica umanoide e per le applicazioni Edge AI avanzate.

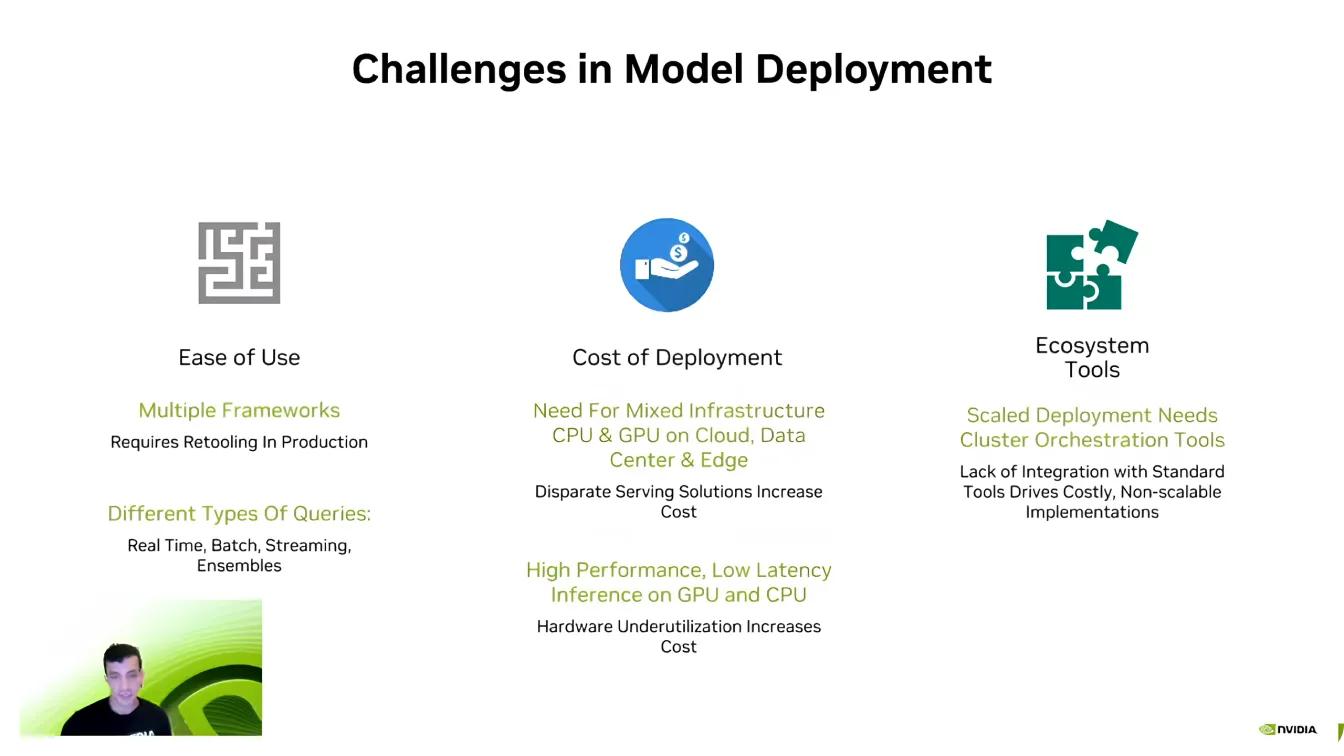

Guy Dahan si è poi concentrato sulla parte software dell'Edge AI e ha spiegato che, anche con hardware potente, l'implementazione efficiente dei modelli può essere impegnativa.

Uno dei maggiori ostacoli è la compatibilità, in quanto gli sviluppatori di IA lavorano spesso con framework di IA diversi, come PyTorch e TensorFlow. Passare da un framework all'altro può essere difficile e richiede agli sviluppatori di ricreare ambienti per garantire che tutto funzioni correttamente.

La scalabilità è un'altra sfida fondamentale. I modelli di AI richiedono una notevole potenza di calcolo e, come ha affermato Dahan, "Non c'è mai stata un'azienda di AI che desiderasse meno potenza di calcolo". L'espansione delle applicazioni di AI su più dispositivi può rapidamente diventare costosa, rendendo essenziale l'ottimizzazione.

Inoltre, le pipeline di IA sono complesse e spesso coinvolgono diversi tipi di dati, elaborazione in tempo reale e integrazione di sistemi. Gli sviluppatori si impegnano molto per garantire che i loro modelli interagiscano senza problemi con gli ecosistemi software esistenti. Superare queste sfide è fondamentale per rendere le implementazioni di IA più efficienti e scalabili.

Guy Dahan ha poi rivolto la sua attenzione a Triton Inference Server di NVIDIA. Ha sottolineato che molte aziende e startup iniziano lo sviluppo dell'IA senza ottimizzare completamente i loro modelli. Riprogettare da zero un'intera pipeline di IA può essere disruptive e richiedere molto tempo, rendendo difficile scalare in modo efficiente.

Invece di richiedere una revisione completa del sistema, Triton consente agli sviluppatori di perfezionare e ottimizzare gradualmente i loro flussi di lavoro AI, integrando componenti più efficienti senza interrompere la configurazione esistente. Grazie al supporto di diversi framework di IA, tra cui TensorFlow, PyTorch, ONNX e TensorRT, Triton consente una distribuzione senza soluzione di continuità in ambienti cloud, data center e dispositivi edge con adeguamenti minimi.

Ecco alcuni dei principali vantaggi di Triton Inference Server di NVIDIA:

Supponiamo che siate alla ricerca di un'accelerazione ancora maggiore; NVIDIA TensorRT è un'opzione interessante per ottimizzare i modelli di intelligenza artificiale. Guy Dahan ha spiegato che TensorRT è un ottimizzatore di deep learning ad alte prestazioni costruito per le GPU NVIDIA . I modelli di TensorFlow, PyTorch, ONNX e MXNet possono essere convertiti in file GPU ad alta efficienza grazie a TensorRT.

Ciò che rende TensorRT così affidabile è la sua ottimizzazione specifica per l'hardware. Un modello ottimizzato per i dispositivi Jetson non funzionerà in modo altrettanto efficiente su altre GPU, perché TensorRT ottimizza le prestazioni in base all'hardware di destinazione. Un modello di computer vision ottimizzato può aumentare la velocità di inferenza fino a 36 volte rispetto ai modelli non ottimizzati.

Guy Dahan ha anche richiamato l'attenzione sul supporto di Ultralytics per TensorRT, parlando di come questo renda la distribuzione dei modelli di intelligenza artificiale più rapida ed efficiente. I modelliYOLO Ultralytics possono essere esportati direttamente in formato TensorRT , consentendo agli sviluppatori di ottimizzarli per le GPU NVIDIA senza dover apportare alcuna modifica.

Per concludere in bellezza, Guy Dahan ha presentato DeepStream 7.0, un framework di intelligenza artificiale progettato per l'elaborazione in tempo reale di dati video, audio e sensori utilizzando le GPU NVIDIA . Realizzato per supportare applicazioni di computer vision ad alta velocità, consente il rilevamento, il tracciamento e l'analisi di oggetti in sistemi autonomi, sicurezza, automazione industriale e città intelligenti. Eseguendo l'intelligenza artificiale direttamente sui dispositivi edge, DeepStream elimina la dipendenza dal cloud, riducendo la latenza e migliorando l'efficienza.

Nello specifico, DeepStream è in grado di gestire l'elaborazione video basata sull'intelligenza artificiale dall'inizio alla fine. Supporta flussi di lavoro end-to-end, dalla decodifica e pre-elaborazione video all'inferenza AI e alla post-elaborazione.

Recentemente, DeepStream ha introdotto diversi aggiornamenti per migliorare l'implementazione dell'IA, rendendola più accessibile e scalabile. Nuovi strumenti semplificano lo sviluppo, migliorano il tracciamento multi-camera e ottimizzano le pipeline di IA per prestazioni migliori.

Gli sviluppatori ora dispongono di un supporto ampliato per gli ambienti Windows, funzionalità avanzate di sensor fusion per l'integrazione di dati provenienti da più fonti e accesso ad applicazioni di riferimento predefinite per accelerare l'implementazione. Questi miglioramenti rendono DeepStream una soluzione più flessibile ed efficiente per le applicazioni di IA in tempo reale, aiutando gli sviluppatori a scalare con facilità l'analisi video intelligente.

Come illustrato nel keynote di Guy Dahan allo YV24, l'Edge AI sta ridefinendo le applicazioni di computer vision. Con i progressi nell'hardware e nel software, l'elaborazione in tempo reale sta diventando più veloce, più efficiente ed economica.

Man mano che sempre più settori adottano l'Edge AI, affrontare sfide come la frammentazione e la complessità dell'implementazione sarà fondamentale per sbloccarne il pieno potenziale. Abbracciare queste innovazioni guiderà applicazioni di IA più intelligenti e reattive, plasmando il futuro della computer vision.

Entra a far parte della nostra community in crescita! Esplora il nostro repository GitHub per saperne di più sull'AI e consulta le nostre opzioni di licenza per dare il via ai tuoi progetti di Vision AI. Sei curioso di conoscere le innovazioni come l'AI nel settore sanitario e la computer vision nella produzione? Visita le nostre pagine dedicate alle soluzioni per saperne di più!