Esplorando come funzionano le applicazioni di computer vision

Immergiti con noi nelle applicazioni della computer vision. Esploreremo anche varie attività di computer vision come il rilevamento e la segmentazione degli oggetti.

Immergiti con noi nelle applicazioni della computer vision. Esploreremo anche varie attività di computer vision come il rilevamento e la segmentazione degli oggetti.

Quando abbiamo esplorato la storia dei modelli di visione computerizzata, abbiamo visto come si è evoluta la visione computerizzata e il percorso che ha portato ai modelli di visione avanzati che abbiamo oggi. Modelli moderni come Ultralytics YOLOv8 supportano molteplici compiti di computer vision e vengono utilizzati in diverse applicazioni interessanti.

In questo articolo, esamineremo le basi della computer vision e dei modelli di visione. Tratteremo come funzionano e le loro diverse applicazioni in vari settori. Le innovazioni della computer vision sono ovunque e modellano silenziosamente il nostro mondo. Scopriamole una per una!

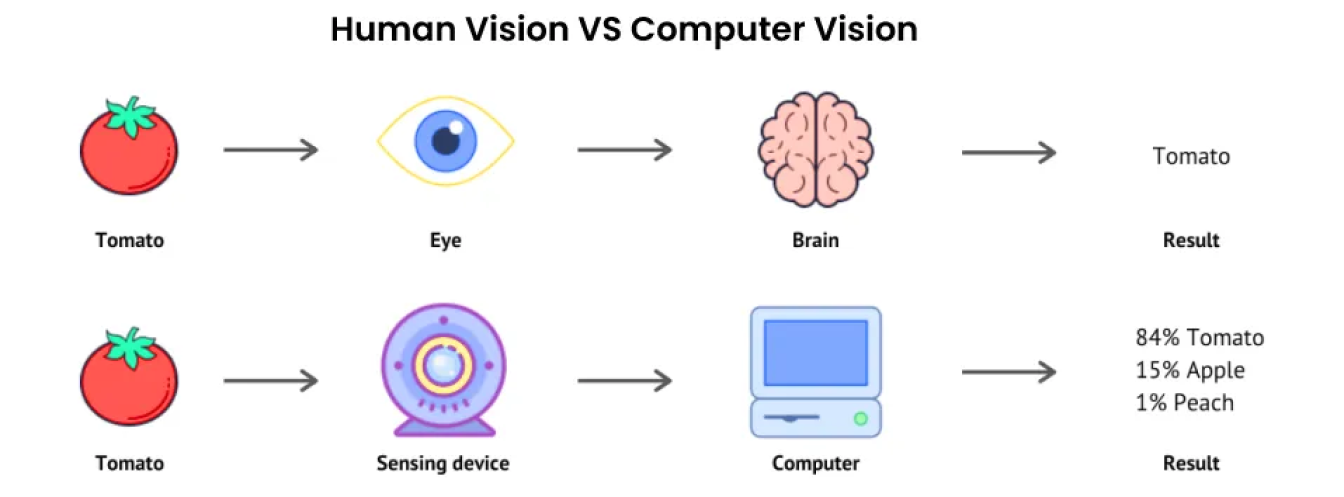

L'intelligenza artificiale (IA) è un termine ombrello che comprende molte tecnologie che mirano a replicare una parte dell'intelligenza umana. Un sottocampo di IA è la computer vision. La computer vision si concentra sul dare alle macchine occhi che possono vedere, osservare e comprendere ciò che le circonda.

Proprio come la visione umana, le soluzioni di computer vision mirano a distinguere gli oggetti, calcolare le distanze e detect movimenti. Tuttavia, a differenza degli esseri umani, che hanno una vita di esperienze che li aiutano a vedere e capire, i computer si basano su grandi quantità di dati, telecamere ad alta definizione e algoritmi complessi.

I sistemi di computer vision possono elaborare e analizzare dati visivi come immagini e video a velocità e precisione incredibili. La capacità di analizzare rapidamente e accuratamente grandi quantità di informazioni visive rende la computer vision uno strumento potente in vari settori, dalla produzione all'assistenza sanitaria.

I modelli di computer vision sono il fulcro di qualsiasi applicazione di computer vision. Sono essenzialmente algoritmi computazionali basati su tecniche di deep learning progettati per dare alle macchine la capacità di interpretare e comprendere le informazioni visive. I modelli di visione consentono attività cruciali di computer vision che vanno dalla classificazione delle immagini al rilevamento di oggetti. Diamo un'occhiata più da vicino ad alcune di queste attività e ai loro casi d'uso in modo più dettagliato.

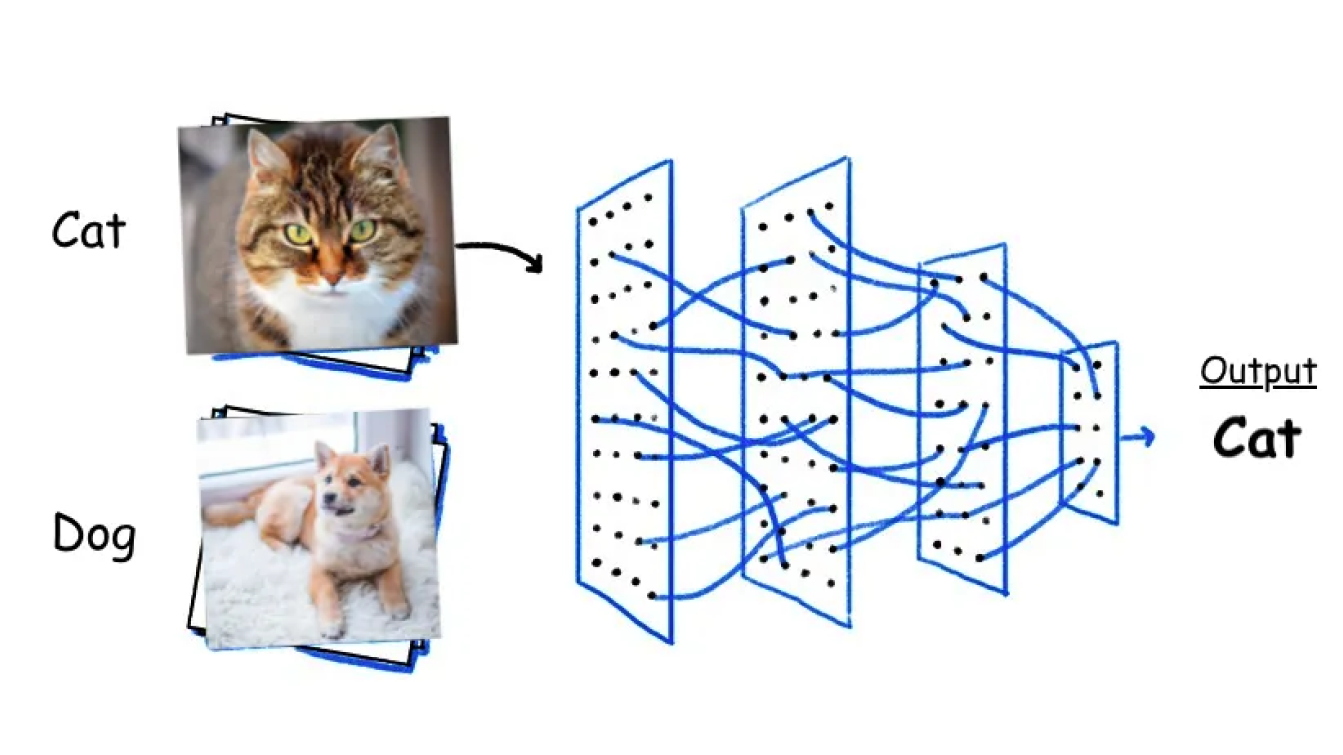

La classificazione delle immagini comporta la categorizzazione e l'etichettatura delle immagini in classi o categorie predefinite. Un modello di visione come YOLOv8 può essere addestrato su grandi insiemi di immagini etichettate. Durante l'addestramento, il modello impara a riconoscere i modelli e le caratteristiche associate a ciascuna classe. Una volta addestrato, può prevedere la categoria di nuove immagini non viste analizzando le loro caratteristiche e confrontandole con i modelli appresi.

Esistono diversi tipi di classificazione delle immagini. Ad esempio, quando si tratta di immagini mediche, si può usare la classificazione binaria per dividere le immagini in due gruppi, come sani o malati. Un altro tipo è la classificazione multiclasse. Può aiutare a classify immagini in molti gruppi, ad esempio classificando i diversi animali di una fattoria come maiali, capre e mucche. Se invece si desidera classify gli animali in gruppi e sottogruppi, come ad esempio classificare gli animali in mammiferi e uccelli e poi in specie come leoni, tigri, aquile e passeri, la classificazione gerarchica è l'opzione migliore.

Il rilevamento oggetti è il processo di identificazione e localizzazione di oggetti in immagini e fotogrammi video utilizzando la computer vision. Consiste di due attività: la localizzazione degli oggetti, che disegna dei bounding box attorno agli oggetti, e la classificazione degli oggetti, che identifica la categoria di ciascun oggetto. Sulla base delle annotazioni dei bounding box, un modello di visione può imparare a riconoscere schemi e caratteristiche specifici per ciascuna categoria di oggetti e prevedere la presenza e la posizione di questi oggetti in immagini nuove e non viste.

.png)

Il rilevamento oggetti ha molti casi d'uso in diversi settori, dallo sport alla biologia marina. Ad esempio, nel retail, la tecnologia Just Walk Out di Amazon utilizza il rilevamento oggetti per automatizzare il checkout identificando gli articoli prelevati dai clienti. Una combinazione di computer vision e dati dei sensori consente ai clienti di prendere i loro articoli e andarsene senza fare la fila.

Ecco uno sguardo più da vicino a come funziona:

La segmentazione semantica e la segmentazione di istanza sono task di computer vision che aiutano a partizionare le immagini in segmenti significativi. La segmentazione semantica classifica i pixel in base al loro significato semantico e tratta tutti gli oggetti all'interno di una categoria come un'unica entità con la stessa etichetta. È adatta per etichettare oggetti non numerabili come "il cielo" o "l'oceano" o cluster come "foglie" o "erba".

La segmentazione delle istanze, invece, è in grado di distinguere le diverse istanze della stessa classe assegnando un'etichetta unica a ciascun oggetto rilevato. È possibile utilizzare la segmentazione delle istanze per segment gli oggetti conteggiabili, quando il numero e l'indipendenza degli oggetti sono importanti. Consente un'identificazione e una differenziazione più precisa.

.png)

Possiamo capire meglio il contrasto tra segmentazione semantica e istanza con un esempio relativo alle auto a guida autonoma. La segmentazione semantica è ideale per compiti che richiedono la comprensione dei contenuti di una scena e può essere utilizzata nei veicoli autonomi per classify le caratteristiche della strada, come gli attraversamenti pedonali e i segnali stradali. La segmentazione istintiva, invece, può essere utilizzata nei veicoli autonomi per identificare i singoli pedoni, i veicoli e gli ostacoli.

La stima della posa è un'attività di computer vision incentrata sul rilevamento e il tracciamento dei punti chiave delle pose di un oggetto in immagini o video. È più comunemente utilizzata per la stima della posa umana, con punti chiave che includono aree come spalle e ginocchia. Stimare la posa di un essere umano ci aiuta a comprendere e riconoscere azioni e movimenti che sono fondamentali per varie applicazioni.

La stima della posa può essere utilizzata nello sport per analizzare come si muovono gli atleti. L'NBA utilizza la stima della posa per studiare i movimenti e le posizioni dei giocatori durante la partita. Tracciando punti chiave come spalle, gomiti, ginocchia e caviglie, la stima della posa fornisce informazioni dettagliate sui movimenti dei giocatori. Queste informazioni aiutano gli allenatori a sviluppare strategie migliori, ottimizzare i programmi di allenamento e apportare modifiche in tempo reale durante le partite. Inoltre, i dati possono aiutare a monitorare l'affaticamento dei giocatori e il rischio di infortuni per migliorare la salute e le prestazioni generali dei giocatori.

L'Object Detection con Bounding Box Orientati (OBB) utilizza rettangoli ruotati per identificare e localizzare con precisione gli oggetti in un'immagine. A differenza dei bounding box standard che si allineano con gli assi dell'immagine, gli OBB ruotano per corrispondere all'orientamento dell'oggetto. Questo li rende particolarmente utili per gli oggetti che non sono perfettamente orizzontali o verticali. Sono ottimi per individuare e isolare con precisione gli oggetti ruotati per evitare sovrapposizioni in ambienti affollati.

.png)

Nella sorveglianza marittima, l'identificazione e il tracciamento delle navi sono fondamentali per la sicurezza e la gestione delle risorse. Il rilevamento OBB può essere utilizzato per la localizzazione precisa delle navi, anche quando sono densamente raggruppate o orientate a varie angolazioni. Aiuta a monitorare le rotte di navigazione, a gestire il traffico marittimo e a ottimizzare le operazioni portuali. Può anche assistere nella risposta ai disastri identificando e valutando rapidamente i danni alle navi e alle infrastrutture dopo eventi come uragani o sversamenti di petrolio.

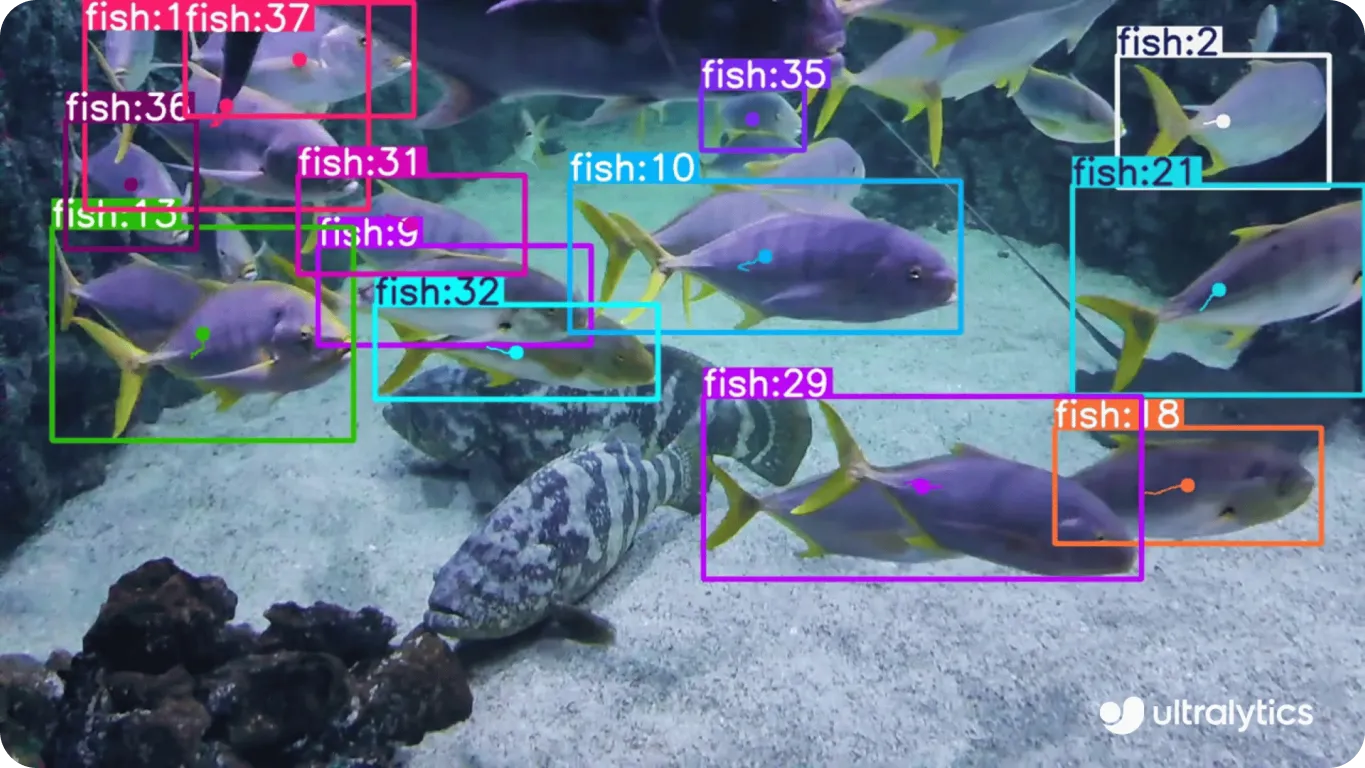

Finora abbiamo parlato di compiti di computer vision che riguardano le immagini. Il tracciamento degli oggetti è un'attività di computer vision in grado di track un oggetto nel corso dei fotogrammi di un video. Inizia identificando l'oggetto nel primo fotogramma mediante algoritmi di rilevamento e poi ne segue continuamente la posizione mentre si muove nel video. Il tracciamento dell'oggetto coinvolge tecniche come il rilevamento dell'oggetto, l'estrazione delle caratteristiche e la previsione del movimento per mantenere il tracciamento accurato.

I modelli di visione come YOLOv8 possono essere utilizzati per track pesci nella biologia marina. Utilizzando telecamere subacquee, i ricercatori possono monitorare i movimenti e i comportamenti dei pesci nei loro habitat naturali. Il processo inizia con il rilevamento dei singoli pesci nei primi fotogrammi e poi segue le loro posizioni per tutto il video. Il monitoraggio dei pesci aiuta gli scienziati a comprendere i modelli di migrazione, i comportamenti sociali e le interazioni con l'ambiente. Inoltre, fornisce informazioni sulla distribuzione e l'abbondanza dei pesci e favorisce pratiche di pesca sostenibili.

La computer vision sta attivamente cambiando il modo in cui utilizziamo la tecnologia e interagiamo con il mondo. Utilizzando modelli di deep learning e algoritmi complessi per comprendere immagini e video, la computer vision aiuta le industrie a semplificare molti processi. Attività di computer vision come il rilevamento di oggetti e il tracciamento di oggetti stanno rendendo possibile la creazione di soluzioni che non sono state immaginate prima. Man mano che la tecnologia di computer vision continua a migliorare, il futuro riserva molte altre applicazioni innovative!

Impariamo e cresciamo insieme! Esplora il nostro repository GitHub per vedere i nostri contributi all'IA. Scopri come stiamo ridefinendo settori come le auto a guida autonoma e l'agricoltura con l'IA. 🚀