Modelli multimodali e apprendimento multimodale: Ampliare le capacità dell'IA

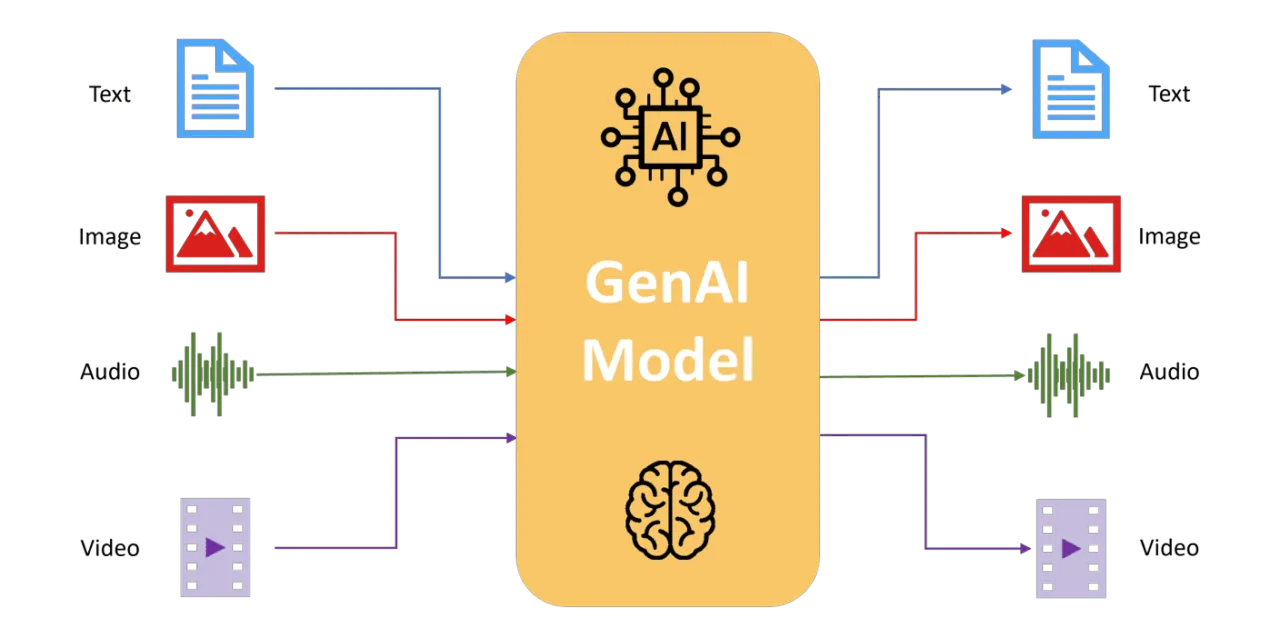

Scopri come i modelli multimodali integrano testo, immagini, audio e dati dei sensori per migliorare la percezione, il ragionamento e il processo decisionale dell'AI.

Scopri come i modelli multimodali integrano testo, immagini, audio e dati dei sensori per migliorare la percezione, il ragionamento e il processo decisionale dell'AI.

I sistemi di IA tradizionali elaborano tipicamente informazioni provenienti da una singola fonte di dati, come testo, immagini o audio. Sebbene questi approcci unimodali eccellano in compiti specializzati, spesso non riescono a gestire scenari complessi del mondo reale che coinvolgono molteplici input simultanei. L'apprendimento multimodale affronta questo problema integrando diversi flussi di dati all'interno di un framework unificato, consentendo una comprensione più ricca e consapevole del contesto.

Ispirati alla percezione umana, i modelli multimodali analizzano, interpretano e agiscono sulla base di input combinati, proprio come gli esseri umani che integrano naturalmente vista, udito e linguaggio. Questi modelli consentono all'IA di gestire scenari complessi con maggiore accuratezza, robustezza e adattabilità.

In questo articolo, esploreremo come si sono evoluti i modelli multi-modali, analizzeremo come funzionano, discuteremo le loro applicazioni pratiche all'interno della computer vision e valuteremo i vantaggi e le sfide associate all'integrazione di più tipi di dati.

Potresti chiederti cosa sia esattamente l'apprendimento multi-modale e perché sia importante per l'intelligenza artificiale (AI). I modelli di AI tradizionali in genere gestiscono un solo tipo di dati alla volta, che si tratti di immagini, testo, audio o input di sensori.

L'apprendimento multimodale, tuttavia, fa un ulteriore passo avanti consentendo ai sistemi di analizzare, interpretare e integrare simultaneamente flussi di dati diversi e multipli. Questo approccio rispecchia da vicino il modo in cui il cervello umano integra naturalmente input visivi, uditivi e linguistici per formare una comprensione coesa del mondo.

Combinando queste diverse modalità, l'AI multimodale raggiunge una comprensione più profonda e sfumata di scenari complessi.

Ad esempio, quando si analizzano filmati, un sistema multimodale non si limita a elaborare i contenuti visivi, ma prende in considerazione anche i dialoghi parlati, i suoni ambientali e i sottotitoli di accompagnamento.

Questa prospettiva integrata consente all'AI di catturare il contesto e le sfumature che andrebbero perse se ogni tipo di dato venisse analizzato indipendentemente.

In termini pratici, l'apprendimento multi-modale espande ciò che l'IA può realizzare. Potenzia applicazioni come la didascalia di immagini, la risposta a domande basate sul contesto visivo, la generazione di immagini realistiche da descrizioni testuali e il miglioramento dei sistemi interattivi rendendoli più intuitivi e consapevoli del contesto.

Ma come fanno i modelli multimodali a combinare questi diversi tipi di dati per raggiungere questi risultati? Analizziamo passo dopo passo i meccanismi fondamentali alla base del loro successo.

I modelli di IA multimodale raggiungono le loro potenti capacità attraverso processi specializzati: estrazione separata delle caratteristiche per ogni modalità (elaborazione di ogni tipo di dato, come immagini, testo o audio, in modo indipendente), metodi di fusione (combinazione dei dettagli estratti) e tecniche di allineamento avanzate (che garantiscono che le informazioni combinate si integrino in modo coerente).

Analizziamo più nel dettaglio come funziona ciascuno di questi processi.

I modelli di IA multimodale utilizzano architetture diverse e specializzate per ogni tipo di dato. Ciò significa che gli input visivi, testuali, audio o provenienti da sensori vengono elaborati da sistemi progettati specificamente per essi. In questo modo, il modello può acquisire i dettagli unici di ogni input prima di combinarli.

Ecco alcuni esempi di come diverse architetture specializzate vengono utilizzate per estrarre caratteristiche da vari tipi di dati:

Una volta elaborata individualmente, ogni modalità genera caratteristiche di alto livello ottimizzate per catturare le informazioni uniche contenute all'interno di quello specifico tipo di dati.

Dopo l'estrazione delle caratteristiche, i modelli multimodali le uniscono in una rappresentazione unificata e coerente. Per fare ciò in modo efficace, vengono utilizzate diverse strategie di fusione:

Infine, i sistemi multi-modali utilizzano tecniche avanzate di allineamento e attenzione per garantire che i dati provenienti da diverse modalità corrispondano efficacemente.

Metodi come l'apprendimento contrastivo aiutano ad allineare strettamente le rappresentazioni visive e testuali all'interno di uno spazio semantico condiviso. In questo modo, i modelli multimodali possono stabilire connessioni forti e significative tra diversi tipi di dati, garantendo la coerenza tra ciò che il modello "vede" e "legge".

I meccanismi di attenzione basati su Transformer migliorano ulteriormente questo allineamento consentendo ai modelli di concentrarsi dinamicamente sugli aspetti più rilevanti di ciascun input. Ad esempio, i livelli di attenzione consentono al modello di collegare direttamente descrizioni testuali specifiche con le regioni corrispondenti nei dati visivi, migliorando notevolmente la precisione in attività complesse come il visual question answering (VQA) e la didascalia di immagini.

Queste tecniche migliorano la capacità dell'IA multimodale di comprendere a fondo il contesto, consentendo all'IA di fornire interpretazioni più sfumate e accurate di dati complessi del mondo reale.

L'IA multimodale si è evoluta in modo significativo, passando dalle prime tecniche basate su regole a sistemi avanzati di deep learning in grado di un'integrazione sofisticata.

Agli albori, i sistemi multimodali combinavano diversi tipi di dati, come immagini, audio o input di sensori, utilizzando regole create manualmente da esperti umani o semplici metodi statistici. Ad esempio, i primi sistemi di navigazione robotica fondevano le immagini delle telecamere con i dati sonar per detect ed evitare gli ostacoli. Pur essendo efficaci, questi sistemi richiedevano un'estesa ingegnerizzazione manuale delle caratteristiche ed erano limitati nella loro capacità di adattamento e generalizzazione.

Con l'avvento del deep learning, i modelli multimodali sono diventati molto più popolari. Reti neurali come gli autoencoder multimodali hanno iniziato ad apprendere rappresentazioni congiunte di diversi tipi di dati, in particolare immagini e testo, consentendo all'IA di gestire attività come il cross-modal retrieval e la ricerca di immagini basata esclusivamente su descrizioni testuali.

I progressi sono continuati con sistemi come il Visual Question Answering (VQA) che integrano CNN per l'elaborazione delle immagini e RNN o trasformatori per l'interpretazione del testo. Ciò ha permesso ai modelli AI di rispondere accuratamente a domande complesse e dipendenti dal contesto sui contenuti visivi.

Più recentemente, modelli multimodali su larga scala addestrati su dataset massicci su scala Internet hanno ulteriormente rivoluzionato le capacità dell'IA.

Questi modelli sfruttano tecniche come l'apprendimento contrastivo, che consente loro di identificare relazioni generalizzabili tra contenuti visivi e descrizioni testuali. Colmando le lacune tra le modalità, le moderne architetture multimodali hanno migliorato la capacità dell'IA di eseguire complesse attività di ragionamento visivo con una precisione quasi umana, illustrando quanto l'IA multimodale sia progredita rispetto alle sue fasi fondamentali.

Ora che abbiamo esplorato come i modelli multimodali integrano diversi flussi di dati, approfondiamo come queste capacità possono essere applicate ai modelli di computer vision.

Combinando l'input visivo con testo, audio o dati di sensori, l'apprendimento multimodale consente ai sistemi di intelligenza artificiale di affrontare applicazioni sempre più sofisticate e ricche di contesto.

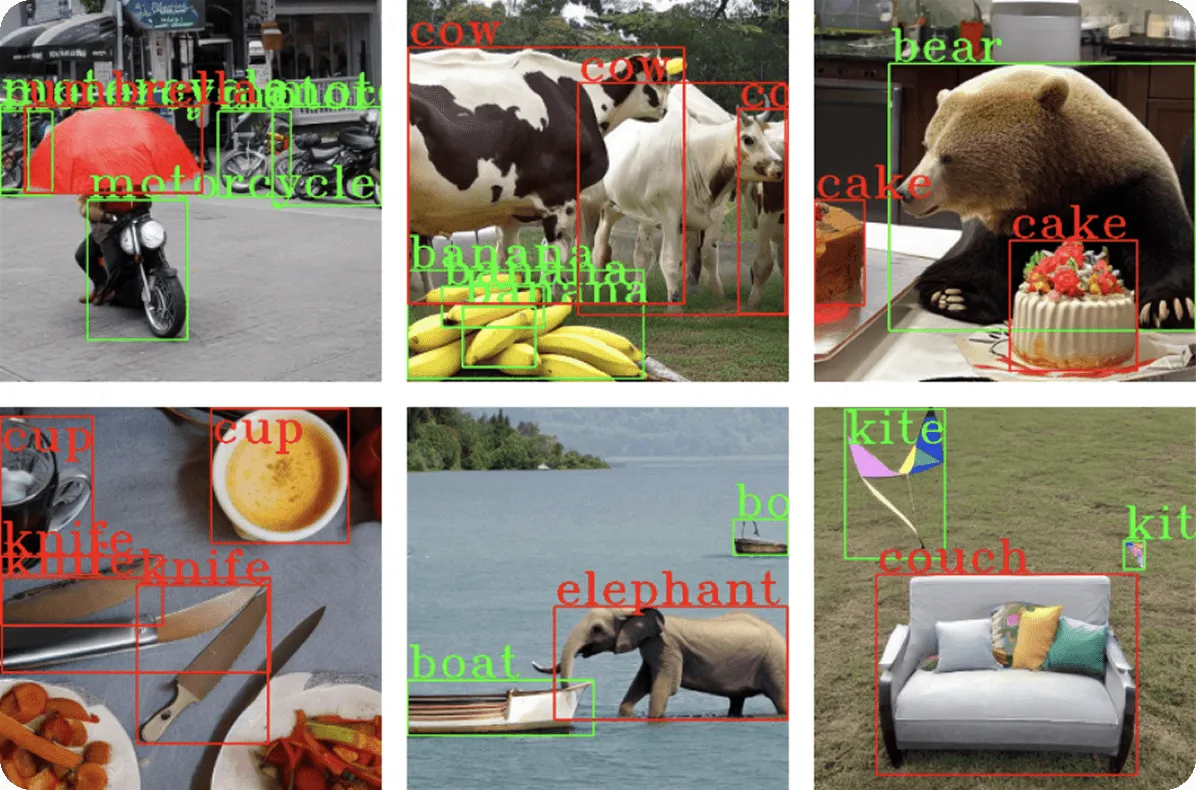

L'Image captioning implica la generazione di descrizioni in linguaggio naturale per i dati visivi. I metodi tradizionali di object detection identificano singoli oggetti, ma il captioning multimodale va oltre, interpretando relazioni e contesti.

Ad esempio, un modello multimodale può analizzare un'immagine di persone a un picnic e generare una didascalia descrittiva come "Una famiglia che fa un picnic in un parco soleggiato", fornendo un output più ricco e accessibile.

Questa applicazione è importante per l'accessibilità. Può essere utilizzata per generare alt-text per persone con problemi di vista e per il tagging di contenuti per grandi database. Le architetture Transformer svolgono un ruolo chiave in questo caso, consentendo al modulo di generazione di testo di concentrarsi sulle aree visive rilevanti attraverso meccanismi di attenzione, allineando dinamicamente le descrizioni testuali con le caratteristiche visive.

I modelli VQA rispondono a domande in linguaggio naturale basate su contenuti visivi, combinando la computer vision con la comprensione del linguaggio. Queste attività richiedono una comprensione dettagliata del contenuto dell'immagine, del contesto e del ragionamento semantico.

Le architetture Transformer hanno migliorato il VQA consentendo alle componenti testuali e visive del modello di interagire dinamicamente, individuando le regioni esatte dell'immagine correlate alla domanda.

Il modello PaLI diGoogle, ad esempio, utilizza architetture avanzate basate su trasformatori che integrano trasformatori visivi (ViT) con codificatori e decodificatori linguistici, consentendo di rispondere con precisione a domande sofisticate come "Cosa sta facendo la donna nella foto?" o "Quanti animali sono visibili?".

I livelli di attenzione, che aiutano i modelli a concentrarsi sulle parti più rilevanti di un input, assicurano che ogni parola della domanda si colleghi dinamicamente agli indizi visivi, consentendo risposte sfumate oltre il semplice rilevamento degli oggetti.

La generazione di testo-immagine si riferisce alla capacità dell'IA di creare contenuti visivi direttamente da descrizioni testuali, colmando il divario tra la comprensione semantica e la creazione visiva.

I modelli multimodali che eseguono questo compito utilizzano architetture neurali avanzate, come i transformer o i processi di diffusione, per generare immagini dettagliate e contestualmente accurate.

Ad esempio, immagina di generare dati di addestramento sintetici per modelli di computer vision incaricati del rilevamento di veicoli. Date descrizioni testuali come "una berlina rossa parcheggiata in una strada trafficata" o "un SUV bianco che guida su un'autostrada", questi modelli multimodali possono produrre immagini diverse e di alta qualità che raffigurano questi scenari precisi.

Tale capacità consente a ricercatori e sviluppatori di espandere in modo efficiente i set di dati di object detection senza acquisire manualmente migliaia di immagini, riducendo significativamente i tempi e le risorse necessarie per la raccolta dei dati.

Metodi più recenti applicano tecniche basate sulla diffusione, partendo da rumore visivo casuale e perfezionando progressivamente l'immagine per allinearla strettamente all'input testuale. Questo processo iterativo può creare esempi realistici e vari, garantendo dati di addestramento robusti che coprono molteplici punti di vista, condizioni di illuminazione, tipi di veicoli e sfondi.

Questo approccio è particolarmente utile nella computer vision, in quanto consente una rapida espansione del dataset, migliorando l'accuratezza del modello e aumentando la diversità degli scenari che i sistemi di IA possono riconoscere in modo affidabile.

I sistemi di retrieval multimodali semplificano la ricerca convertendo sia il testo che le immagini in un linguaggio di significato comune. Ad esempio, i modelli addestrati su enormi set di dati, come CLIP, che ha imparato da milioni di coppie immagine-testo, possono abbinare le query di testo con le immagini giuste, ottenendo risultati di ricerca più intuitivi e accurati.

Ad esempio, una query di ricerca come "tramonto su una spiaggia" restituisce risultati visivamente precisi, migliorando significativamente l'efficienza della scoperta di contenuti su piattaforme di e-commerce, archivi multimediali e database di fotografie stock.

L'approccio multimodale garantisce l'accuratezza del recupero anche quando le query e le descrizioni delle immagini utilizzano lingue diverse, grazie agli allineamenti semantici appresi tra domini visivi e testuali.

L'apprendimento multimodale offre diversi vantaggi chiave che migliorano le capacità dell'IA nella computer vision e oltre:

Nonostante questi punti di forza, i modelli multimodali presentano anche una serie di sfide:

L'apprendimento multimodale sta rimodellando l'IA, consentendo una comprensione più ricca e contestuale attraverso flussi di dati multipli. Le applicazioni nella computer vision, come la didascalia di immagini, la risposta a domande visive, la generazione di testo-immagine e il miglioramento del recupero di immagini, dimostrano il potenziale dell'integrazione di diverse modalità.

Sebbene permangano sfide computazionali ed etiche, le continue innovazioni nelle architetture, come la fusione basata su transformer e l'allineamento contrastivo, continuano ad affrontare queste preoccupazioni, spingendo l'IA multimodale verso un'intelligenza sempre più simile a quella umana.

Man mano che questo campo si evolve, i modelli multi-modali diventeranno essenziali per compiti complessi di IA nel mondo reale, migliorando tutto, dalla diagnostica sanitaria alla robotica autonoma. Abbracciare l'apprendimento multi-modale posiziona le industrie per sfruttare potenti capacità che plasmeranno il futuro dell'IA.

Unisciti alla nostra community in crescita! Esplora il nostro repository GitHub per saperne di più sull'AI. Sei pronto per iniziare i tuoi progetti di computer vision? Dai un'occhiata alle nostre opzioni di licenza. Scopri l'AI nella produzione e la Vision AI nella guida autonoma visitando le nostre pagine delle soluzioni!