Scopri il nuovo GPT-4o di OpenAI, dotato di intelligenza artificiale avanzata con interazioni realistiche che cambiano il modo in cui comunichiamo con la tecnologia. Esplora le sue caratteristiche rivoluzionarie!

Scopri il nuovo GPT-4o di OpenAI, dotato di intelligenza artificiale avanzata con interazioni realistiche che cambiano il modo in cui comunichiamo con la tecnologia. Esplora le sue caratteristiche rivoluzionarie!

Lunedì 13 maggio 2024, OpenAI ha annunciato il lancio del suo nuovo modello di punta, GPT-4o, dove la 'o' sta per 'omni'. GPT-4o è un modello AI multimodale avanzato per interazioni in tempo reale di testo, audio e visione, che offre elaborazione più rapida, supporto multilingue e maggiore sicurezza.

Sta portando sul tavolo capacità di IA generativa mai viste prima. Basandosi sui punti di forza conversazionali di ChatGPT, le funzionalità di GPT-4o segnano un sostanziale passo avanti nel modo in cui le persone percepiscono l'IA. Ora possiamo parlare con GPT-4o come se fosse una persona reale. Scopriamo cosa è in grado di fare GPT-4o!

All'aggiornamento primaverile di OpenAI, è stato rivelato che, sebbene GPT-4o sia intelligente quanto GPT-4, può elaborare i dati più velocemente ed è meglio attrezzato per gestire testo, visione e audio. A differenza delle versioni precedenti che si concentravano sul rendere i modelli più intelligenti, questa versione è stata realizzata tenendo presente la necessità di rendere l'IA più facile da usare per il pubblico generale.

.png)

La modalità vocale di ChatGPT, rilasciata alla fine dello scorso anno, prevedeva l'impiego di tre diversi modelli per trascrivere gli input vocali, comprendere e generare risposte scritte e convertire il testo in voce in modo che l'utente potesse ascoltare la risposta. Questa modalità aveva problemi di latenza e non era molto naturale. GPT-4o è in grado di elaborare in modo nativo testo, immagini e audio in un'unica soluzione per dare all'utente l'impressione di partecipare a una conversazione naturale.

Inoltre, a differenza della modalità vocale, ora puoi interrompere GPT-4o mentre parla e reagirà proprio come farebbe una persona. Si fermerà e ascolterà, quindi fornirà la sua risposta in tempo reale in base a ciò che hai detto. Può anche esprimere emozioni attraverso la sua voce e capire anche il tuo tono.

La valutazione del modello GPT-4o mostra quanto sia avanzato. Uno dei risultati più interessanti è che GPT-4o migliora notevolmente il riconoscimento vocale rispetto a Whisper-v3 in tutte le lingue, specialmente quelle meno utilizzate.

Le prestazioni dell'Audio ASR (Automatic Speech Recognition) misurano con quanta precisione un modello trascrive il linguaggio parlato in testo. Le prestazioni di GPT-4o sono monitorate dal Word Error Rate (WER), che mostra la percentuale di parole trascritte in modo errato (un WER inferiore significa una migliore qualità). Il grafico sottostante mostra il WER inferiore di GPT-4o in varie regioni, dimostrando la sua efficacia nel migliorare il riconoscimento vocale per le lingue con meno risorse.

.png)

Ecco uno sguardo ad alcune delle caratteristiche uniche di GPT-4o:

Ora puoi estrarre GPT-4o sul tuo telefono, accendere la fotocamera e chiedere a GPT-4o, come faresti con un amico, di indovinare il tuo umore in base alla tua espressione facciale. GPT-4o può vederti attraverso la fotocamera e rispondere.

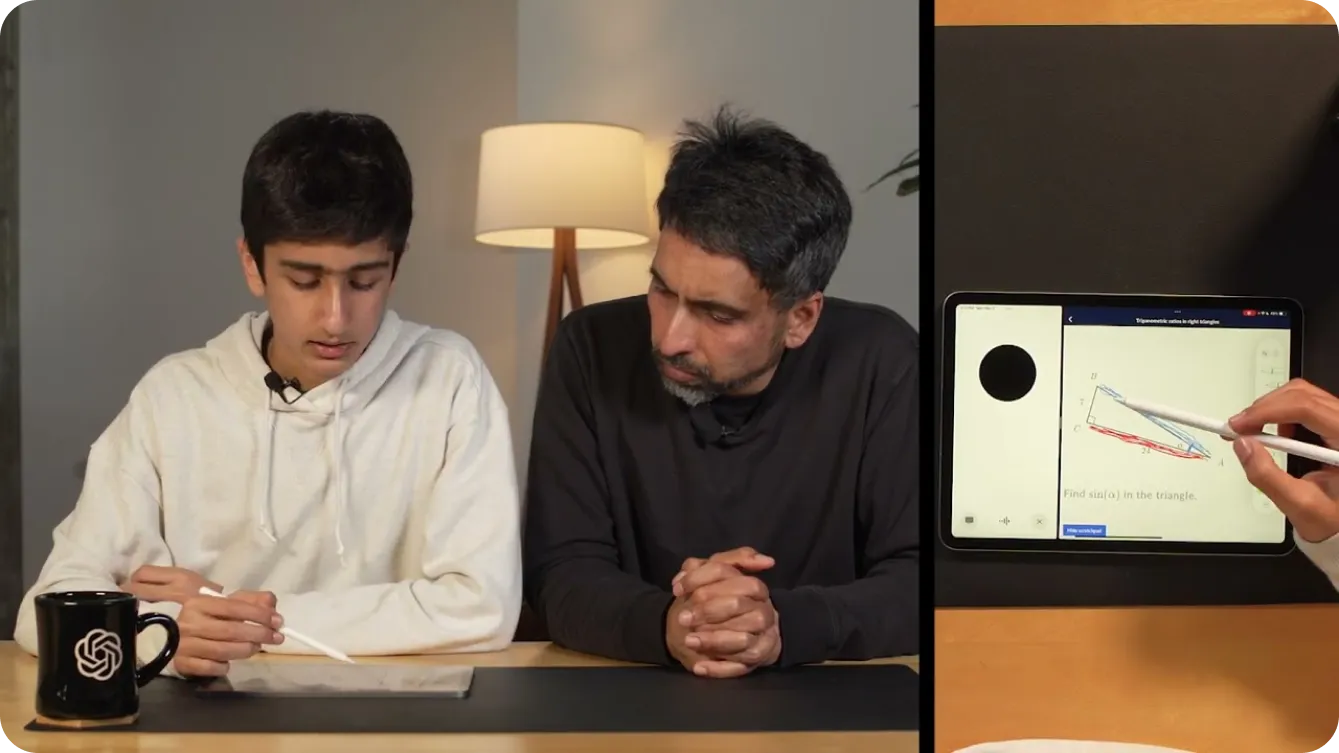

Puoi persino usarlo per aiutarti a risolvere problemi di matematica mostrando a GPT-4o ciò che stai scrivendo tramite video. In alternativa, potresti condividere il tuo schermo e può diventare un utile tutor su Khan Academy, chiedendoti di indicare diverse parti di un triangolo in geometria, come mostrato di seguito.

Oltre ad aiutare i bambini con la matematica, gli sviluppatori possono conversare con GPT-4o per eseguire il debug del loro codice. Questo è possibile grazie all'introduzione di ChatGPT come applicazione desktop. Se si evidenzia e si copia il codice utilizzando CTRL "C" mentre si parla con l'app vocale GPT-4o per desktop, questa sarà in grado di leggere il codice. Oppure si può usare per tradurre le conversazioni tra sviluppatori che parlano lingue diverse.

Le possibilità con GPt-4o sembrano infinite. Una delle demo più interessanti di OpenAI ha utilizzato due telefoni per mostrare GPt-4o che parlava con diverse istanze di sé stesso e cantava insieme.

Come mostrato in una demo, GPT-4o può rendere il mondo più accessibile alle persone con problemi di vista. Può aiutarle a interagire e muoversi in modo più sicuro e indipendente. Ad esempio, gli utenti possono attivare il video e mostrare a GPT-4o una vista della strada. GPT-4o può quindi fornire descrizioni in tempo reale dell'ambiente, come l'identificazione di ostacoli, la lettura di segnali stradali o la guida verso una posizione specifica. Può anche aiutarli a chiamare un taxi avvisandoli quando un taxi si sta avvicinando.

.png)

Allo stesso modo, GPT-4o può trasformare vari settori con le sue capacità avanzate. Nel settore retail, può migliorare il servizio clienti fornendo assistenza in tempo reale, rispondendo alle domande e aiutando i clienti a trovare i prodotti sia online che in negozio. Supponiamo che tu stia guardando uno scaffale di prodotti e non riesca a trovare quello che stai cercando, GPT-4o può aiutarti.

Nel settore sanitario, GPT-4o può assistere nella diagnostica analizzando i dati dei pazienti, suggerendo possibili condizioni in base ai sintomi e offrendo indicazioni sulle opzioni di trattamento. Può anche supportare i professionisti medici riassumendo le cartelle cliniche dei pazienti, fornendo un rapido accesso alla letteratura medica e persino offrendo la traduzione linguistica in tempo reale per comunicare con i pazienti che parlano lingue diverse. Questi sono solo alcuni esempi. Le applicazioni di GPT-4o semplificano la vita quotidiana offrendo assistenza personalizzata e consapevole del contesto e abbattendo le barriere all'informazione e alla comunicazione.

Proprio come le versioni precedenti di GPT, che hanno avuto un impatto su centinaia di milioni di vite, è probabile che GPT-4o interagisca con audio e video in tempo reale a livello globale, rendendo la sicurezza un elemento cruciale in queste applicazioni. OpenAI è stata molto attenta a costruire GPT-4o concentrandosi sulla mitigazione dei potenziali rischi.

Per garantire sicurezza e affidabilità, OpenAI ha implementato rigorose misure di sicurezza. Queste includono il filtraggio dei dati di addestramento, la rifinitura del comportamento del modello dopo l'addestramento e l'incorporazione di nuovi sistemi di sicurezza per la gestione degli output vocali. Inoltre, GPT-4o è stato ampiamente testato da oltre 70 esperti esterni in settori quali la psicologia sociale, i pregiudizi e l'equità e la disinformazione. I test esterni assicurano che tutti i rischi introdotti o amplificati dalle nuove funzionalità siano identificati e affrontati.

Per mantenere elevati standard di sicurezza, OpenAI rilascerà gradualmente le funzionalità di GPT-4o nelle prossime settimane. Un rilascio graduale consente a OpenAI di monitorare le prestazioni, risolvere eventuali problemi e raccogliere feedback dagli utenti. Questo approccio prudente garantisce che GPT-4o offra funzionalità avanzate mantenendo i più elevati standard di sicurezza e utilizzo etico.

GPT-4o è disponibile per l'accesso gratuito. Per provare le capacità di conversazione in tempo reale di cui sopra, potete scaricare l'applicazioneChatGPT dal Google Play Store o dall'Apple App Store direttamente sul vostro telefono.

Dopo aver effettuato l'accesso, sarà possibile selezionare GPT-4o dall'elenco visualizzato toccando i tre punti nell'angolo in alto a destra dello schermo. Dopo aver navigato in una chat abilitata con GPT-4o, toccando il segno più nell'angolo in basso a sinistra dello schermo, verranno visualizzate più opzioni di input. Nell'angolo in basso a destra dello schermo, si vedrà un'icona a forma di cuffia. Selezionando l'icona a forma di cuffia, verrà chiesto se si desidera provare una versione a mani libere di GPT-4o. Dopo aver accettato, sarà possibile provare GPT-4o, come mostrato di seguito.

Se desideri integrare le funzionalità avanzate di GPT-4o nei tuoi progetti, è disponibile come API per gli sviluppatori. Ti consente di incorporare il potente riconoscimento vocale, il supporto multilingue e le capacità di conversazione in tempo reale di GPT-4o nelle tue applicazioni. Utilizzando l'API, puoi migliorare le esperienze utente, creare app più intelligenti e portare la tecnologia AI all'avanguardia in diversi settori.

Sebbene GPT-4o sia molto più avanzato rispetto ai precedenti modelli di IA, è importante ricordare che GPT-4o ha i suoi limiti. OpenAI ha segnalato che a volte cambia casualmente lingua mentre parla, passando dall'English al francese. Hanno anche visto GPT-4o tradurre in modo errato da una lingua all'altra. Man mano che più persone proveranno il modello, capiremo dove GPT-4o eccelle e in cosa ha bisogno di ulteriori miglioramenti.

GPT-4o di OpenAI apre nuove porte all'IA grazie all'elaborazione avanzata di testo, immagini e audio, offrendo interazioni naturali e simili a quelle umane. Eccelle in termini di velocità, rapporto costo-efficacia e supporto multilingue. GPT-4o è uno strumento versatile per l'istruzione, l'accessibilità e l'assistenza in tempo reale. Man mano che gli utenti esplorano le capacità di GPT-4o, il feedback ne guiderà l'evoluzione. GPT-4o dimostra che l'IA sta davvero cambiando il nostro mondo e sta diventando parte della nostra vita quotidiana.

Esplora il nostro repository GitHub e unisciti alla nostra community per approfondire la tua conoscenza dell'AI. Visita le nostre pagine delle soluzioni per scoprire come l'AI sta trasformando settori come il manufacturing e l'agricoltura.