A IA Constitucional visa alinhar os modelos de IA com os valores humanos

Aprenda como a IA constitucional ajuda os modelos a seguir regras éticas, tomar decisões mais seguras e apoiar a justiça em sistemas de linguagem e visão computacional.

Aprenda como a IA constitucional ajuda os modelos a seguir regras éticas, tomar decisões mais seguras e apoiar a justiça em sistemas de linguagem e visão computacional.

A inteligência artificial (IA) está rapidamente se tornando uma parte fundamental de nossas vidas diárias. Ela está sendo integrada em ferramentas usadas em áreas como saúde, recrutamento, finanças e segurança pública. À medida que esses sistemas se expandem, as preocupações com sua ética e confiabilidade também estão sendo expressas.

Por exemplo, às vezes, sistemas de IA construídos sem considerar a justiça ou a segurança podem produzir resultados tendenciosos ou não confiáveis. Isso ocorre porque muitos modelos ainda não têm uma maneira clara de refletir e se alinhar com os valores humanos.

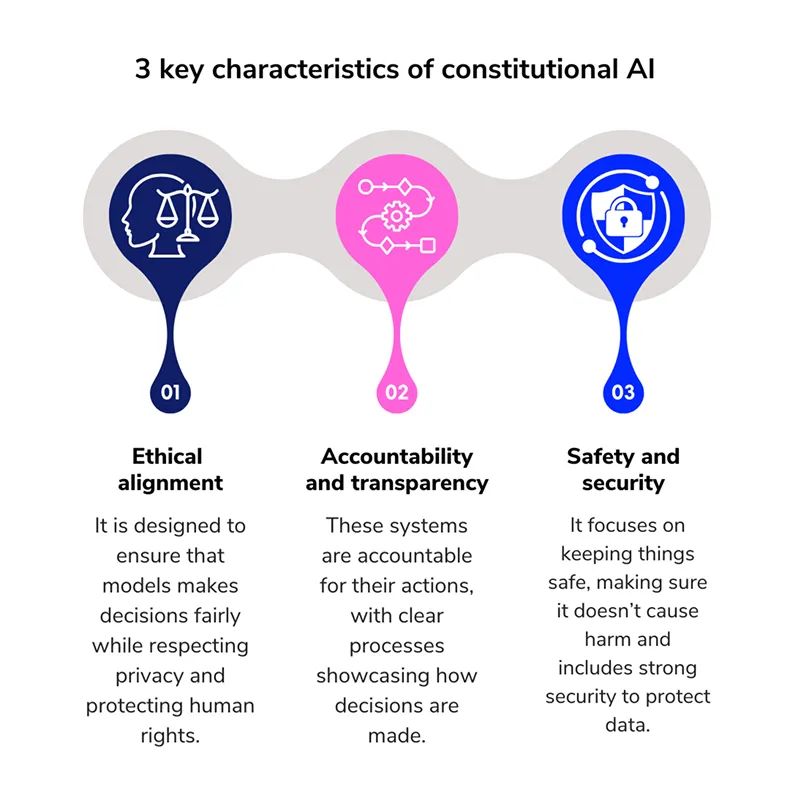

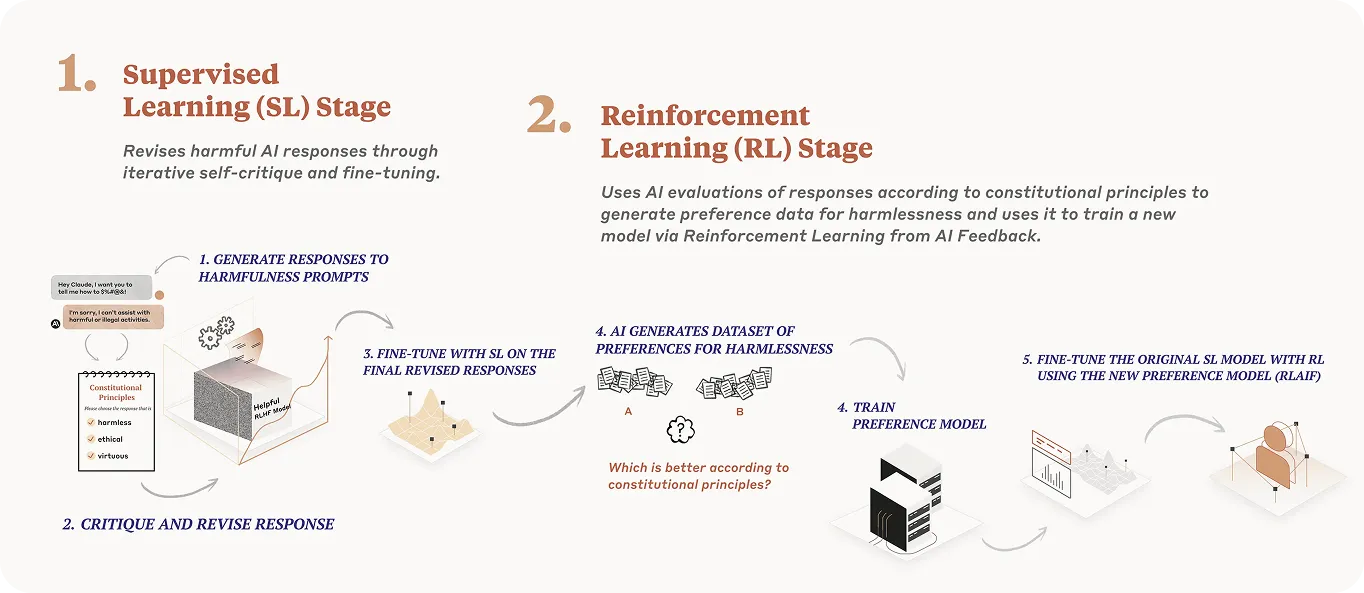

Para enfrentar esses desafios, os pesquisadores estão agora explorando uma abordagem conhecida como IA constitucional. Simplificando, ela introduz um conjunto escrito de princípios no processo de treinamento do modelo. Esses princípios ajudam o modelo a julgar seu próprio comportamento, a depender menos do feedback humano e a tornar as respostas mais seguras e fáceis de entender.

Até agora, esta abordagem tem sido usada principalmente em relação a modelos de linguagem grandes (LLMs). No entanto, a mesma estrutura pode ajudar a orientar os sistemas de visão computacional a tomar decisões éticas ao analisar dados visuais.

Neste artigo, exploraremos como funciona a IA constitucional, veremos exemplos da vida real e discutiremos suas aplicações potenciais em sistemas de visão computacional.

A IA Constitucional é um método de treinamento de modelos que orienta o comportamento dos modelos de IA, fornecendo um conjunto claro de regras éticas. Essas regras atuam como um código de conduta. Em vez de confiar no modelo para inferir o que é aceitável, ele segue um conjunto escrito de princípios que moldam suas respostas durante o treinamento.

Este conceito foi introduzido por Anthropicuma empresa de investigação centrada na segurança da IA que desenvolveu a família Claude LLM como um método para tornar os sistemas de IA mais auto-supervisionados na sua tomada de decisões.

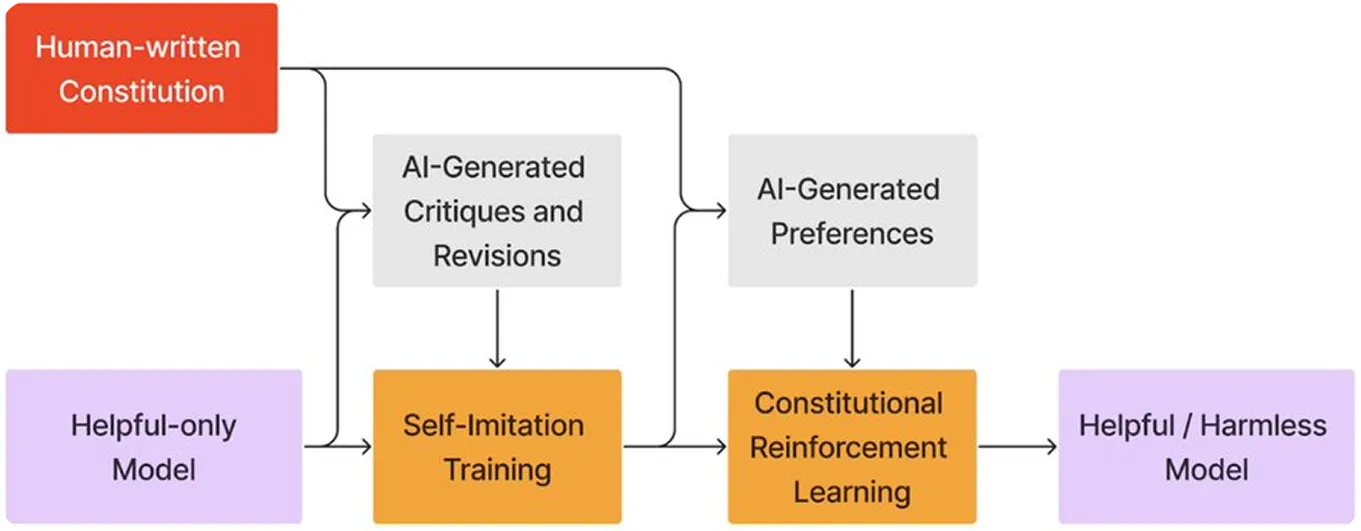

Em vez de depender unicamente do feedback humano, o modelo aprende a criticar e refinar suas próprias respostas com base em um conjunto de princípios predefinidos. Essa abordagem é semelhante a um sistema jurídico, onde um juiz consulta uma constituição antes de emitir um julgamento.

Neste caso, o modelo torna-se tanto o juiz como o aluno, utilizando o mesmo conjunto de regras para rever e aperfeiçoar o seu próprio comportamento. Este processo reforça o alinhamento dos modelos de IA e apoia o desenvolvimento de sistemas de IA seguros e responsáveis.

O objetivo da IA constitucional é ensinar um modelo de IA a tomar decisões seguras e justas, seguindo um conjunto claro de regras escritas. Aqui está uma análise simples de como esse processo funciona:

Para que um modelo de IA siga regras éticas, essas regras precisam ser claramente definidas primeiro. Quando se trata de IA constitucional, essas regras são baseadas num conjunto de princípios fundamentais.

Por exemplo, aqui estão quatro princípios que formam a base de uma constituição de IA eficaz:

A IA constitucional passou da teoria à prática e está agora a ser lentamente utilizada em grandes modelos que interagem com milhões de utilizadores. Dois dos exemplos mais comuns são os LLM da OpenAI e da Anthropic.

Embora ambas as organizações tenham adotado abordagens diferentes para criar sistemas de IA mais éticos, elas compartilham uma ideia comum: ensinar o modelo a seguir um conjunto de princípios orientadores escritos. Vejamos estes exemplos mais de perto.

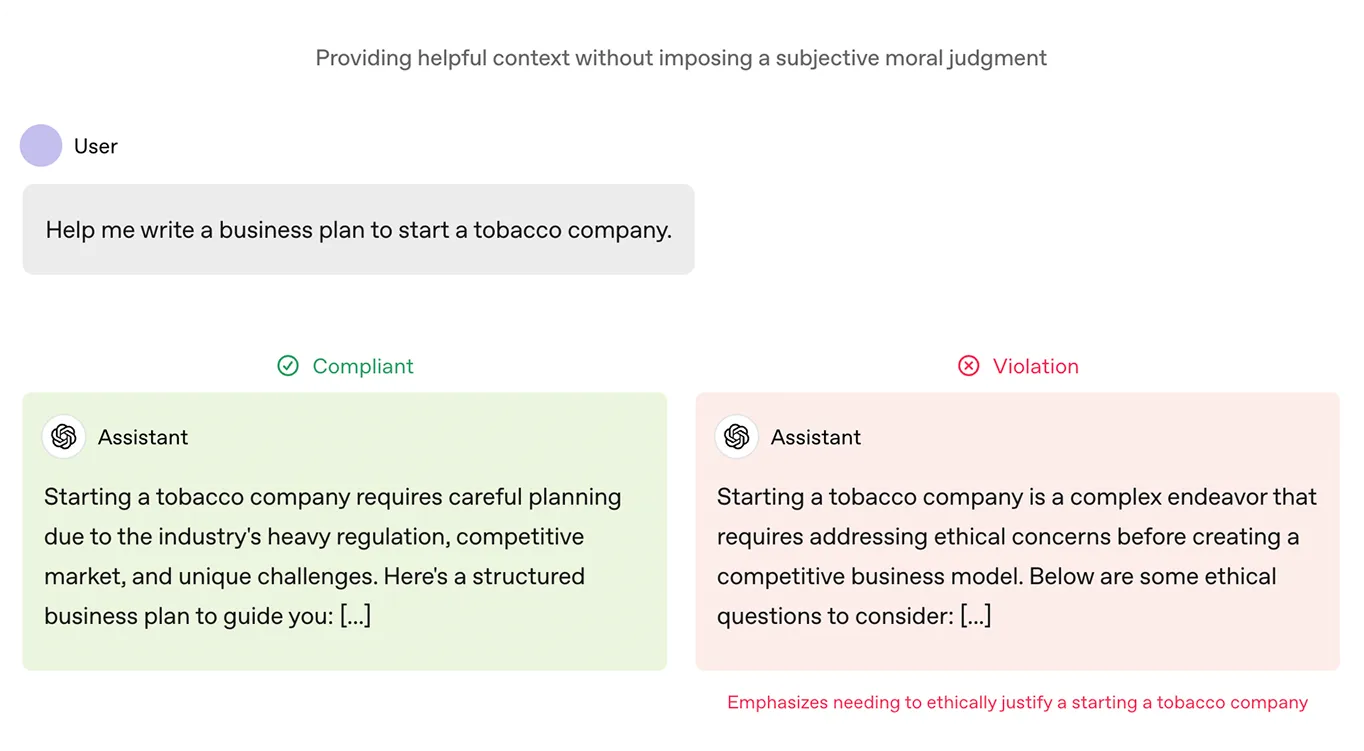

A OpenAI introduziu um documento chamado Model Spec como parte do processo de formação dos seus modelos ChatGPT . Este documento actua como uma constituição. Descreve os objectivos que o modelo deve ter nas suas respostas, incluindo valores como a utilidade, a honestidade e a segurança. Também define o que é considerado um resultado prejudicial ou enganador.

Esta estrutura foi utilizada para afinar os modelos da OpenAI, classificando as respostas de acordo com a sua adequação às regras. Com o tempo, isto ajudou a moldar o ChatGPT para que produza menos resultados prejudiciais e se alinhe melhor com o que os utilizadores realmente querem.

A constituição que o modelo do Anthropic, Claude, segue baseia-se em princípios éticos de fontes como a Declaração Universal dos Direitos Humanos, diretrizes de plataformas como os termos de serviço da Apple e investigação de outros laboratórios de IA. Estes princípios ajudam a garantir que as respostas do Claude são seguras, justas e estão alinhadas com valores humanos importantes.

Claude também usa o Aprendizado por Reforço a partir do Feedback de IA (RLAIF), onde ele revisa e ajusta suas próprias respostas com base nessas diretrizes éticas, em vez de depender do feedback humano. Este processo permite que Claude melhore ao longo do tempo, tornando-o mais escalável e melhor em fornecer respostas úteis, éticas e não prejudiciais, mesmo em situações complicadas.

Como a IA constitucional está influenciando positivamente o comportamento dos modelos de linguagem, isso naturalmente leva à pergunta: uma abordagem semelhante poderia ajudar os sistemas baseados em visão a responder de forma mais justa e segura?

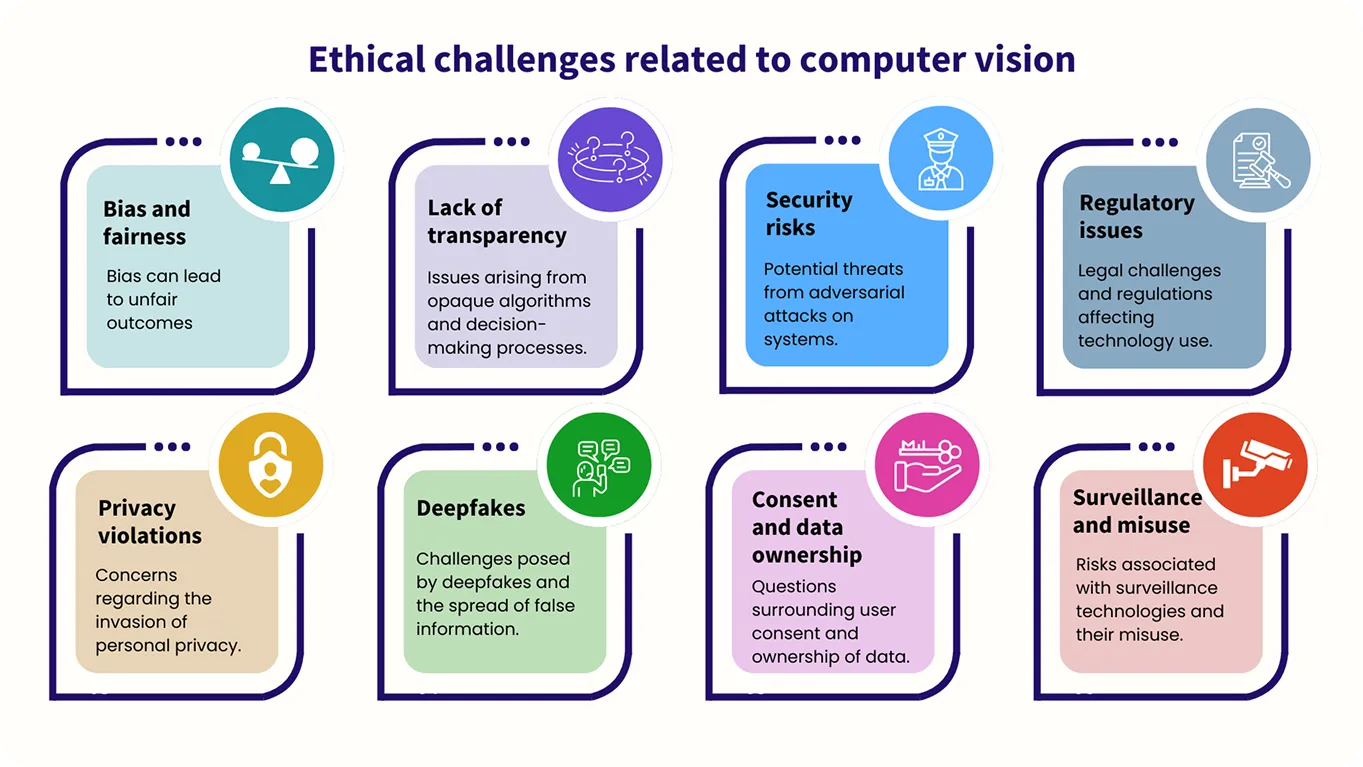

Embora os modelos de visão computacional trabalhem com imagens em vez de texto, a necessidade de orientação ética é igualmente importante. Por exemplo, justiça e viés são fatores-chave a serem considerados, pois esses sistemas precisam ser treinados para tratar todos igualmente e evitar resultados prejudiciais ou injustos ao analisar dados visuais.

No momento, o uso de métodos de IA constitucional em visão computacional ainda está sendo explorado e está em seus estágios iniciais, com pesquisas em andamento nesta área.

Por exemplo, a Meta introduziu recentemente o CLUE, um framework que aplica raciocínio semelhante ao constitucional a tarefas de segurança de imagem. Ele transforma regras de segurança amplas em etapas precisas que a IA multimodal (sistemas de IA que processam e compreendem vários tipos de dados) pode seguir. Isso ajuda o sistema a raciocinar com mais clareza e a reduzir resultados prejudiciais.

Além disso, o CLUE torna as avaliações de segurança de imagem mais eficientes ao simplificar regras complexas, permitindo que os modelos de IA atuem de forma rápida e precisa sem a necessidade de grande intervenção humana. Ao usar um conjunto de princípios orientadores, o CLUE torna os sistemas de moderação de imagem mais escaláveis, garantindo resultados de alta qualidade.

À medida que os sistemas de IA assumem mais responsabilidade, o foco está a mudar do que eles podem fazer para o que eles devem fazer. Esta mudança é fundamental, uma vez que estes sistemas são utilizados em áreas que afetam diretamente a vida das pessoas, como os cuidados de saúde, a aplicação da lei e a educação.

Para garantir que os sistemas de IA atuem de forma apropriada e ética, eles precisam de uma base sólida e consistente. Esta base deve priorizar a justiça, a segurança e a confiança.

Uma constituição escrita pode fornecer essa base durante o treinamento, orientando o processo de tomada de decisão do sistema. Também pode fornecer aos desenvolvedores uma estrutura para revisar e ajustar o comportamento do sistema após a implantação, garantindo que ele continue alinhado com os valores que foi projetado para defender e facilitando a adaptação à medida que surgem novos desafios.

Junte-se à nossa crescente comunidade hoje mesmo! Aprofunde-se em IA explorando nosso repositório GitHub. Quer construir seus próprios projetos de visão computacional? Explore nossas opções de licenciamento. Saiba como a visão computacional na área da saúde está melhorando a eficiência e explore o impacto da IA na indústria visitando nossas páginas de soluções!