Descubra por que é essencial abordar a IA de forma ética, como as regulamentações de IA estão sendo tratadas em todo o mundo e qual o papel que você pode desempenhar na promoção do uso ético da IA.

Descubra por que é essencial abordar a IA de forma ética, como as regulamentações de IA estão sendo tratadas em todo o mundo e qual o papel que você pode desempenhar na promoção do uso ético da IA.

À medida que a tecnologia de IA se torna cada vez mais popular, as discussões sobre a utilização ética da Inteligência Artificial (IA) tornaram-se muito comuns. Com muitos de nós a utilizar ferramentas de IA como o ChatGPT no dia a dia, há boas razões para nos preocuparmos se estamos a adotar a IA de uma forma segura e moralmente correta. Os dados são a raiz de todos os sistemas de IA e muitas aplicações de IA utilizam dados pessoais como imagens do seu rosto, transacções financeiras, registos de saúde, detalhes sobre o seu trabalho ou a sua localização. Para onde vão estes dados e como são tratados? Estas são algumas das questões a que a IA ética tenta responder e sensibilizar os utilizadores da IA.

Quando discutimos questões éticas relacionadas à IA, é fácil se deixar levar e tirar conclusões pensando em cenários como o Exterminador do Futuro e robôs assumindo o controle. No entanto, a chave para entender como abordar a IA ética na prática é simples e direta. Trata-se de construir, implementar e usar a IA de maneira justa, transparente e responsável. Neste artigo, exploraremos por que a IA deve permanecer ética, como criar inovações éticas em IA e o que você pode fazer para promover o uso ético da IA. Vamos começar!

Antes de nos aprofundarmos nos detalhes da IA ética, vamos analisar mais de perto por que ela se tornou um tópico de conversa tão essencial na comunidade de IA e o que exatamente significa para a IA ser ética.

A ética em relação à IA não é um tópico novo de conversa. Tem sido debatido desde a década de 1950. Na época, Alan Turing introduziu o conceito de inteligência de máquina e o Teste de Turing, uma medida da capacidade de uma máquina de exibir inteligência semelhante à humana através da conversação, o que iniciou as primeiras discussões éticas sobre IA. Desde então, pesquisadores têm comentado e enfatizado a importância de considerar os aspectos éticos da IA e da tecnologia. No entanto, apenas recentemente organizações e governos começaram a criar regulamentações para exigir IA ética.

Existem três razões principais para isso:

Com a IA se tornando mais avançada e recebendo mais atenção globalmente, a conversa sobre IA ética se torna inevitável.

Para entender verdadeiramente o que significa para a IA ser ética, precisamos analisar os desafios que a IA ética enfrenta. Esses desafios abrangem uma variedade de questões, incluindo viés, privacidade, responsabilidade e segurança. Algumas dessas lacunas na IA ética foram descobertas ao longo do tempo, implementando soluções de IA com práticas injustas, enquanto outras podem surgir no futuro.

.webp)

Aqui estão alguns dos principais desafios éticos na IA:

Ao abordar estes desafios, podemos desenvolver sistemas de IA que beneficiem a sociedade.

Em seguida, vamos percorrer como implementar soluções de IA éticas que lidem com cada um dos desafios mencionados acima. Ao focar em áreas-chave como a construção de modelos de IA não tendenciosos, a educação das partes interessadas, a priorização da privacidade e a garantia da segurança dos dados, as organizações podem criar sistemas de IA que sejam eficazes e éticos.

A criação de modelos de IA imparciais começa com o uso de conjuntos de dados diversificados e representativos para o treinamento. Auditorias regulares e métodos de detecção de viés ajudam a identificar e mitigar os vieses. Técnicas como reamostragem ou reponderação podem tornar os dados de treinamento mais justos. A colaboração com especialistas no domínio e o envolvimento de equipes diversificadas no desenvolvimento também podem ajudar a reconhecer e a abordar os vieses de diferentes perspectivas. Estas etapas ajudam a evitar que os sistemas de IA favoreçam injustamente qualquer grupo em particular.

.webp)

Quanto mais souber sobre a caixa negra da IA, menos assustadora ela se torna, tornando essencial para todos os envolvidos num projeto de IA entender como a IA por trás de qualquer aplicação funciona. As partes interessadas, incluindo desenvolvedores, utilizadores e tomadores de decisão, podem abordar melhor as implicações éticas da IA quando têm uma compreensão abrangente de diferentes conceitos de IA. Programas de treino e workshops sobre tópicos como viés, transparência, responsabilidade e privacidade de dados podem construir esta compreensão. Documentação detalhada explicando os sistemas de IA e os seus processos de tomada de decisão pode ajudar a construir confiança. Comunicação regular e atualizações sobre práticas éticas de IA também podem ser uma ótima adição à cultura organizacional.

Priorizar a privacidade significa desenvolver políticas e práticas robustas para proteger os dados pessoais. Os sistemas de IA devem usar dados obtidos com o devido consentimento e aplicar técnicas de minimização de dados para limitar a quantidade de informações pessoais processadas. A criptografia e a anonimização podem proteger ainda mais os dados confidenciais.

A conformidade com as regulamentações de proteção de dados, como o GDPR (Regulamento Geral de Proteção de Dados), é essencial. O GDPR estabelece diretrizes para a coleta e o processamento de informações pessoais de indivíduos dentro da União Europeia. Ser transparente sobre a coleta, uso e armazenamento de dados também é vital. Avaliações regulares de impacto na privacidade podem identificar riscos potenciais e apoiar a manutenção da privacidade como prioridade.

Além da privacidade, a segurança dos dados é essencial para construir sistemas de IA éticos. Medidas robustas de segurança cibernética protegem os dados contra violações e acesso não autorizado. Auditorias e atualizações de segurança regulares são necessárias para acompanhar a evolução das ameaças.

Os sistemas de IA devem incorporar recursos de segurança, como controles de acesso, armazenamento seguro de dados e monitoramento em tempo real. Um plano claro de resposta a incidentes ajuda as organizações a resolver rapidamente quaisquer problemas de segurança. Ao demonstrar um compromisso com a segurança de dados, as organizações podem construir confiança entre usuários e partes interessadas.

Na Ultralytics, a IA ética é um princípio fundamental que orienta nosso trabalho. Como diz Glenn Jocher, fundador e CEO: "A IA ética não é apenas uma possibilidade; é uma necessidade. Ao compreender e aderir aos regulamentos, podemos garantir que as tecnologias de IA são desenvolvidas e utilizadas de forma responsável em todo o mundo. A chave é equilibrar a inovação com a integridade, assegurando que a IA serve a humanidade de uma forma positiva e benéfica. Vamos dar o exemplo e mostrar que a IA pode ser uma força para o bem".

Esta filosofia nos leva a priorizar a justiça, a transparência e a responsabilidade em nossas soluções de IA. Ao integrar estas considerações éticas em nossos processos de desenvolvimento, pretendemos criar tecnologias que ultrapassem os limites da inovação e que cumpram os mais altos padrões de responsabilidade. O nosso compromisso com a IA ética ajuda o nosso trabalho a ter um impacto positivo na sociedade e estabelece uma referência para práticas de IA responsáveis em todo o mundo.

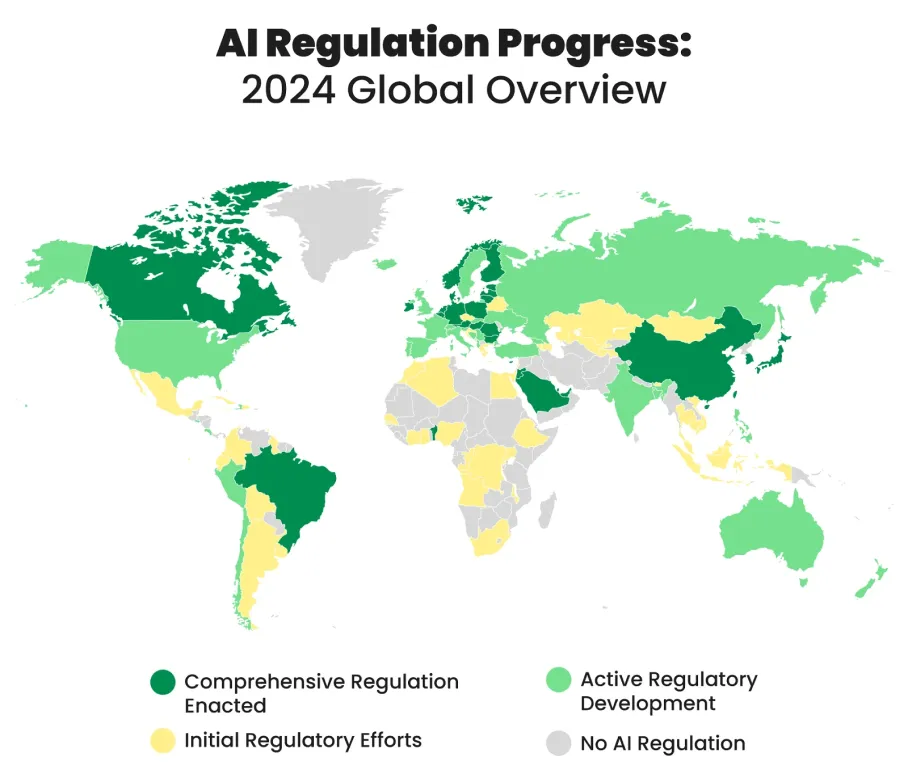

Vários países em todo o mundo estão desenvolvendo e implementando regulamentações de IA para orientar o uso ético e responsável das tecnologias de IA. Essas regulamentações visam equilibrar a inovação com considerações morais e proteger indivíduos e a sociedade de potenciais riscos associados às inovações de IA.

Aqui estão alguns exemplos de medidas tomadas em todo o mundo para regular o uso da IA:

Promover a IA ética é mais fácil do que se pensa. Ao aprender mais sobre questões como parcialidade, transparência e privacidade, pode tornar-se uma voz ativa na conversa em torno da IA ética. Apoie e siga as diretrizes éticas, verifique regularmente a equidade e proteja a privacidade dos dados. Ao utilizar ferramentas de IA como o ChatGPT, ser transparente sobre a sua utilização ajuda a criar confiança e torna a IA mais ética. Ao tomar estas medidas, pode ajudar a promover a IA que é desenvolvida e utilizada de forma justa, transparente e responsável.

Na Ultralytics, estamos comprometidos com a IA ética. Se você quiser ler mais sobre nossas soluções de IA e ver como mantemos uma mentalidade ética, confira nosso repositório GitHub, junte-se à nossa comunidade e explore nossas soluções mais recentes em setores como saúde e manufatura! 🚀