Присоединяйтесь к нам, чтобы погрузиться в модель Segment Anything Model 2SAM 2) от Meta AI и понять, для каких применений в реальном времени она может использоваться в различных отраслях.

Присоединяйтесь к нам, чтобы погрузиться в модель Segment Anything Model 2SAM 2) от Meta AI и понять, для каких применений в реальном времени она может использоваться в различных отраслях.

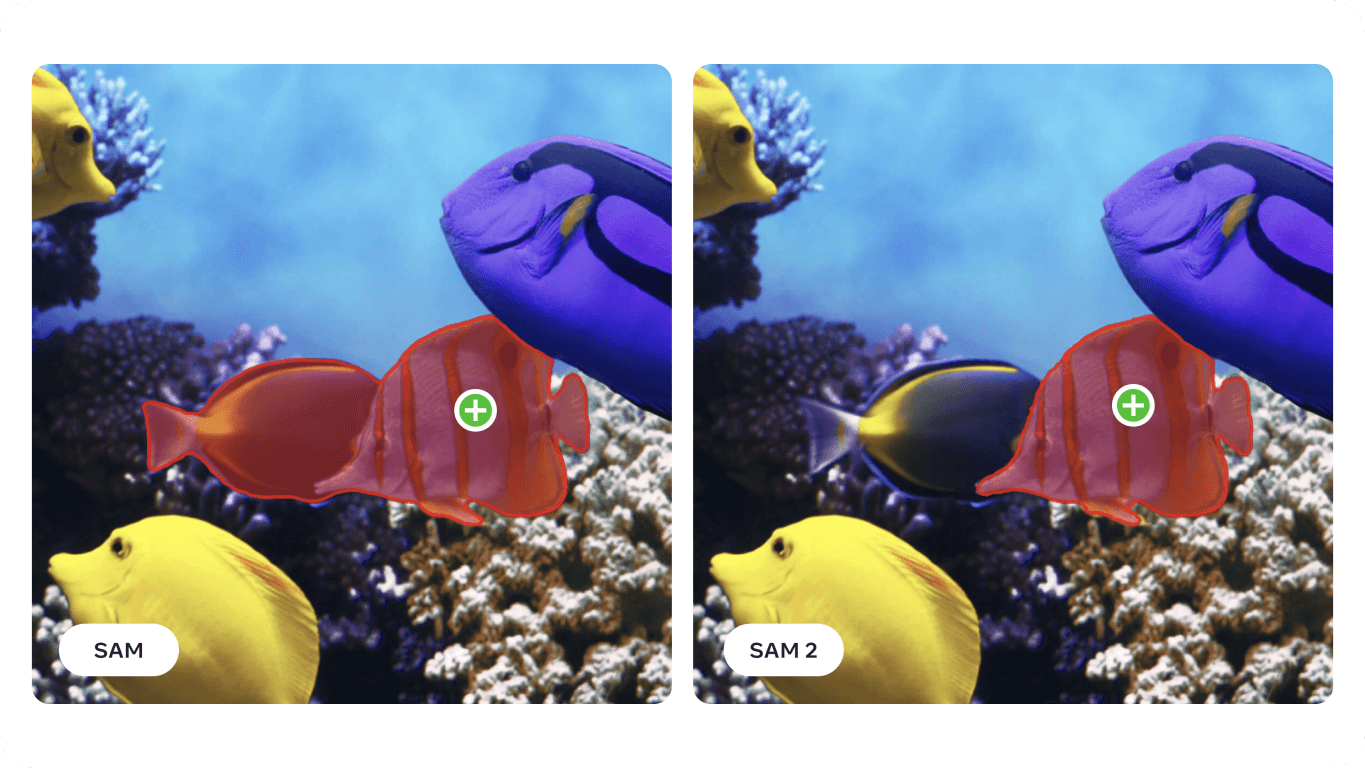

29 июля 2024 года компания Meta AI выпустила вторую версию своей модели Segment Anything Model, SAM 2. Новая модель может точно определить, какие пиксели принадлежат целевому объекту как на изображениях, так и на видео! Самое приятное, что модель способна последовательно отслеживать объект на всех кадрах видео в режиме реального времени. SAM 2 открывает захватывающие возможности для редактирования видео, создания смешанной реальности и более быстрого аннотирования визуальных данных для обучения систем компьютерного зрения.

Основываясь на успехе оригинального SAM, который использовался в таких областях, как морские науки, спутниковая съемка и медицина, SAM 2 решает такие задачи, как быстро движущиеся объекты и изменения внешнего вида. Повышенная точность и эффективность делают его универсальным инструментом для широкого спектра приложений. В этой статье мы расскажем о том, где можно применитьSAM 2 и почему он важен для сообщества ИИ.

Segment Anything Model 2 - это усовершенствованная базовая модель, поддерживающая оперативную визуальную сегментацию или PVS как на изображениях, так и на видео. PVS - это техника, при которой модель может segment или идентифицировать различные части изображения или видео на основе определенных подсказок или вводов, сделанных пользователем. Эти подсказки могут быть в виде щелчков, квадратиков или масок, которые выделяют интересующую область. Затем модель генерирует маску сегментации, которая очерчивает указанную область.

Архитектура SAM 2 развивает оригинальную SAM , расширяя возможности сегментации изображений до сегментации видео. Она оснащена легким декодером масок, который использует данные изображения и подсказки для создания масок сегментации. Для видео SAM 2 представляет систему памяти, которая помогает запоминать информацию из предыдущих кадров, обеспечивая точное отслеживание во времени. Система памяти включает компоненты, которые хранят и запоминают информацию о сегментируемых объектах. SAM 2 также может обрабатывать окклюзии, track объекты на протяжении нескольких кадров и справляться с неоднозначными подсказками, генерируя несколько возможных масок. Передовая архитектура SAM 2 обеспечивает высокую производительность как в статичных, так и в динамичных визуальных средах.

В частности, при сегментации видео SAM 2 достигает более высокой точности при втрое меньшем количестве взаимодействий с пользователем по сравнению с предыдущими методами. Для сегментации изображений SAM 2 превосходит оригинальную модель Segment Anything Model (SAM), будучи в шесть раз быстрее и точнее. Это улучшение было продемонстрировано в исследовательской работе SAM 2 на 37 различных наборах данных, включая 23, на которых ранее тестировалась SAM .

Интересно, что SAM 2 от Meta AI был разработан на основе крупнейшего на сегодняшний день набора данных по сегментации видео - SA-V. Эта обширная база данных включает более 50 000 видео и 35,5 млн масок сегментации и была собрана благодаря интерактивному вкладу пользователей. Аннотаторы давали подсказки и вносили коррективы, чтобы помочь модели обучаться на основе широкого спектра сценариев и типов объектов.

Благодаря расширенным возможностям сегментации изображений и видео SAM 2 может использоваться в различных отраслях. Давайте рассмотрим некоторые из них.

Новая модель сегментации Meta AI может использоваться в приложениях дополненной реальности (AR) и виртуальной реальности (VR). Например, SAM 2 может точно идентифицировать и segment объекты реального мира и сделать взаимодействие с виртуальными объектами более реалистичным. Это может быть полезно в различных областях, таких как игры, образование и обучение, где необходимо реалистичное взаимодействие между виртуальными и реальными элементами.

Поскольку такие устройства, как AR-очки, становятся все более совершенными, возможности SAM 2 вскоре могут быть интегрированы в них. Представьте, что вы надеваете очки и осматриваете свою гостиную. Когда очки segment и заметят миску с водой для вашей собаки, они могут напомнить вам, что ее нужно наполнить, как показано на изображении ниже. Или, если вы готовите новый рецепт, очки могут определить ингредиенты на столешнице и дать пошаговые инструкции и советы, улучшая процесс приготовления и обеспечивая наличие всего необходимого под рукой.

Исследования с использованием модели SAM показали, что она может быть применена в специализированных областях, таких как сонарная съемка. Сонарная съемка сопряжена с уникальными трудностями, обусловленными низким разрешением, высоким уровнем шума и сложной формой объектов на изображениях. Настроив SAM для сонарных изображений, исследователи продемонстрировали его способность точно segment различные подводные объекты, такие как морской мусор, геологические образования и другие объекты, представляющие интерес. Точная и надежная подводная съемка может использоваться в морских исследованиях, подводной археологии, рыболовстве и наблюдении для решения таких задач, как картирование среды обитания, обнаружение артефактов и выявление угроз.

%25252525201.png)

Поскольку SAM 2 развивает и совершенствует многие из проблем, с которыми столкнулся SAM , он способен еще больше улучшить анализ гидролокационных изображений. Его возможности точной сегментации могут помочь в различных морских приложениях, включая научные исследования и рыболовство. Например, SAM 2 может эффективно очерчивать подводные структуры, detect морской мусор и идентифицировать объекты на гидролокационных изображениях, способствуя более точной и эффективной подводной разведке и мониторингу.

Вот потенциальные преимущества использования SAM 2 для анализа изображений, полученных с помощью гидролокатора:

Интегрировав SAM 2 в процессы формирования гидролокационных изображений, морская промышленность сможет добиться более высокой эффективности, точности и надежности подводной разведки и анализа, что в конечном итоге приведет к улучшению результатов морских исследований.

Еще одно применение SAM 2 - автономные транспортные средства. SAM 2 может точно идентифицировать такие объекты, как пешеходы, другие транспортные средства, дорожные знаки и препятствия в режиме реального времени. Уровень детализации, который обеспечивает SAM 2, необходим для принятия решений по безопасной навигации и предотвращению столкновений. Благодаря точной обработке визуальных данных SAM 2 помогает создать подробную и достоверную карту окружающей обстановки, что способствует принятию более эффективных решений.

Способность SAM 2 работать в различных условиях освещения, при смене погоды и в динамичных средах делает его надежным для автономных транспортных средств. Будь то оживленная городская улица или туманное шоссе, SAM 2 может последовательно идентифицировать и точно segment объекты, чтобы автомобиль мог правильно реагировать на различные ситуации.

Однако следует помнить о некоторых ограничениях. Для сложных, быстро движущихся объектов SAM 2 может иногда упускать мелкие детали, а его прогнозы могут быть нестабильными в разных кадрах. Кроме того, SAM 2 иногда может спутать несколько похожих объектов в многолюдных сценах. Именно поэтому интеграция дополнительных датчиков и технологий играет ключевую роль в приложениях для автономного вождения.

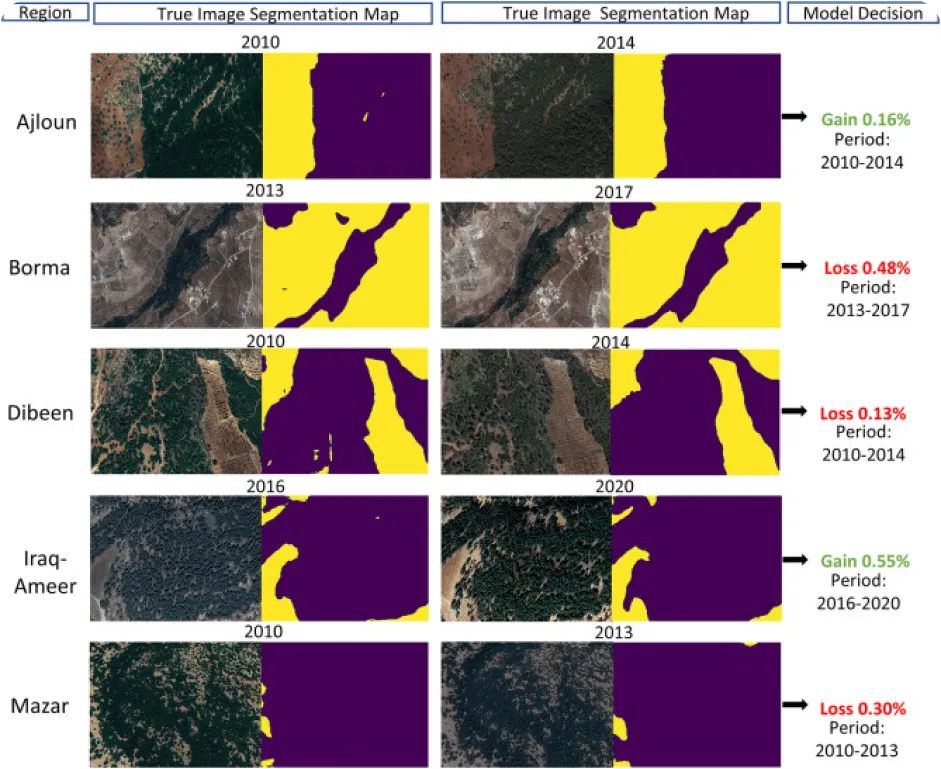

Мониторинг окружающей среды с помощью компьютерного зрения может быть непростой задачей, особенно когда не хватает аннотированных данных, но именно это и делает SAM 2 интересным приложением. SAM 2 можно использовать для track и анализа изменений в природных ландшафтах, точно сегментируя и идентифицируя различные экологические объекты, такие как леса, водоемы, городские и сельскохозяйственные территории, на снимках, полученных со спутников или беспилотников. В частности, точная сегментация помогает отслеживать обезлесение, урбанизацию и изменения в землепользовании с течением времени, предоставляя ценные данные для сохранения окружающей среды и планирования.

Вот некоторые преимущества использования такой модели, как SAM 2, для анализа изменений окружающей среды во времени:

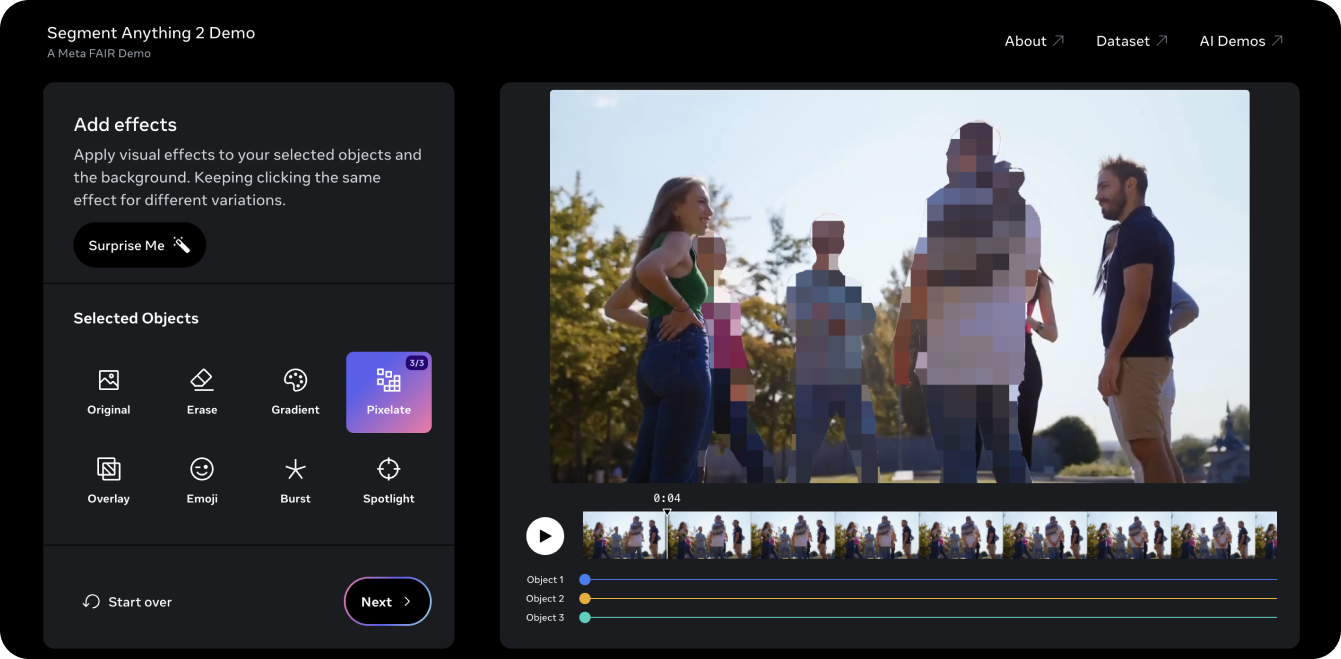

Демонстрация Segment Anything 2 - отличный способ опробовать модель на видео. Используя возможности PVS в SAM 2, мы взяли старое видеоUltralytics на YouTube и смогли segment три объекта или человека в видео и пикселизировать их. Традиционно редактирование трех людей из такого видео было бы трудоемким и утомительным и требовало бы ручного покадрового маскирования. Однако SAM 2 упрощает этот процесс. С помощью нескольких щелчков мыши на демонстрационном примере вы сможете защитить личность трех интересующих вас объектов за считанные секунды.

Демонстрация также позволяет опробовать несколько различных визуальных эффектов, таких как наведение прожектора на объекты, выбранные для отслеживания, и стирание отслеживаемых объектов. Если вам понравилась демонстрация и вы готовы начать внедрять инновации с помощью SAM 2, загляните на страницу документации по моделиUltralytics SAM 2, где вы найдете подробные инструкции по работе с моделью. Изучите возможности, шаги по установке и примеры, чтобы в полной мере использовать потенциал SAM 2 в своих проектах!

Модель Segment Anything Model 2SAM 2) компании Meta AI преобразует сегментацию видео и изображений. По мере совершенствования таких задач, как отслеживание объектов, мы открываем новые возможности в видеомонтаже, смешанной реальности, научных исследованиях и медицинской визуализации. Упрощая сложные задачи и ускоряя аннотирование, SAM 2 готов стать важным инструментом для сообщества ИИ. Продолжая исследовать и внедрять инновации с помощью таких моделей, как SAM 2, мы можем ожидать еще больше революционных приложений и достижений в различных областях!

Узнайте больше об ИИ, изучив наш репозиторий GitHub и присоединившись к нашему сообществу. Ознакомьтесь с нашими страницами решений для получения подробной информации об ИИ в производстве и здравоохранении. 🚀