Узнайте, почему важно подходить к AI этично, как регулируются AI во всем мире и какую роль вы можете сыграть в продвижении этичного использования AI.

Узнайте, почему важно подходить к AI этично, как регулируются AI во всем мире и какую роль вы можете сыграть в продвижении этичного использования AI.

По мере того как технология искусственного интеллекта становится все более популярной, все чаще возникают дискуссии об этичности использования искусственного интеллекта (ИИ). Поскольку многие из нас ежедневно используют такие инструменты на базе ИИ, как ChatGPT , есть все основания задуматься о том, насколько безопасно и морально корректно мы используем ИИ. Данные - основа всех систем ИИ, и многие приложения ИИ используют личные данные, такие как изображения вашего лица, финансовые операции, медицинские записи, сведения о вашей работе или местоположении. Куда деваются эти данные и как с ними обращаться? Вот некоторые из вопросов, на которые пытается ответить этический ИИ и заставить пользователей ИИ осознать это.

Когда мы обсуждаем этические вопросы, связанные с ИИ, легко увлечься и прийти к поспешным выводам, думая о таких сценариях, как «Терминатор» и роботы, захватывающие власть. Однако ключ к пониманию того, как подходить к этическому ИИ на практике, прост и довольно понятен. Все дело в создании, внедрении и использовании ИИ справедливым, прозрачным и ответственным образом. В этой статье мы рассмотрим, почему ИИ должен оставаться этичным, как создавать этичные инновации в области ИИ и что вы можете сделать для содействия этичному использованию ИИ. Давайте начнем!

Прежде чем мы углубимся в особенности этичного ИИ, давайте подробнее рассмотрим, почему он стал такой важной темой для обсуждения в сообществе ИИ и что именно означает, что ИИ является этичным.

Этика в отношении ИИ — не новая тема для обсуждения. Она обсуждается с 1950-х годов. В то время Алан Тьюринг представил концепцию машинного интеллекта и тест Тьюринга, меру способности машины демонстрировать человеческий интеллект посредством разговора, что положило начало ранним этическим дискуссиям об ИИ. С тех пор исследователи комментировали и подчеркивали важность учета этических аспектов ИИ и технологий. Однако только недавно организации и правительства начали создавать правила, предписывающие этичный ИИ.

Для этого есть три основные причины:

Поскольку ИИ становится все более продвинутым и привлекает все больше внимания во всем мире, разговор об этичном ИИ становится неизбежным.

Чтобы по-настоящему понять, что значит этичный ИИ, нам необходимо проанализировать проблемы, с которыми сталкивается этичный ИИ. Эти проблемы охватывают широкий круг вопросов, включая предвзятость, конфиденциальность, подотчетность и безопасность. Некоторые из этих пробелов в этичном ИИ были обнаружены со временем путем внедрения решений ИИ с несправедливой практикой, в то время как другие могут возникнуть в будущем.

.webp)

Вот некоторые из ключевых этических проблем в ИИ:

Решая эти задачи, мы можем разрабатывать системы ИИ, приносящие пользу обществу.

Далее, давайте рассмотрим, как внедрить этичные решения в области ИИ, которые решают каждую из упомянутых выше проблем. Сосредоточившись на ключевых областях, таких как создание непредвзятых моделей ИИ, обучение заинтересованных сторон, уделение приоритетного внимания конфиденциальности и обеспечение безопасности данных, организации могут создавать системы ИИ, которые будут одновременно эффективными и этичными.

Создание непредвзятых моделей ИИ начинается с использования разнообразных и репрезентативных наборов данных для обучения. Регулярные проверки и методы выявления предвзятости помогают выявлять и смягчать предвзятости. Такие методы, как передискретизация или перевзвешивание, могут сделать данные для обучения более справедливыми. Сотрудничество с экспертами в предметной области и привлечение разнообразных команд к разработке также может помочь распознать и устранить предвзятости с разных точек зрения. Эти шаги помогают предотвратить несправедливое предпочтение какой-либо конкретной группы системами ИИ.

.webp)

Чем больше вы знаете о черном ящике ИИ, тем менее пугающим он становится, что делает важным для всех, кто вовлечен в проект ИИ, понимать, как работает ИИ, лежащий в основе любого приложения. Заинтересованные стороны, включая разработчиков, пользователей и лиц, принимающих решения, могут лучше решать этические последствия ИИ, когда у них есть всестороннее понимание различных концепций ИИ. Обучающие программы и семинары по таким темам, как предвзятость, прозрачность, подотчетность и конфиденциальность данных, могут сформировать это понимание. Подробная документация, объясняющая системы ИИ и процессы принятия ими решений, может помочь укрепить доверие. Регулярное общение и обновления об этических методах ИИ также могут стать отличным дополнением к организационной культуре.

Приоритет конфиденциальности означает разработку надежных политик и практик для защиты персональных данных. AI-системы должны использовать данные, полученные с надлежащего согласия, и применять методы минимизации данных, чтобы ограничить объем обрабатываемой личной информации. Шифрование и анонимизация могут дополнительно защитить конфиденциальные данные.

Крайне важно соблюдать правила защиты данных, такие как GDPR (Общий регламент по защите данных). GDPR устанавливает правила сбора и обработки личной информации от физических лиц в Европейском Союзе. Важно также быть прозрачным в отношении сбора, использования и хранения данных. Регулярные оценки воздействия на конфиденциальность могут выявить потенциальные риски и поддержать сохранение конфиденциальности в качестве приоритета.

В дополнение к конфиденциальности, безопасность данных необходима для создания этичных систем AI. Надежные меры кибербезопасности защищают данные от утечек и несанкционированного доступа. Регулярные проверки безопасности и обновления необходимы для того, чтобы не отставать от развивающихся угроз.

AI-системы должны включать функции безопасности, такие как контроль доступа, безопасное хранение данных и мониторинг в режиме реального времени. Четкий план реагирования на инциденты помогает организациям быстро решать любые проблемы безопасности. Демонстрируя приверженность безопасности данных, организации могут укрепить доверие среди пользователей и заинтересованных сторон.

В Ultralytics этичный ИИ - это основной принцип, которым мы руководствуемся в своей работе. Как говорит Гленн Джочер, основатель и генеральный директор компании: "Этичный ИИ - это не просто возможность, это необходимость. Понимая и соблюдая нормативные требования, мы можем обеспечить ответственное развитие и использование технологий ИИ по всему миру. Главное - сбалансировать инновации и честность, чтобы ИИ служил человечеству в позитивном и полезном ключе. Давайте подадим пример и покажем, что ИИ может быть силой добра".

Эта философия побуждает нас уделять приоритетное внимание справедливости, прозрачности и подотчетности в наших решениях ИИ. Интегрируя эти этические соображения в наши процессы разработки, мы стремимся создавать технологии, которые расширяют границы инноваций и соответствуют самым высоким стандартам ответственности. Наша приверженность этичному ИИ помогает нашей работе оказывать положительное влияние на общество и устанавливает эталон ответственной практики ИИ во всем мире.

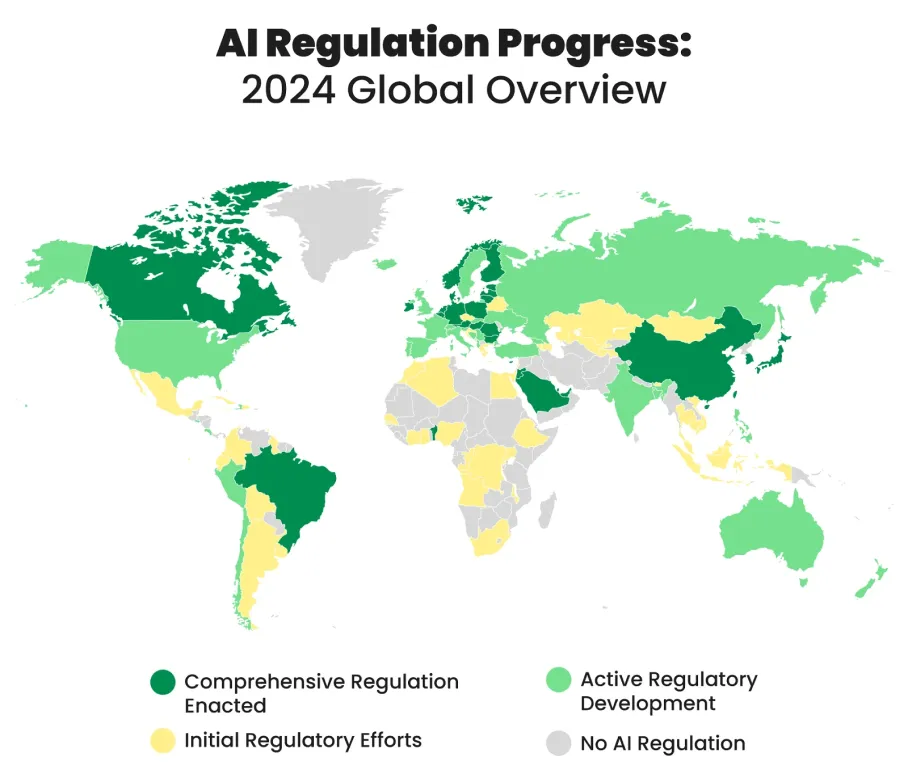

Многие страны мира разрабатывают и внедряют правила в области ИИ для руководства этичным и ответственным использованием технологий ИИ. Эти правила направлены на то, чтобы сбалансировать инновации с моральными соображениями и защитить людей и общество от потенциальных рисков, связанных с инновациями в области ИИ.

Вот несколько примеров шагов, предпринятых в разных странах мира для регулирования использования ИИ:

Продвигать этичный ИИ проще, чем кажется. Узнав больше о таких вопросах, как предвзятость, прозрачность и конфиденциальность, вы сможете стать активным участником разговора об этичном ИИ. Поддерживайте и соблюдайте этические нормы, регулярно проверяйте справедливость и защищайте конфиденциальность данных. При использовании инструментов ИИ, таких как ChatGPT, прозрачность их использования помогает укрепить доверие и делает ИИ более этичным. Предпринимая эти шаги, вы можете способствовать развитию ИИ, который разрабатывается и используется честно, прозрачно и ответственно.

Мы в Ultralytics придерживаемся этических принципов ИИ. Если вы хотите узнать больше о наших решениях в области ИИ и увидеть, как мы придерживаемся этических принципов, загляните в наш репозиторий GitHub, присоединяйтесь к нашему сообществу и изучите наши новейшие решения в таких отраслях, как здравоохранение и производство! 🚀