Rejoignez-nous pour plonger dans le Segment Anything Model 2SAM 2) de Meta AI et comprendre quelles sont les applications en temps réel pour lesquelles il peut être utilisé dans diverses industries.

Rejoignez-nous pour plonger dans le Segment Anything Model 2SAM 2) de Meta AI et comprendre quelles sont les applications en temps réel pour lesquelles il peut être utilisé dans diverses industries.

Le 29 juillet 2024, Meta AI a publié la deuxième version de son modèle Segment Anything, SAM 2. Le nouveau modèle peut déterminer avec précision quels pixels appartiennent à un objet cible, que ce soit dans des images ou des vidéos ! Le plus beau, c'est que le modèle est capable de suivre un objet de manière cohérente sur toutes les images d'une vidéo en temps réel. SAM 2 ouvre des perspectives passionnantes pour le montage vidéo, les expériences de réalité mixte et l'annotation plus rapide des données visuelles pour l'apprentissage des systèmes de vision par ordinateur.

S'appuyant sur le succès du SAM original, qui a été utilisé dans des domaines tels que les sciences marines, l'imagerie satellitaire et la médecine, SAM 2 relève des défis tels que les objets en mouvement rapide et les changements d'apparence. Sa précision et son efficacité accrues en font un outil polyvalent pour un large éventail d'applications. Dans cet article, nous nous concentrerons sur les domaines d'application deSAM 2 et sur son importance pour la communauté de l'IA.

Le modèle Segment Anything Model 2 est un modèle de base avancé qui prend en charge la segmentation visuelle prompte ou PVS dans les images et les vidéos. La PVS est une technique dans laquelle un modèle peut segment ou identifier différentes parties d'une image ou d'une vidéo en fonction d'invites ou d'entrées spécifiques données par l'utilisateur. Ces invites peuvent prendre la forme de clics, de cases ou de masques qui mettent en évidence la zone d'intérêt. Le modèle génère alors un masque de segmentation qui délimite la zone spécifiée.

L'architecture SAM 2 s'appuie sur l'architecture SAM originale en élargissant la segmentation des images à la segmentation des vidéos. Elle comporte un décodeur de masque léger qui utilise des données d'image et des invites pour créer des masques de segmentation. Pour les vidéos, SAM 2 introduit un système de mémoire qui l'aide à se souvenir des informations des images précédentes, garantissant ainsi un suivi précis dans le temps. Le système de mémoire comprend des composants qui stockent et rappellent des détails sur les objets en cours de segmentation. SAM 2 peut également gérer les occlusions, track objets sur plusieurs images et gérer les messages ambigus en générant plusieurs masques possibles. L'architecture avancée de SAM 2 lui confère une grande capacité dans les environnements visuels statiques et dynamiques.

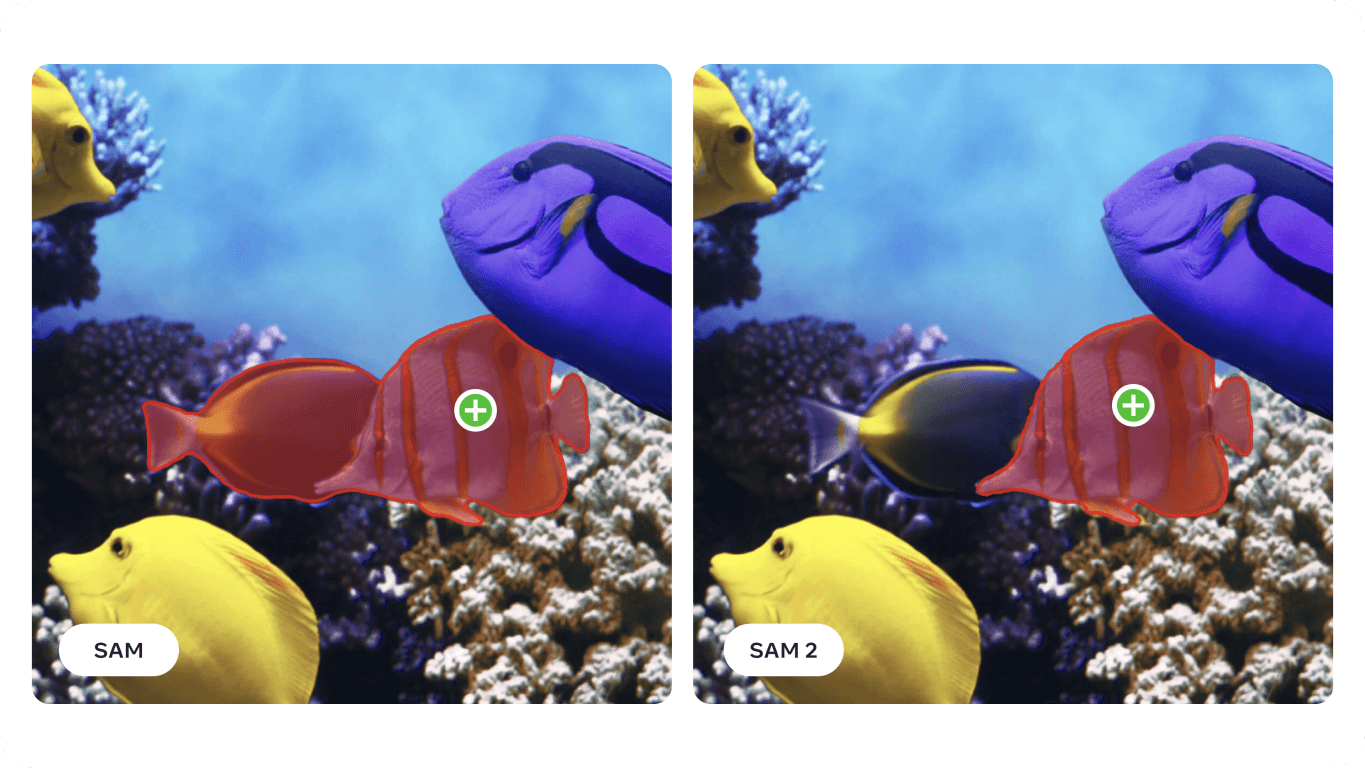

Plus précisément, en ce qui concerne la segmentation vidéo, SAM 2 atteint une plus grande précision avec trois fois moins d'interactions avec l'utilisateur que les méthodes précédentes. Pour la segmentation d'images, SAM 2 surpasse le modèle original Segment Anything Model (SAM), en étant six fois plus rapide et plus précis. Cette amélioration a été présentée dans le document de recherche SAM 2 sur 37 ensembles de données différents, dont 23 sur lesquels SAM avait déjà été testé.

Il est intéressant de noter que SAM 2 de Meta AI a été développé en créant le plus grand ensemble de données de segmentation vidéo à ce jour, l'ensemble de données SA-V. Ce vaste ensemble de données comprend plus de 50 000 vidéos et 35,5 millions de masques de segmentation et a été collecté grâce aux contributions interactives des utilisateurs. Les annotateurs ont fourni des invites et des corrections pour aider le modèle à apprendre à partir d'une grande variété de scénarios et de types d'objets.

Grâce à ses capacités avancées en matière de segmentation d'images et de vidéos, SAM 2 peut être utilisé dans divers secteurs d'activité. Explorons quelques-unes de ces applications.

Le nouveau modèle de segmentation de Meta AI peut être utilisé pour des applications de réalité augmentée (AR) et de réalité virtuelle (VR). Par exemple, SAM 2 peut identifier et segment avec précision segment objets du monde réel et rendre l'interaction avec des objets virtuels plus réaliste. Il peut être utile dans divers domaines tels que les jeux, l'éducation et la formation, où une interaction réaliste entre les éléments virtuels et réels est essentielle.

Les dispositifs tels que les lunettes AR étant de plus en plus perfectionnés, les capacités de SAM 2 pourraient bientôt y être intégrées. Imaginez que vous mettiez des lunettes et que vous regardiez autour de vous dans votre salon. Lorsque vos lunettes segment et remarquent la gamelle d'eau de votre chien, elles peuvent vous rappeler de la remplir, comme le montre l'image ci-dessous. Ou encore, si vous préparez une nouvelle recette, les lunettes pourraient identifier les ingrédients sur votre plan de travail et vous fournir des instructions et des conseils étape par étape, améliorant ainsi votre expérience culinaire et vous assurant que vous avez tous les éléments nécessaires à portée de main.

La recherche utilisant le modèle SAM a montré qu'il peut être appliqué dans des domaines spécialisés tels que l'imagerie sonar. L'imagerie sonar présente des défis uniques en raison de sa faible résolution, des niveaux de bruit élevés et des formes complexes des objets dans les images. En affinant la SAM pour les images sonar, les chercheurs ont démontré sa capacité à segment avec précision divers objets sous-marins tels que les débris marins, les formations géologiques et d'autres éléments d'intérêt. L'imagerie sous-marine précise et fiable peut être utilisée dans la recherche marine, l'archéologie sous-marine, la gestion des pêches et la surveillance pour des tâches telles que la cartographie de l'habitat, la découverte d'artefacts et la détection des menaces.

%25252525201.png)

SAM 2 s'appuie sur les nombreux défis auxquels SAM est confronté et les améliore, ce qui devrait permettre d'améliorer encore l'analyse de l'imagerie sonar. Ses capacités de segmentation précise peuvent contribuer à diverses applications marines, notamment dans le domaine de la recherche scientifique et de la pêche. Par exemple, SAM 2 peut délimiter efficacement les structures sous-marines, detect débris marins et identifier les objets dans les images sonar prospectives, contribuant ainsi à une exploration et à une surveillance sous-marines plus précises et plus efficaces.

Voici les avantages potentiels de l'utilisation de SAM 2 pour analyser l'imagerie sonar :

En intégrant SAM 2 dans les processus d'imagerie sonar, l'industrie marine peut améliorer l'efficacité, la précision et la fiabilité de l'exploration et de l'analyse sous-marines, ce qui se traduit en fin de compte par de meilleurs résultats dans la recherche marine.

Les véhicules autonomes constituent une autre application de SAM 2. SAM 2 peut identifier avec précision et en temps réel des objets tels que les piétons, les autres véhicules, les panneaux de signalisation et les obstacles. Le niveau de détail que SAM 2 peut fournir est essentiel pour prendre des décisions sûres en matière de navigation et d'évitement des collisions. En traitant les données visuelles avec précision, SAM 2 aide à créer une carte détaillée et fiable de l'environnement et permet de prendre de meilleures décisions.

La capacité de SAM 2 à fonctionner dans différentes conditions d'éclairage, de changements météorologiques et d'environnements dynamiques le rend fiable pour les véhicules autonomes. Qu'il s'agisse d'une rue urbaine animée ou d'une autoroute brumeuse, SAM 2 peut constamment identifier et segment objets avec précision afin que le véhicule puisse réagir correctement à diverses situations.

Cependant, il faut garder à l'esprit certaines limites. Dans le cas d'objets complexes se déplaçant rapidement, SAM 2 peut parfois manquer de fins détails et ses prédictions peuvent devenir instables d'une image à l'autre. En outre, SAM 2 peut parfois confondre plusieurs objets d'apparence similaire dans des scènes très fréquentées. Ces défis expliquent pourquoi l'intégration de capteurs et de technologies supplémentaires est essentielle dans les applications de conduite autonome.

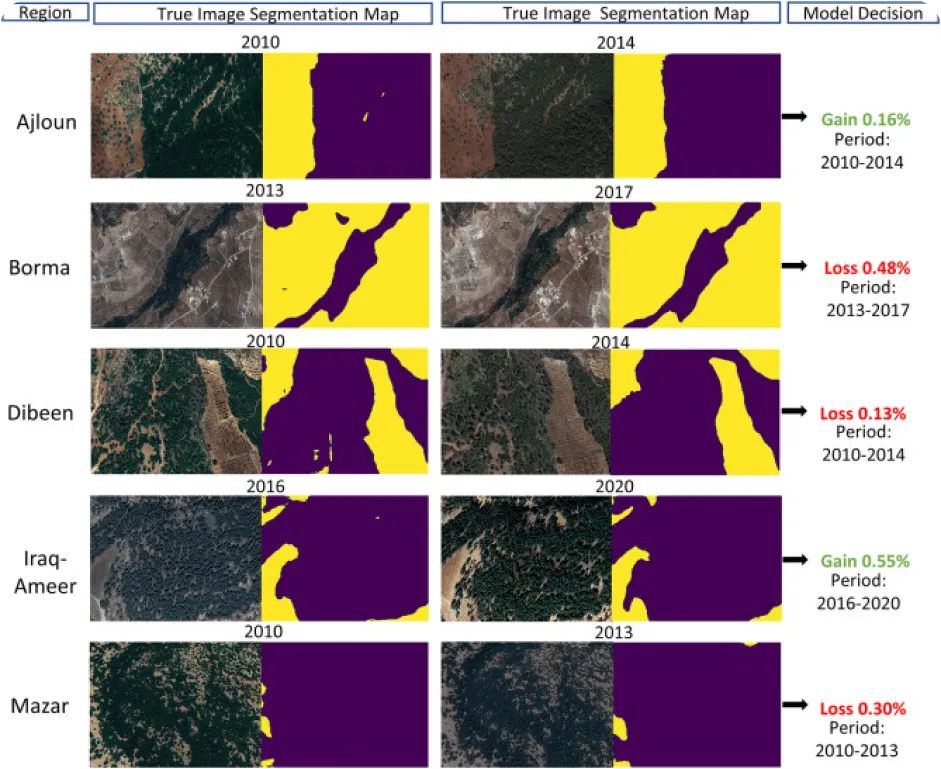

La surveillance de l'environnement à l'aide de la vision par ordinateur peut être délicate, en particulier lorsqu'il y a un manque de données annotées, mais c'est aussi ce qui en fait une application intéressante pour SAM 2. SAM 2 peut être utilisé pour track et analyser les changements dans les paysages naturels en segmentant et en identifiant avec précision diverses caractéristiques environnementales telles que les forêts, les plans d'eau, les zones urbaines et les terres agricoles à partir d'images satellite ou de drone. Plus précisément, une segmentation précise permet de surveiller la déforestation, l'urbanisation et les changements dans l'utilisation des terres au fil du temps, afin de fournir des données précieuses pour la conservation et la planification de l'environnement.

Voici quelques-uns des avantages de l'utilisation d'un modèle tel que SAM 2 pour analyser les changements environnementaux au fil du temps :

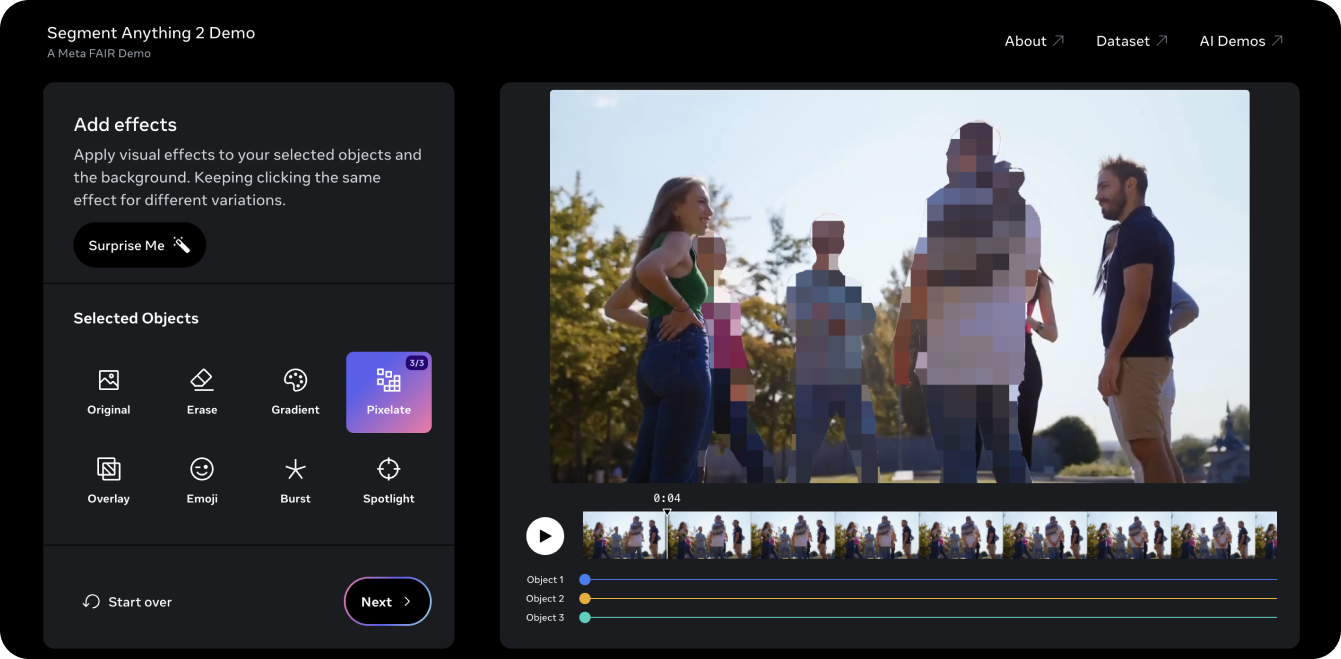

La démonstration Segment Anything 2 est un excellent moyen d'essayer le modèle sur une vidéo. En utilisant les capacités PVS de SAM 2, nous avons pris une vieille vidéo YouTube d'Ultralytics et nous avons pu segment trois objets ou personnes dans la vidéo et les pixelliser. Traditionnellement, l'édition de trois personnes dans une vidéo comme celle-ci prendrait beaucoup de temps et serait fastidieuse, et nécessiterait un masquage manuel image par image. SAM 2 simplifie toutefois ce processus. En quelques clics sur la démo, vous pouvez protéger l'identité de trois objets d'intérêt en quelques secondes.

La démo vous permet également d'essayer quelques effets visuels différents, comme placer un projecteur sur les objets que vous sélectionnez pour le suivi et effacer les objets suivis. Si vous avez aimé la démo et que vous êtes prêt à commencer à innover avec SAM 2, consultez la page de documentation du modèleSAM 2 d 'Ultralytics pour obtenir des instructions détaillées sur l'utilisation du modèle. Explorez les fonctionnalités, les étapes d'installation et les exemples pour tirer pleinement parti du potentiel de SAM 2 dans vos projets !

Le Segment Anything Model 2SAM 2) de Meta AI transforme la segmentation des vidéos et des images. Avec l'amélioration de tâches telles que le suivi d'objets, nous découvrons de nouvelles opportunités dans l'édition vidéo, la réalité mixte, la recherche scientifique et l'imagerie médicale. En facilitant les tâches complexes et en accélérant les annotations, SAM 2 est prêt à devenir un outil important pour la communauté de l'IA. En continuant d'explorer et d'innover avec des modèles comme SAM 2, nous pouvons nous attendre à d'autres applications révolutionnaires et à des avancées dans différents domaines !

Apprenez-en davantage sur l'IA en explorant notre dépôt GitHub et en rejoignant notre communauté. Consultez nos pages de solutions pour obtenir des informations détaillées sur l'IA dans les secteurs de la fabrication et de la santé. 🚀