OpenAI의 새로운 GPT-4o를 살펴보세요. 기술과의 소통 방식을 바꾸는 실감 나는 상호 작용을 제공하는 고급 AI를 특징으로 합니다. 획기적인 기능을 살펴보세요!

OpenAI의 새로운 GPT-4o를 살펴보세요. 기술과의 소통 방식을 바꾸는 실감 나는 상호 작용을 제공하는 고급 AI를 특징으로 합니다. 획기적인 기능을 살펴보세요!

2024년 5월 13일 월요일, OpenAI는 새로운 플래그십 모델인 GPT-4o를 발표했습니다. 여기서 'o'는 'omni(옴니)'를 의미합니다. GPT-4o는 실시간 텍스트, 오디오 및 시각적 상호 작용을 위한 고급 멀티모달 AI 모델로, 더 빠른 처리 속도, 다국어 지원 및 향상된 안전성을 제공합니다.

이전에는 볼 수 없었던 제너레이티브 AI 기능을 제공합니다. ChatGPT 대화적 강점을 기반으로 한 GPT-4o의 기능은 사람들이 AI를 인식하는 방식에서 상당한 진전을 이루었습니다. 이제 우리는 마치 실제 사람처럼 GPT-4o와 대화할 수 있습니다. GPT-4o가 어떤 기능을 제공하는지 자세히 알아보세요!

OpenAI의 봄 업데이트에서 GPT-4o는 GPT-4만큼 지능적이지만 데이터 처리 속도가 더 빠르고 텍스트, 시각 및 오디오를 더 잘 처리할 수 있다는 사실이 밝혀졌습니다. 이전 릴리스에서는 모델을 더 스마트하게 만드는 데 중점을 두었지만, 이번 릴리스에서는 일반 대중이 AI를 더 쉽게 사용할 수 있도록 하는 데 중점을 두었습니다.

.png)

작년 말에 출시된 ChatGPT음성 모드는 세 가지 모델이 함께 음성 입력을 전사하고, 서면 응답을 이해 및 생성하며, 사용자가 응답을 들을 수 있도록 텍스트를 음성으로 변환하는 방식이었습니다. 이 모드는 지연 시간 문제가 있었고 자연스럽지 못했습니다. GPT-4o는 기본적으로 텍스트, 시각, 오디오를 한 번에 처리하여 사용자가 자연스러운 대화에 참여하고 있다는 인상을 줄 수 있습니다.

또한 음성 모드와 달리 이제 GPT-4o가 말하는 동안 중단할 수 있으며, GPT-4o는 마치 사람처럼 반응합니다. 일시 중지하고 듣고, 사용자가 말한 내용을 기반으로 실시간 응답을 제공합니다. 또한 음성을 통해 감정을 표현하고 사용자의 어조도 이해할 수 있습니다.

GPT-4o의 모델 평가는 이 모델이 얼마나 발전했는지 보여줍니다. 가장 흥미로운 결과 중 하나는 GPT-4o가 모든 언어, 특히 사용 빈도가 낮은 언어에서 Whisper-v3에 비해 음성 인식 기능을 크게 향상시켰다는 것입니다.

오디오 ASR(자동 음성 인식) 성능은 모델이 음성 언어를 텍스트로 얼마나 정확하게 변환하는지 측정합니다. GPT-4o의 성능은 단어 오류율(WER)로 추적되며, 이는 잘못 전사된 단어의 백분율을 나타냅니다(WER이 낮을수록 품질이 좋음). 아래 차트는 다양한 지역에서 GPT-4o의 낮은 WER을 보여주며, 이는 리소스가 부족한 언어에 대한 음성 인식 개선에 효과적임을 입증합니다.

.png)

다음은 GPT-4o의 몇 가지 고유한 기능입니다.

이제 휴대폰에서 GPT-4o를 꺼내 카메라를 켜고 친구에게 하듯이 GPT-4o에게 표정을 보고 기분을 맞춰보라고 요청할 수 있습니다. GPT-4o는 카메라를 통해 사용자를 보고 답변할 수 있습니다.

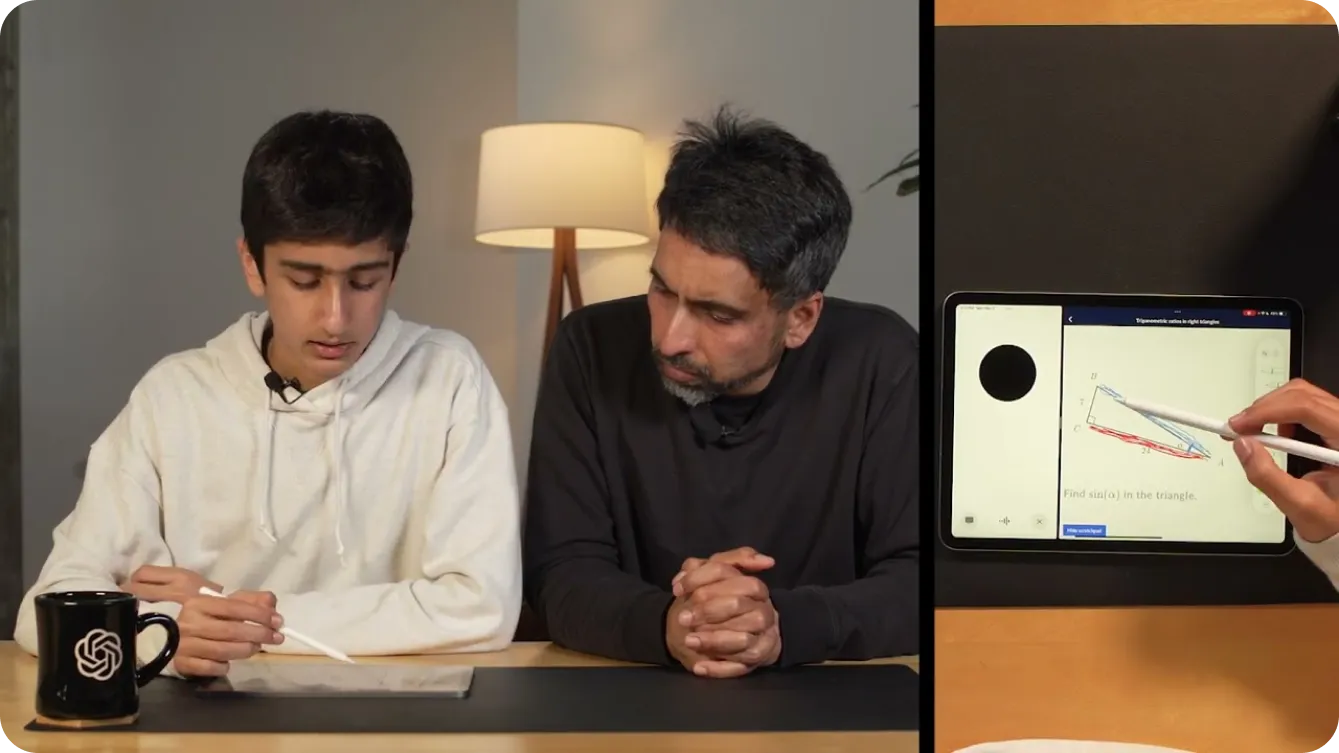

비디오를 통해 GPT-4o에게 사용자가 쓰고 있는 것을 보여줌으로써 수학 문제를 해결하는 데 도움을 받을 수도 있습니다. 또는 화면을 공유하여 GPT-4o가 칸 아카데미에서 유용한 튜터가 되어 아래와 같이 기하학에서 삼각형의 다른 부분을 가리키도록 요청할 수 있습니다.

아이들의 수학 학습을 돕는 것 외에도 개발자는 GPT-4o와 대화를 나누며 코드를 디버깅할 수 있습니다. 이는 데스크톱 앱으로 ChatGPT 도입한 덕분에 가능합니다. 데스크톱 GPT-4o 음성 앱과 대화하는 동안 CTRL "C"를 사용하여 코드를 강조 표시하고 복사하면 코드를 읽을 수 있습니다. 또는 다른 언어를 사용하는 개발자 간의 대화를 번역하는 데 사용할 수도 있습니다.

GPT-4o의 가능성은 무한해 보입니다. OpenAI의 가장 흥미로운 데모 중 하나는 두 대의 휴대폰을 사용하여 GPT-4o가 서로 다른 인스턴스와 대화하고 함께 노래하는 모습을 보여주었습니다.

데모에서 볼 수 있듯이 GPT-4o는 시각 장애가 있는 사람들에게 더 편리한 세상을 만들 수 있습니다. 상호 작용하고 더 안전하고 독립적으로 이동할 수 있도록 도와줍니다. 예를 들어, 사용자는 비디오를 켜고 GPT-4o에게 거리의 모습을 보여줄 수 있습니다. 그러면 GPT-4o는 장애물 식별, 도로 표지판 읽기 또는 특정 위치 안내와 같이 환경에 대한 실시간 설명을 제공할 수 있습니다. 택시가 다가올 때 알려 택시를 잡는 데 도움을 줄 수도 있습니다.

.png)

마찬가지로 GPT-4o는 고급 기능을 통해 다양한 산업을 혁신할 수 있습니다. 소매업에서는 실시간 지원을 제공하고, 문의에 응답하고, 고객이 온라인과 매장에서 제품을 찾는 데 도움을 주어 고객 서비스를 개선할 수 있습니다. 제품 선반을 보고 있는데 원하는 제품을 고를 수 없다고 가정해 봅시다. GPT-4o가 도와드릴 수 있습니다.

헬스케어 분야에서 GPT-4o는 환자 데이터를 분석하고, 증상에 따라 가능한 질병을 제시하고, 치료 옵션에 대한 지침을 제공하여 진단을 지원할 수 있습니다. 또한 환자 기록을 요약하고, 의료 문헌에 대한 빠른 액세스를 제공하며, 서로 다른 언어를 사용하는 환자와 소통하기 위해 실시간 언어 번역을 제공하여 의료 전문가를 지원할 수 있습니다. 이는 몇 가지 예에 불과합니다. GPT-4o의 응용 분야는 맞춤형 컨텍스트 인식 지원을 제공하고 정보 및 커뮤니케이션 장벽을 허물어 일상 생활을 더 편리하게 만듭니다.

수억 명의 삶에 영향을 미친 이전 버전의 GPT와 마찬가지로 GPT-4o는 전 세계적으로 실시간 오디오 및 비디오와 상호 작용할 가능성이 높으므로 안전이 이러한 응용 분야에서 중요한 요소가 됩니다. OpenAI는 잠재적 위험을 완화하는 데 중점을 두고 GPT-4o를 매우 신중하게 구축해 왔습니다.

안전과 신뢰성을 보장하기 위해 OpenAI는 엄격한 안전 조치를 구현했습니다. 여기에는 훈련 데이터 필터링, 훈련 후 모델 동작 개선, 음성 출력을 관리하기 위한 새로운 안전 시스템 통합이 포함됩니다. 또한 GPT-4o는 사회 심리학, 편향성 및 공정성, 허위 정보와 같은 분야에서 70명이 넘는 외부 전문가에 의해 광범위하게 테스트되었습니다. 외부 테스트를 통해 새로운 기능으로 인해 발생하거나 증폭되는 위험을 식별하고 해결할 수 있습니다.

높은 안전 기준을 유지하기 위해 OpenAI는 앞으로 몇 주에 걸쳐 GPT-4o의 기능을 점진적으로 출시할 예정입니다. 단계적 출시를 통해 OpenAI는 성능을 모니터링하고, 문제를 해결하고, 사용자 피드백을 수집할 수 있습니다. 신중한 접근 방식을 취함으로써 GPT-4o는 최고 수준의 안전 및 윤리적 사용을 유지하면서 고급 기능을 제공할 수 있습니다.

GPT-4o는 무료로 이용할 수 있습니다. 위에서 언급한 실시간 대화 기능을 사용해 보려면 Google Play 스토어 또는 Apple 앱 스토어에서 ChatGPT 앱을 휴대폰에 직접 다운로드할 수 있습니다.

로그인한 후 화면 오른쪽 상단의 세 개의 점을 탭하여 표시되는 목록에서 GPT-4o를 선택할 수 있습니다. GPT-4o가 활성화된 채팅으로 이동한 후 화면 왼쪽 하단의 더하기 기호를 탭하면 여러 입력 옵션이 표시됩니다. 화면 오른쪽 하단에서 헤드폰 아이콘을 볼 수 있습니다. 헤드폰 아이콘을 선택하면 GPT-4o의 핸즈프리 버전을 경험하고 싶은지 묻는 메시지가 표시됩니다. 동의하면 아래와 같이 GPT-4o를 사용해 볼 수 있습니다.

GPT-4o의 고급 기능을 자체 프로젝트에 통합하려면 개발자를 위한 API로 사용할 수 있습니다. 이를 통해 GPT-4o의 강력한 음성 인식, 다국어 지원 및 실시간 대화 기능을 애플리케이션에 통합할 수 있습니다. API를 사용하면 사용자 경험을 향상시키고, 더 스마트한 앱을 구축하고, 최첨단 AI 기술을 다양한 분야에 적용할 수 있습니다.

GPT-4o는 이전 AI 모델보다 훨씬 더 발전했지만, GPT-4o에는 자체적인 한계가 있다는 점을 기억하는 것이 중요합니다. OpenAI는 대화 중에 English 프랑스어로 임의로 언어를 전환하는 경우가 있다고 언급했습니다. 또한 GPT-4o가 언어 간 번역을 잘못하는 경우도 있었습니다. 더 많은 사람들이 이 모델을 사용해 보면 GPT-4o의 뛰어난 점과 개선이 필요한 부분을 파악할 수 있을 것입니다.

OpenAI의 GPT-4o는 고급 텍스트, 비전 및 오디오 처리 기능을 통해 AI의 새로운 지평을 열어 자연스럽고 인간과 유사한 상호 작용을 제공합니다. 속도, 비용 효율성 및 다국어 지원 측면에서 뛰어납니다. GPT-4o는 교육, 접근성 및 실시간 지원을 위한 다용도 도구입니다. 사용자가 GPT-4o의 기능을 탐색함에 따라 피드백은 발전을 이끌 것입니다. GPT-4o는 AI가 진정으로 우리 세상을 변화시키고 있으며 우리 일상 생활의 일부가 되고 있음을 입증합니다.

AI에 대해 더 자세히 알아보려면 GitHub 저장소를 탐색하고 커뮤니티에 참여하세요. AI가 제조업 및 농업과 같은 산업을 어떻게 변화시키고 있는지 보려면 솔루션 페이지를 방문하세요.