Мультимодальные модели и мультимодальное обучение: расширение возможностей ИИ

Узнайте, как мультимодальные модели объединяют текст, изображения, аудио и данные датчиков для повышения восприятия, рассуждения и принятия решений ИИ.

Узнайте, как мультимодальные модели объединяют текст, изображения, аудио и данные датчиков для повышения восприятия, рассуждения и принятия решений ИИ.

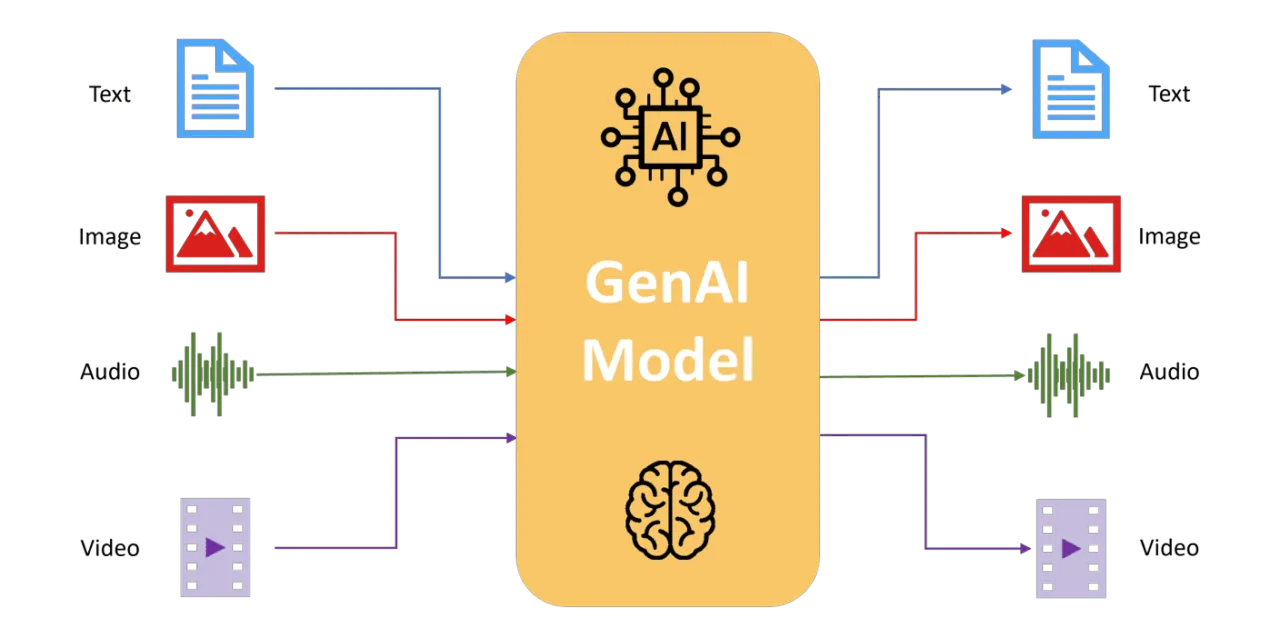

Традиционные системы ИИ обычно обрабатывают информацию из одного источника данных, такого как текст, изображения или аудио. Хотя эти унимодальные подходы превосходно справляются со специализированными задачами, они часто не могут справиться со сложными реальными сценариями, включающими несколько одновременных входных данных. Мультимодальное обучение решает эту проблему путем интеграции различных потоков данных в единую структуру, обеспечивая более глубокое и контекстно-зависимое понимание.

Вдохновленные человеческим восприятием, мультимодальные модели анализируют, интерпретируют и действуют на основе объединенных входных данных, подобно тому, как люди естественным образом интегрируют зрение, слух и речь. Эти модели позволяют ИИ справляться со сложными сценариями с большей точностью, надежностью и адаптивностью.

В этой статье мы рассмотрим эволюцию мультимодальных моделей, разберем принципы их работы, обсудим их практическое применение в области компьютерного зрения, а также оценим преимущества и проблемы, связанные с интеграцией нескольких типов данных.

Возможно, вам интересно, что именно представляет собой мультимодальное обучение и почему оно важно для искусственного интеллекта (ИИ). Традиционные модели ИИ обычно обрабатывают один тип данных за раз, будь то изображения, текст, аудио или данные с датчиков.

Мультимодальное обучение, однако, идет на шаг дальше, позволяя системам анализировать, интерпретировать и интегрировать несколько различных потоков данных одновременно. Этот подход очень похож на то, как человеческий мозг естественным образом объединяет визуальные, слуховые и лингвистические входные данные для формирования целостного понимания мира.

Объединяя эти различные модальности, мультимодальный ИИ достигает более глубокого и нюансированного понимания сложных сценариев.

Например, при анализе видеоматериалов мультимодальная система обрабатывает не только визуальный контент, но и диалоги, звуки окружающей среды и сопровождающие субтитры.

Эта интегрированная перспектива позволяет ИИ улавливать контекст и нюансы, которые были бы упущены, если бы каждый тип данных анализировался независимо.

С практической точки зрения, мультимодальное обучение расширяет возможности ИИ. Оно поддерживает такие приложения, как создание подписей к изображениям, ответы на вопросы на основе визуального контекста, генерация реалистичных изображений из текстовых описаний и улучшение интерактивных систем за счет повышения их интуитивности и контекстной осведомленности.

Но как мультимодальные модели объединяют эти различные типы данных для достижения таких результатов? Давайте шаг за шагом разберем основные механизмы, лежащие в основе их успеха.

Мультимодальные модели ИИ достигают своих мощных возможностей благодаря специализированным процессам: раздельное извлечение признаков для каждой модальности (обработка каждого типа данных — например, изображений, текста или аудио — по отдельности), методы слияния (объединение извлеченных деталей) и передовые методы выравнивания (обеспечение согласованности объединенной информации).

Давайте подробнее рассмотрим, как работает каждый из этих процессов.

Мультимодальные модели ИИ используют различные специализированные архитектуры для каждого типа данных. Это означает, что визуальные, текстовые, аудио- или сенсорные входные данные обрабатываются системами, разработанными специально для них. Это позволяет модели улавливать уникальные детали каждого входного сигнала, прежде чем объединять их.

Вот несколько примеров того, как различные специализированные архитектуры используются для извлечения признаков из различных типов данных:

После индивидуальной обработки каждая модальность генерирует высокоуровневые признаки, оптимизированные для захвата уникальной информации, содержащейся в этом конкретном типе данных.

После извлечения признаков мультимодальные модели объединяют их в единое, согласованное представление. Для эффективного выполнения этой задачи используются различные стратегии объединения:

Наконец, мультимодальные системы используют передовые методы выравнивания и внимания, чтобы обеспечить эффективное соответствие данных из разных модальностей.

Такие методы, как контрастное обучение, помогают тесно выравнивать визуальные и текстовые представления в общем семантическом пространстве. Благодаря этому мультимодальные модели могут устанавливать прочные, значимые связи между различными типами данных, обеспечивая согласованность между тем, что модель "видит" и "читает".

Механизмы внимания на основе Transformer дополнительно улучшают это выравнивание, позволяя моделям динамически фокусироваться на наиболее релевантных аспектах каждого входного сигнала. Например, слои внимания позволяют модели напрямую связывать конкретные текстовые описания с соответствующими областями в визуальных данных, значительно повышая точность в сложных задачах, таких как визуальное вопросно-ответное взаимодействие (VQA) и создание подписей к изображениям.

Эти методы расширяют возможности мультимодального ИИ по глубокому пониманию контекста, позволяя ИИ предоставлять более тонкие и точные интерпретации сложных данных реального мира.

Мультимодальный ИИ значительно эволюционировал, переходя от ранних техник, основанных на правилах, к передовым системам глубокого обучения, способным к сложной интеграции.

На первых порах мультимодальные системы объединяли различные типы данных, такие как изображения, звук или данные датчиков, используя правила, созданные вручную экспертами-людьми или простыми статистическими методами. Например, ранние роботы-навигаторы объединяли изображения с камер с данными гидролокатора для detect и обхода препятствий. Несмотря на свою эффективность, эти системы требовали тщательной ручной разработки функций и были ограничены в способности к адаптации и обобщению.

С появлением глубокого обучения мультимодальные модели стали гораздо более популярными. Нейронные сети, такие как мультимодальные автоэнкодеры, начали изучать совместные представления различных типов данных, особенно изображений и текста, позволяя ИИ решать такие задачи, как межмодальный поиск и поиск изображений на основе только текстовых описаний.

Прогресс продолжался по мере того, как системы, такие как Visual Question Answering (VQA), интегрировали CNN для обработки изображений и RNN или Transformer для интерпретации текста. Это позволило моделям ИИ точно отвечать на сложные, зависящие от контекста вопросы о визуальном контенте.

Совсем недавно крупномасштабные мультимодальные модели, обученные на огромных наборах данных интернет-масштаба, еще больше революционизировали возможности ИИ.

Эти модели используют такие методы, как контрастное обучение, позволяя им выявлять обобщаемые взаимосвязи между визуальным контентом и текстовыми описаниями. Устраняя разрывы между модальностями, современные мультимодальные архитектуры расширили возможности ИИ для выполнения сложных задач визуального мышления с почти человеческой точностью, иллюстрируя, насколько далеко продвинулся мультимодальный ИИ со своих основополагающих этапов.

Теперь, когда мы изучили, как мультимодальные модели интегрируют различные потоки данных, давайте углубимся в то, как эти возможности можно применять к моделям компьютерного зрения.

Объединяя визуальный ввод с текстом, аудио или данными датчиков, мультимодальное обучение позволяет системам ИИ решать все более сложные, насыщенные контекстом задачи.

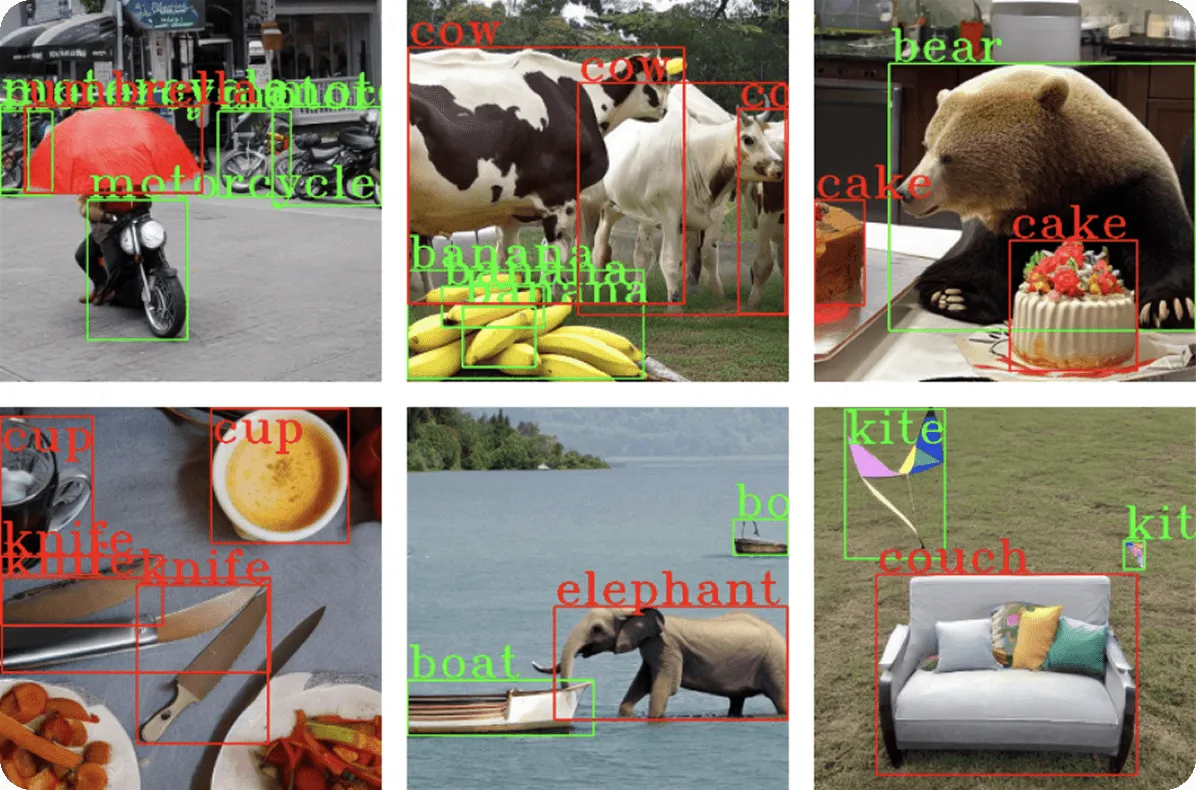

Создание подписей к изображениям включает в себя генерацию описаний на естественном языке для визуальных данных. Традиционные методы обнаружения объектов идентифицируют отдельные объекты, но мультимодальное создание подписей идет дальше, интерпретируя взаимосвязи и контексты.

Например, мультимодальная модель может проанализировать изображение людей на пикнике и сгенерировать описательную подпись, такую как “Семья на пикнике в солнечном парке”, предоставляя более богатый и доступный результат.

Это приложение важно для обеспечения доступности. Его можно использовать для создания замещающего текста для людей с нарушениями зрения и для маркировки контента для больших баз данных. Архитектуры Transformer играют здесь ключевую роль, позволяя модулю генерации текста фокусироваться на соответствующих визуальных областях с помощью механизмов внимания, динамически выравнивая текстовые описания с визуальными признаками.

Модели VQA отвечают на вопросы на естественном языке, основываясь на визуальном контенте, объединяя компьютерное зрение с пониманием языка. Эти задачи требуют детального понимания содержания изображения, контекста и семантического анализа.

Архитектуры Transformer улучшили VQA, позволив текстовым и визуальным компонентам модели динамически взаимодействовать, точно определяя области изображения, относящиеся к вопросу.

Например, в модели PaLI компанииGoogle используются передовые архитектуры на основе трансформаторов, объединяющие визуальные трансформаторы (ViT) с языковыми кодировщиками и декодировщиками, что позволяет точно отвечать на такие сложные вопросы, как "Что делает женщина на картинке?" или "Сколько животных видно?".

Слои внимания, которые помогают моделям сосредотачиваться на наиболее релевантных частях входных данных, обеспечивают динамическую связь каждого слова вопроса с визуальными сигналами, позволяя давать нюансированные ответы, выходящие за рамки простого обнаружения объектов.

Генерация изображений по тексту относится к способности ИИ создавать визуальный контент непосредственно из текстовых описаний, преодолевая разрыв между семантическим пониманием и визуальным созданием.

Мультимодальные модели, выполняющие эту задачу, используют передовые нейронные архитектуры, такие как трансформеры или диффузионные процессы, для генерации детализированных и контекстуально точных изображений.

Например, представьте себе генерацию синтетических данных для обучения моделей компьютерного зрения, предназначенных для обнаружения транспортных средств. На основе текстовых описаний, таких как «красный седан, припаркованный на оживленной улице» или «белый внедорожник, едущий по шоссе», эти мультимодальные модели могут создавать разнообразные высококачественные изображения, изображающие эти точные сценарии.

Такая возможность позволяет исследователям и разработчикам эффективно расширять наборы данных для обнаружения объектов без ручного сбора тысяч изображений, что значительно сокращает время и ресурсы, необходимые для сбора данных.

Более современные методы применяют методы на основе диффузии, начиная со случайного визуального шума и постепенно уточняя изображение, чтобы оно точно соответствовало текстовому вводу. Этот итеративный процесс позволяет создавать реалистичные и разнообразные примеры, обеспечивая надежные данные для обучения, охватывающие различные точки обзора, условия освещения, типы транспортных средств и фоны.

Этот подход особенно ценен в компьютерном зрении, поскольку позволяет быстро расширять наборы данных, повышать точность моделей и расширять разнообразие сценариев, которые могут надежно распознавать системы ИИ.

Мультимодальные системы поиска облегчают поиск, преобразуя текст и изображения в общий язык значений. Например, модели, обученные на огромных наборах данных, такие как CLIP, которая училась на миллионах пар изображений и текста, могут сопоставлять текстовые запросы с правильными изображениями, что приводит к более интуитивно понятным и точным результатам поиска.

Например, поисковый запрос, такой как «закат на пляже», возвращает визуально точные результаты, что значительно повышает эффективность обнаружения контента на платформах электронной коммерции, в медиаархивах и базах данных стоковых фотографий.

Мультимодальный подход обеспечивает точность поиска даже тогда, когда в запросах и описаниях изображений используются разные языки, благодаря изученным семантическим соответствиям между визуальными и текстовыми доменами.

Мультимодальное обучение предоставляет несколько ключевых преимуществ, которые расширяют возможности ИИ в компьютерном зрении и за его пределами:

Несмотря на эти сильные стороны, мультимодальные модели также имеют свой набор проблем:

Мультимодальное обучение меняет ИИ, обеспечивая более глубокое и контекстуальное понимание на основе множества потоков данных. Приложения в области компьютерного зрения, такие как создание подписей к изображениям, визуальные ответы на вопросы, генерация изображений из текста и улучшенный поиск изображений, демонстрируют потенциал интеграции различных модальностей.

Несмотря на сохраняющиеся вычислительные и этические проблемы, текущие инновации в архитектурах, такие как слияние на основе трансформеров и контрастное выравнивание, продолжают решать эти проблемы, продвигая мультимодальный ИИ к все более человекоподобному интеллекту.

По мере развития этой области мультимодальные модели станут необходимы для сложных, реальных задач ИИ, улучшая все, от медицинской диагностики до автономной робототехники. Внедрение мультимодального обучения позволяет отраслям использовать мощные возможности, которые определят будущее ИИ.

Присоединяйтесь к нашему растущему сообществу! Изучите наш репозиторий GitHub, чтобы узнать больше об AI. Готовы начать свои собственные проекты в области компьютерного зрения? Ознакомьтесь с нашими вариантами лицензирования. Узнайте об AI в производстве и Vision AI в самоуправляемых автомобилях, посетив страницы наших решений!