Çok modlu modeller ve çok modlu öğrenme: Yapay zekanın yeteneklerini genişletme

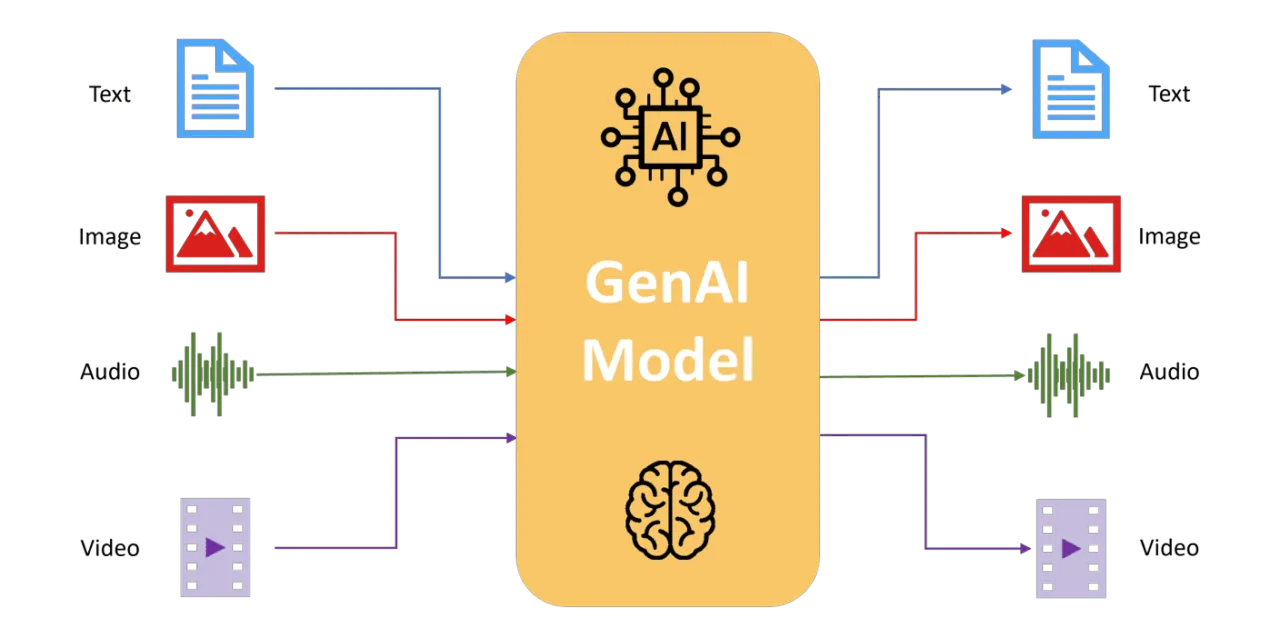

Çok modlu modellerin, yapay zeka algısını, akıl yürütmeyi ve karar almayı güçlendirmek için metin, görüntü, ses ve sensör verilerini nasıl entegre ettiğini keşfedin.

Çok modlu modellerin, yapay zeka algısını, akıl yürütmeyi ve karar almayı güçlendirmek için metin, görüntü, ses ve sensör verilerini nasıl entegre ettiğini keşfedin.

Geleneksel yapay zeka sistemleri genellikle metin, resim veya ses gibi tek bir veri kaynağından gelen bilgileri işler. Bu tek modlu yaklaşımlar uzmanlık gerektiren görevlerde başarılı olsa da, genellikle birden fazla eşzamanlı girdinin dahil olduğu karmaşık gerçek dünya senaryolarını işlemekte başarısız olur. Çok modlu öğrenme, çeşitli veri akışlarını birleşik bir çerçeve içinde entegre ederek, daha zengin ve bağlam açısından daha bilinçli bir anlayış sağlayarak bu sorunu çözer.

İnsan algısından ilham alan çok modlu modeller, insanlar gibi görme, duyma ve dil yeteneklerini doğal olarak entegre ederek birleşik girdilere göre analiz eder, yorumlar ve hareket eder. Bu modeller, yapay zekanın karmaşık senaryoları daha yüksek doğruluk, sağlamlık ve uyarlanabilirlik ile işlemesini sağlar.

Bu makalede, çok modlu modellerin nasıl evrimleştiğini inceleyecek, nasıl çalıştıklarını ayrıntılı olarak açıklayacak, bilgisayar görüşü içindeki pratik uygulamalarını tartışacak ve birden fazla veri türünü entegre etmenin avantajlarını ve zorluklarını değerlendireceğiz.

Çok modlu öğrenmenin tam olarak ne olduğunu ve yapay zeka (AI) için neden önemli olduğunu merak ediyor olabilirsiniz. Geleneksel yapay zeka modelleri tipik olarak aynı anda tek bir veri türünü işler; bu görüntüler, metin, ses veya sensör girdileri olabilir.

Ancak çok modlu öğrenme, sistemlerin aynı anda birden fazla farklı veri akışını analiz etmesini, yorumlamasını ve entegre etmesini sağlayarak bir adım daha ileri gider. Bu yaklaşım, insan beyninin dünya hakkında tutarlı bir anlayış oluşturmak için görsel, işitsel ve dilsel girdileri doğal olarak nasıl entegre ettiğini yakından yansıtır.

Çok modlu yapay zeka, bu farklı yöntemleri birleştirerek karmaşık senaryoların daha derin ve daha nüanslı bir şekilde anlaşılmasını sağlar.

Örneğin, video görüntülerini analiz ederken, çok modlu bir sistem sadece görsel içeriği işlemez; aynı zamanda konuşulan diyaloğu, ortam seslerini ve eşlik eden altyazıları da dikkate alır.

Bu entegre bakış açısı, yapay zekanın her veri türünün bağımsız olarak analiz edilmesi durumunda kaçırılacak bağlamı ve incelikleri yakalamasını sağlar.

Pratik olarak çok modlu öğrenme, yapay zekanın neler başarabileceğini genişletir. Görüntü açıklaması, görsel bağlama dayalı soruları yanıtlama, metin açıklamalarından gerçekçi görüntüler oluşturma ve etkileşimli sistemleri daha sezgisel ve bağlamsal olarak farkında kılarak geliştirme gibi uygulamalara güç verir.

Peki, çok modlu modeller bu farklı veri türlerini bu sonuçları elde etmek için nasıl birleştiriyor? Başarılarının ardındaki temel mekanizmaları adım adım inceleyelim.

Çok modlu yapay zeka modelleri, güçlü yeteneklerini özel süreçler aracılığıyla elde eder: her bir modalite için ayrı özellik çıkarımı (görüntüler, metin veya ses gibi her bir veri türünü kendi başına işleme), füzyon yöntemleri (çıkarılan detayları birleştirme) ve gelişmiş hizalama teknikleri (birleştirilen bilgilerin tutarlı bir şekilde bir araya gelmesini sağlama).

Bu süreçlerin her birinin nasıl çalıştığını daha ayrıntılı olarak inceleyelim.

Çok modlu yapay zeka modelleri, her veri türü için farklı, özel mimariler kullanır. Bu, görsel, metinsel ve ses veya sensör girdilerinin, özellikle onlar için tasarlanmış sistemler tarafından işlendiği anlamına gelir. Bunu yapmak, modelin bir araya getirmeden önce her bir girdinin benzersiz ayrıntılarını yakalamasını mümkün kılar.

İşte farklı uzmanlaşmış mimarilerin çeşitli veri türlerinden özellikleri çıkarmak için nasıl kullanıldığına dair bazı örnekler:

Her bir yöntem ayrı ayrı işlendikten sonra, her bir veri tipinde bulunan benzersiz bilgileri yakalamak için optimize edilmiş üst düzey özellikler oluşturur.

Öznitelikleri çıkardıktan sonra, çok modlu modeller bunları birleşik, tutarlı bir gösterimde birleştirir. Bunu etkili bir şekilde yapmak için çeşitli füzyon stratejileri kullanılır:

Son olarak, çok modlu sistemler, farklı modalitelerden gelen verilerin etkili bir şekilde eşleşmesini sağlamak için gelişmiş hizalama ve dikkat tekniklerini kullanır.

Kontrastif öğrenme gibi yöntemler, görsel ve metinsel temsillerin ortak bir semantik alanda yakından hizalanmasına yardımcı olur. Bu sayede, çok modlu modeller, modelin "gördüğü" ve "okuduğu" şeyler arasında tutarlılık sağlayarak, çeşitli veri türleri arasında güçlü ve anlamlı bağlantılar kurabilir.

Transformer tabanlı dikkat mekanizmaları, modellerin her girdinin en alakalı yönlerine dinamik olarak odaklanmasını sağlayarak bu hizalamayı daha da geliştirir. Örneğin, dikkat katmanları modelin belirli metinsel açıklamaları görsel verilerdeki karşılık gelen bölgeleriyle doğrudan ilişkilendirmesine olanak tanır ve görsel soru yanıtlama (VQA) ve görüntü başlığı oluşturma gibi karmaşık görevlerde doğruluğu büyük ölçüde artırır.

Bu teknikler, çok modlu yapay zekanın bağlamı derinlemesine anlama yeteneğini geliştirerek, yapay zekanın karmaşık, gerçek dünya verilerinin daha nüanslı ve doğru yorumlarını sağlamasını mümkün kılar.

Çok modlu yapay zeka, erken dönem kural tabanlı tekniklerden, karmaşık entegrasyon yeteneğine sahip gelişmiş derin öğrenme sistemlerine doğru önemli ölçüde evrimleşmiştir.

İlk zamanlarda çok modlu sistemler, insan uzmanlar tarafından manuel olarak oluşturulan kurallar veya basit istatistiksel yöntemler kullanarak görüntü, ses veya sensör girdileri gibi farklı veri türlerini birleştirmiştir. Örneğin, ilk robotik navigasyon, engelleri detect etmek ve bunlardan kaçınmak için kamera görüntülerini sonar verileriyle birleştiriyordu. Etkili olmakla birlikte, bu sistemler kapsamlı manuel özellik mühendisliği gerektiriyordu ve uyum sağlama ve genelleme yetenekleri sınırlıydı.

Derin öğrenmenin ortaya çıkışıyla birlikte, çok modlu modeller çok daha popüler hale geldi. Çok modlu otomatik kodlayıcılar gibi sinir ağları, farklı veri türlerinin, özellikle de görüntü ve metin verilerinin ortak temsillerini öğrenmeye başladı ve yapay zekanın çapraz modlu alma ve yalnızca metinsel açıklamalara dayalı olarak görüntü bulma gibi görevleri yerine getirmesini sağladı.

Görsel Soru Cevaplama (VQA) gibi sistemlerin görüntüleri işlemek için CNN'leri ve metni yorumlamak için RNN'leri veya dönüştürücüleri entegre etmesiyle ilerlemeler devam etti. Bu, yapay zeka modellerinin görsel içerikle ilgili karmaşık, bağlama bağlı soruları doğru bir şekilde yanıtlamasına olanak tanıdı.

Son zamanlarda, büyük internet ölçekli veri kümeleri üzerinde eğitilmiş büyük ölçekli çok modlu modeller, yapay zeka yeteneklerinde daha da devrim yarattı.

Bu modeller, görsel içerik ve metinsel açıklamalar arasındaki genellenebilir ilişkileri tanımlamalarını sağlayan kontrastif öğrenme gibi tekniklerden yararlanır. Modaliteler arasındaki boşlukları kapatarak, modern çok modlu mimariler, yapay zekanın karmaşık görsel akıl yürütme görevlerini neredeyse insan hassasiyetiyle gerçekleştirme yeteneğini geliştirmiştir ve bu da çok modlu yapay zekanın temel aşamalarından ne kadar ilerlediğini göstermektedir.

Artık çok modlu modellerin farklı veri akışlarını nasıl entegre ettiğini incelediğimize göre, bu yeteneklerin bilgisayarlı görü modellerine nasıl uygulanabileceğine dalalım.

Çok modlu öğrenme, görsel girdiyi metin, ses veya sensör verileriyle birleştirerek, yapay zeka sistemlerinin giderek daha karmaşık, bağlam açısından zengin uygulamaların üstesinden gelmesini sağlar.

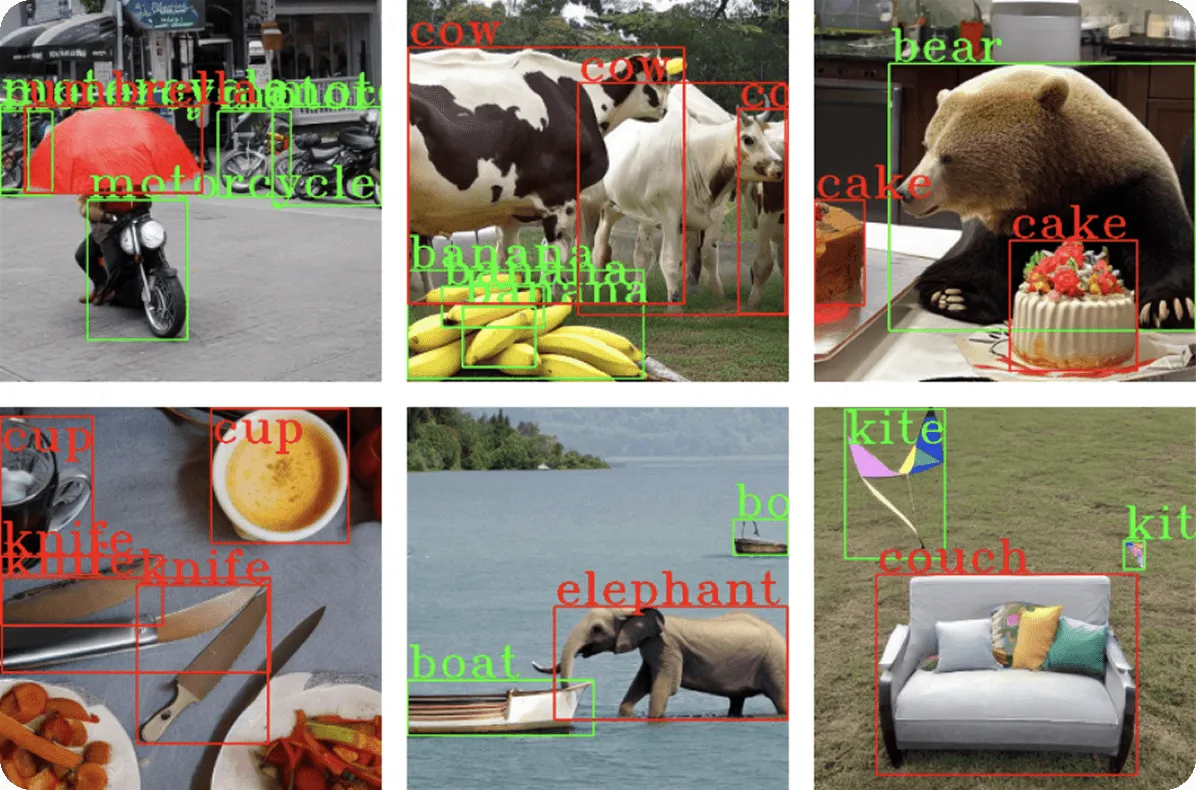

Görsel verileri açıklama, görsel veriler için doğal dil açıklamaları oluşturmayı içerir. Geleneksel nesne algılama yöntemleri tek tek nesneleri tanımlar, ancak çok modlu açıklama daha da ileri giderek ilişkileri ve bağlamları yorumlar.

Örneğin, çok modlu bir model, piknik yapan insanların bir görüntüsünü analiz edebilir ve daha zengin ve daha erişilebilir bir çıktı sağlayarak "Güneşli bir parkta piknik yapan bir aile" gibi açıklayıcı bir başlık oluşturabilir.

Bu uygulama, erişilebilirlik açısından önemlidir. Görme engelli bireyler için alt metin oluşturmak ve büyük veritabanları için içerik etiketlemek için kullanılabilir. Transformer mimarileri burada önemli bir rol oynar ve metin oluşturma modülünün dikkat mekanizmaları aracılığıyla ilgili görsel alanlara odaklanmasını, metinsel açıklamaları görsel özelliklerle dinamik olarak hizalamasını sağlar.

VQA modelleri, bilgisayar görüşünü dil anlama ile birleştirerek görsel içeriğe dayalı doğal dil sorularını yanıtlar. Bu görevler, görüntü içeriğinin, bağlamın ve semantik akıl yürütmenin ayrıntılı bir şekilde anlaşılmasını gerektirir.

Transformer mimarileri, modelin metin ve görsel bileşenlerinin dinamik olarak etkileşime girmesini sağlayarak, soruyla ilgili kesin görüntü bölgelerini belirleyerek VQA'yı geliştirmiştir.

Örneğin Google'ın PaLI modeli, görsel dönüştürücüleri (ViT) dil kodlayıcıları ve kod çözücüleriyle entegre eden gelişmiş dönüştürücü tabanlı mimariler kullanarak "Resimdeki kadın ne yapıyor?" veya "Kaç tane hayvan görünüyor?" gibi karmaşık soruların doğru bir şekilde yanıtlanmasını sağlıyor.

Modellerin bir girdinin en alakalı kısımlarına odaklanmasına yardımcı olan dikkat katmanları, her soru kelimesinin dinamik olarak görsel ipuçlarıyla bağlantı kurmasını sağlayarak temel nesne algılamanın ötesinde nüanslı yanıtlar sağlar.

Metinden görüntü oluşturma, yapay zekanın doğrudan metinsel açıklamalardan görsel içerik oluşturma yeteneğini ifade eder ve anlamsal anlayış ile görsel oluşturma arasındaki boşluğu kapatır.

Bu görevi yerine getiren çok modlu modeller, ayrıntılı ve bağlamsal olarak doğru görüntüler oluşturmak için transformatörler veya difüzyon süreçleri gibi gelişmiş sinir ağı mimarilerini kullanır.

Örneğin, araç tespiti ile görevli bilgisayarlı görü modelleri için sentetik eğitim verileri oluşturduğunuzu hayal edin. "Yoğun bir caddede park etmiş kırmızı bir sedan" veya "Otoyolda giden beyaz bir SUV" gibi metinsel açıklamalar verildiğinde, bu çok modlu modeller, bu kesin senaryoları tasvir eden çeşitli, yüksek kaliteli görüntüler üretebilir.

Bu tür bir yetenek, araştırmacıların ve geliştiricilerin binlerce görüntüyü manuel olarak yakalamadan nesne algılama veri kümelerini verimli bir şekilde genişletmelerini sağlayarak, veri toplama için gereken zamanı ve kaynakları önemli ölçüde azaltır.

Daha yeni yöntemler, rastgele görsel gürültüden başlayıp görüntüyü metinsel girdiye yakından uyacak şekilde aşamalı olarak iyileştiren difüzyon tabanlı teknikler uygular. Bu yinelemeli süreç, çoklu bakış açılarını, aydınlatma koşullarını, araç türlerini ve arka planları kapsayan sağlam eğitim verileri sağlayarak gerçekçi ve çeşitli örnekler oluşturabilir.

Bu yaklaşım, özellikle bilgisayarla görme alanında değerlidir; hızlı veri kümesi genişletme, model doğruluğunu artırma ve yapay zeka sistemlerinin güvenilir bir şekilde tanıyabileceği senaryoların çeşitliliğini geliştirme olanağı sağlar.

Çok modlu erişim sistemleri, hem metni hem de görüntüleri ortak bir anlam diline dönüştürerek aramayı kolaylaştırır. Örneğin, milyonlarca görüntü-metin çiftinden öğrenen CLIP gibi büyük veri kümelerinde eğitilmiş modeller, metin sorgularını doğru görüntülerle eşleştirerek daha sezgisel ve doğru arama sonuçları elde edilmesini sağlar.

Örneğin, "sahilde gün batımı" gibi bir arama sorgusu, görsel olarak hassas sonuçlar döndürerek e-ticaret platformları, medya arşivleri ve stok fotoğraf veritabanlarında içerik keşif verimliliğini önemli ölçüde artırır.

Çok modlu yaklaşım, sorgular ve görüntü açıklamaları farklı diller kullandığında bile, görsel ve metinsel alanlar arasındaki öğrenilmiş semantik hizalamalar sayesinde, geri alma doğruluğunu garanti eder.

Çok modlu öğrenme, yapay zekanın bilgisayarlı görü ve ötesindeki yeteneklerini geliştiren çeşitli temel avantajlar sunar:

Bu güçlü yönlerine rağmen, çok modlu modellerin de kendine özgü zorlukları vardır:

Çok modlu öğrenme, birden fazla veri akışı arasında daha zengin, daha bağlamsal bir anlayış sağlayarak yapay zekayı yeniden şekillendiriyor. Görüntü açıklaması, görsel soru cevaplama, metinden görüntüye oluşturma ve gelişmiş görüntü alma gibi bilgisayarlı görü uygulamaları, çeşitli modaliteleri entegre etme potansiyelini göstermektedir.

Hesaplama ve etik zorluklar devam etse de, transformatör tabanlı füzyon ve kontrastif hizalama gibi mimarilerdeki devam eden yenilikler, bu endişeleri gidermeye devam ediyor ve çok modlu yapay zekayı giderek insan benzeri bir zekaya doğru itiyor.

Bu alan geliştikçe, çok modlu modeller, sağlık hizmetleri teşhisinden otonom robotiklere kadar her şeyi geliştirerek karmaşık, gerçek dünya yapay zeka görevleri için vazgeçilmez hale gelecektir. Çok modlu öğrenmeyi benimsemek, endüstrileri yapay zekanın geleceğini şekillendirecek güçlü yeteneklerden yararlanmaya konumlandırıyor.

Büyüyen topluluğumuza katılın! Yapay zeka hakkında daha fazla bilgi edinmek için GitHub depomuzu keşfedin. Kendi bilgisayarlı görü projelerinize başlamaya hazır mısınız? Lisanslama seçeneklerimize göz atın. Çözüm sayfalarımızı ziyaret ederek üretimde yapay zeka ve otonom sürüşte yapay görmeyi keşfedin!