Déploiement d'applications de vision par ordinateur sur des appareils Edge AI

Découvrez comment Edge AI et les innovations de NVIDIA, telles que Jetson, Triton et TensorRT, simplifient le déploiement des applications de vision par ordinateur.

Découvrez comment Edge AI et les innovations de NVIDIA, telles que Jetson, Triton et TensorRT, simplifient le déploiement des applications de vision par ordinateur.

Grâce aux récentes avancées en vision par ordinateur et en intelligence artificielle (IA), ce qui n'était autrefois qu'un domaine de recherche est aujourd'hui à l'origine d'applications percutantes dans divers secteurs. Des voitures autonomes à l'imagerie médicale et à la sécurité, les systèmes de vision par ordinateur résolvent des problèmes concrets à grande échelle.

Bon nombre de ces applications impliquent l'analyse d'images et de vidéos en temps réel, et le recours à l'informatique en nuage n'est pas toujours pratique en raison de la latence, des coûts et des problèmes de confidentialité. L'Edge AI est une excellente solution dans ces situations. En exécutant des modèles Vision AI directement sur des appareils périphériques, les entreprises peuvent traiter les données plus rapidement, à moindre coût et avec une plus grande sécurité, ce qui rend l'IA en temps réel plus accessible.

Au cours de YOLO Vision 2024 (YV24), l'événement hybride annuel organisé par Ultralytics, l'un des thèmes centraux était la démocratisation de Vision AI en rendant le déploiement plus convivial et plus efficace. Guy Dahan, Senior Solutions Architect chez NVIDIA, a expliqué comment les solutions matérielles et logicielles de NVIDIA, notamment les appareils de edge computing, les serveurs d'inférence, les frameworks d'optimisation et les SDK de déploiement de l'IA, aident les développeurs à optimiser l'IA à la périphérie.

Dans cet article, nous allons explorer les points clés de la présentation de Guy Dahan au YV24 et comment les dernières innovations de NVIDIArendent le déploiement de Vision AI plus rapide et plus évolutif.

Guy Dahan a commencé son intervention en exprimant son enthousiasme à l'idée de rejoindre virtuellement YV24 et son intérêt pour le package Ultralytics Python et lesmodèles Ultralytics YOLO , en déclarant : "J'utilise Ultralytics depuis le jour de sa sortie. J'aime beaucoup Ultralytics - j'utilisais déjà YOLOv5 avant cela, et je suis un vrai passionné de ce progiciel".

Ensuite, il a introduit le concept d'Edge AI, expliquant qu'il s'agit d'exécuter des calculs d'IA directement sur des appareils tels que des caméras, des drones ou des machines industrielles, plutôt que d'envoyer des données à des serveurs cloud distants pour le traitement.

Au lieu d'attendre que les images ou les vidéos soient téléchargées, analysées, puis renvoyées avec les résultats, l'Edge AI permet d'analyser les données instantanément sur l'appareil lui-même. Cela rend les systèmes de Vision AI plus rapides, plus efficaces et moins dépendants de la connectivité Internet. L'Edge AI est particulièrement utile pour les applications de prise de décision en temps réel, telles que les voitures autonomes, les caméras de sécurité et les usines intelligentes.

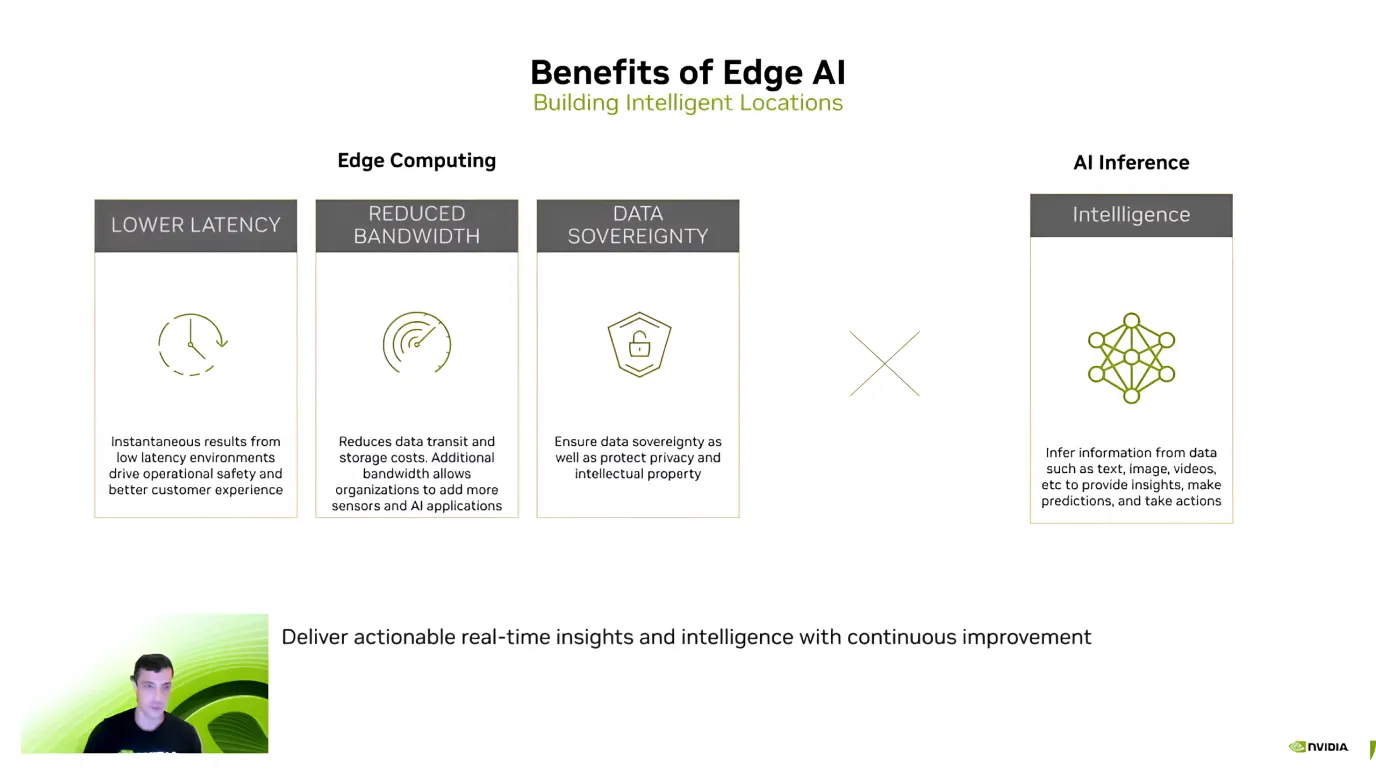

Après avoir présenté l'Edge AI, Guy Dahan a souligné ses principaux avantages, en se concentrant sur l'efficacité, les économies de coûts et la sécurité des données. Il a expliqué que l'un des plus grands avantages est la faible latence : étant donné que les modèles d'IA traitent les données directement sur l'appareil, il n'est pas nécessaire d'envoyer des informations au cloud et d'attendre une réponse.

L'IA en périphérie contribue également à réduire les coûts et à protéger les données sensibles. L'envoi de grandes quantités de données vers le cloud, en particulier les flux vidéo, peut être coûteux. Cependant, le traitement local réduit les coûts de bande passante et de stockage.

Un autre avantage clé est la confidentialité des données, car les informations restent sur l'appareil au lieu d'être transférées vers un serveur externe. Ceci est particulièrement important pour les applications de santé, de finance et de sécurité, où la conservation des données en local et en toute sécurité est une priorité absolue.

S'appuyant sur ces avantages, Guy Dahan a commenté l'adoption croissante de l'Edge AI. Il a fait remarquer que depuis que NVIDIA a introduit Jetson en 2014, l'utilisation a été multipliée par dix. Aujourd'hui, plus de 1,2 million de développeurs travaillent avec des appareils Jetson.

Guy Dahan s'est ensuite concentré sur les appareilsNVIDIA Jetson, une famille d'appareils informatiques de pointe pour l'IA conçus pour fournir de hautes performances avec une faible consommation d'énergie. Les appareils Jetson sont idéaux pour les applications de vision par ordinateur dans des secteurs tels que la robotique, l'agriculture, la santé et l'automatisation industrielle. "Les Jetson sont des dispositifs Edge AI spécialement conçus pour l'IA. Je pourrais même ajouter qu'à l'origine, ils ont été conçus principalement pour la vision par ordinateur", a ajouté Guy Dahan.

Les appareils Jetson sont disponibles en trois niveaux, chacun étant adapté à des besoins différents :

Guy Dahan a également parlé de la prochaine Jetson AGX Thor, qui sera lancée cette année, et a indiqué qu'elle offrira huit fois plus de performances au niveau du GPU (Graphics Processing Unit), deux fois plus de capacité de mémoire et de meilleures performances au niveau du CPU (Central Processing Unit). Il est spécialement conçu pour la robotique humanoïde et les applications avancées d'intelligence artificielle.

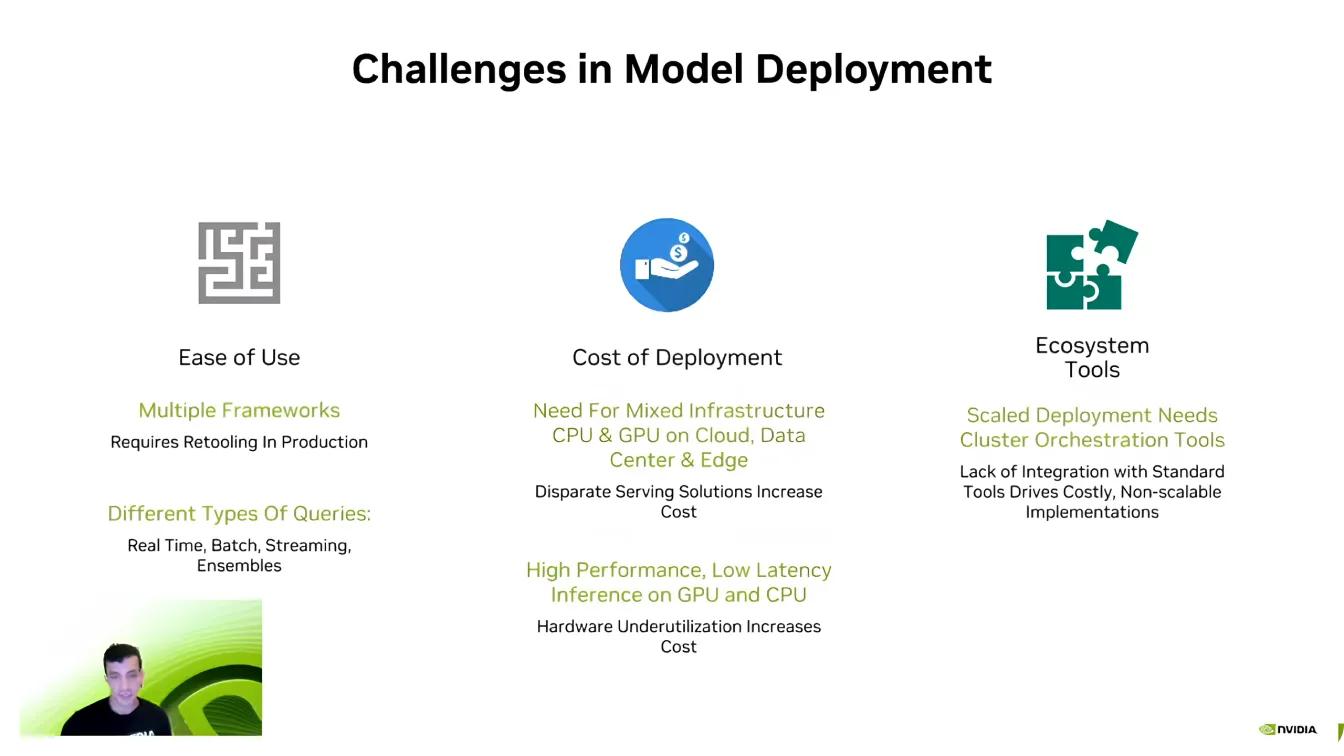

Guy Dahan a ensuite abordé le côté logiciel de l'Edge AI et a expliqué que même avec un matériel puissant, le déploiement efficace des modèles peut être difficile.

L'un des principaux obstacles est la compatibilité, car les développeurs d'IA travaillent souvent avec différents frameworks d'IA tels que PyTorch et TensorFlow. Le passage d'un framework à l'autre peut s'avérer difficile, obligeant les développeurs à recréer des environnements pour s'assurer que tout fonctionne correctement.

La scalabilité est un autre défi majeur. Les modèles d'IA nécessitent une puissance de calcul importante, et comme l'a dit Dahan, "Il n'y a jamais eu d'entreprise d'IA qui souhaite moins de calcul." L'élargissement des applications d'IA sur plusieurs appareils peut rapidement devenir coûteux, ce qui rend l'optimisation essentielle.

De plus, les pipelines d'IA sont complexes, impliquant souvent différents types de données, un traitement en temps réel et une intégration de systèmes. Les développeurs consacrent beaucoup d'efforts à s'assurer que leurs modèles interagissent de manière transparente avec les écosystèmes logiciels existants. Surmonter ces défis est un élément crucial pour rendre les déploiements d'IA plus efficaces et évolutifs.

Guy Dahan s'est ensuite intéressé au serveur d'inférenceTriton de NVIDIA. Il a souligné que de nombreuses entreprises et startups commencent le développement de l'IA sans optimiser complètement leurs modèles. La refonte complète d'un pipeline d'IA à partir de zéro peut s'avérer perturbante et chronophage, ce qui rend difficile une mise à l'échelle efficace.

Au lieu de nécessiter une refonte complète du système, Triton permet aux développeurs d'affiner et d'optimiser progressivement leurs flux de travail d'IA, en intégrant des composants plus efficaces sans interrompre leur configuration existante. Grâce à la prise en charge de plusieurs frameworks d'IA, notamment TensorFlow, PyTorch, ONNX et TensorRT, Triton permet un déploiement transparent dans les environnements cloud, les centres de données et les périphériques avec un minimum d'ajustements.

Voici quelques-uns des principaux avantages du serveur d'inférence Triton de NVIDIA:

Supposons que vous recherchiez encore plus d'accélération ; NVIDIA TensorRT est une option intéressante pour optimiser vos modèles d'IA. Guy Dahan explique que TensorRT est un optimiseur d'apprentissage profond hautes performances conçu pour les GPU NVIDIA . Les modèles de TensorFlow, PyTorch, ONNX et MXNet peuvent être convertis en fichiers GPU à l'aide de TensorRT.

Ce qui rend TensorRT si fiable, ce sont ses optimisations spécifiques au matériel. Un modèle optimisé pour les appareils Jetson ne sera pas aussi efficace sur d'autres GPU, car TensorRT ajuste les performances en fonction du matériel cible. Un modèle de vision par ordinateur optimisé peut augmenter la vitesse d'inférence jusqu'à 36 fois par rapport à des modèles non optimisés.

Guy Dahan a également attiré l'attention sur la prise en charge de TensorRT par Ultralytics, expliquant comment elle rend le déploiement de modèles d'IA plus rapide et plus efficace. Les modèlesYOLO Ultralytics peuvent être directement exportés au format TensorRT , ce qui permet aux développeurs de les optimiser pour les GPU NVIDIA sans avoir à les modifier.

Pour conclure la conférence sur une note positive, Guy Dahan a présenté DeepStream 7.0, un framework d'IA conçu pour le traitement en temps réel des données vidéo, audio et des capteurs à l'aide des GPU NVIDIA . Conçu pour prendre en charge les applications de vision par ordinateur à haut débit, il permet la détection, le suivi et l'analyse d'objets dans les systèmes autonomes, la sécurité, l'automatisation industrielle et les villes intelligentes. En exécutant l'IA directement sur les appareils périphériques, DeepStream élimine la dépendance au cloud, réduisant ainsi la latence et améliorant l'efficacité.

Plus précisément, DeepStream peut gérer le traitement vidéo basé sur l'IA de bout en bout. Il prend en charge les flux de travail complets, du décodage et du prétraitement vidéo à l'inférence IA et au post-traitement.

Récemment, DeepStream a introduit plusieurs mises à jour pour améliorer le déploiement de l'IA, le rendant plus accessible et évolutif. De nouveaux outils simplifient le développement, améliorent le suivi multi-caméras et optimisent les pipelines d'IA pour de meilleures performances.

Les développeurs bénéficient désormais d'un support étendu pour les environnements Windows, de capacités de fusion de capteurs améliorées pour l'intégration de données provenant de sources multiples et d'un accès à des applications de référence pré-construites pour accélérer le déploiement. Ces améliorations font de DeepStream une solution plus flexible et efficace pour les applications d'IA en temps réel, aidant les développeurs à faire évoluer l'analyse vidéo intelligente avec facilité.

Comme l'a illustré Guy Dahan lors de sa présentation à YV24, l'Edge AI redéfinit les applications de vision par ordinateur. Grâce aux avancées matérielles et logicielles, le traitement en temps réel devient plus rapide, plus efficace et plus rentable.

À mesure que de plus en plus d'industries adoptent l'Edge AI, relever les défis tels que la fragmentation et la complexité du déploiement sera essentiel pour libérer son plein potentiel. L'adoption de ces innovations permettra de créer des applications d'IA plus intelligentes et plus réactives, façonnant ainsi l'avenir de la vision par ordinateur.

Rejoignez notre communauté en pleine croissance ! Explorez notre dépôt GitHub pour en savoir plus sur l'IA, et consultez nos options de licence pour lancer vos projets de Vision IA. Curieux de connaître les innovations telles que l'IA dans le domaine de la santé et la vision par ordinateur dans la fabrication ? Visitez nos pages de solutions pour en savoir plus !