OpenAIの新しいGPT-4oを探索しましょう。高度なAIを搭載し、まるで生きているかのようなインタラクションで、テクノロジーとのコミュニケーション方法を変革します。その画期的な機能を探索してください!

OpenAIの新しいGPT-4oを探索しましょう。高度なAIを搭載し、まるで生きているかのようなインタラクションで、テクノロジーとのコミュニケーション方法を変革します。その画期的な機能を探索してください!

2024年5月13日月曜日、OpenAIは新しいフラッグシップモデルであるGPT-4oの発売を発表しました。'o'は'omni'を表します。GPT-4oは、リアルタイムのテキスト、オーディオ、およびビジョンのインタラクションのための高度なマルチモーダルAIモデルであり、より高速な処理、多言語サポート、および強化された安全性を提供します。

GPT-4oは、これまでにないジェネレーティブなAI機能を提供します。GPT-4oは、ChatGPT会話能力をベースに、AIに対する人々の認識を大きく前進させます。私たちは今、GPT-4oとまるで本物の人間のように話すことができる。では、GPT-4oの能力を実際に見てみよう!

OpenAIの春のアップデートで、GPT-4oはGPT-4と同等の知能を持ちながら、データ処理が高速で、テキスト、ビジョン、オーディオの処理能力が向上していることが明らかになりました。モデルをよりスマートにすることに重点を置いていた以前のリリースとは異なり、今回のリリースでは、一般ユーザーがAIをより使いやすくする必要性を念頭に置いて作成されました。

.png)

昨年末にリリースされたChatGPT音声モードでは、3つの異なるモデルが一緒になって、音声入力を書き起こし、文字入力を理解して返事を生成し、ユーザーが返事を聞けるようにテキストを音声に変換していた。このモードは待ち時間の問題があり、あまり自然には感じられなかった。GPT-4oは、テキスト、視覚、音声を一度にネイティブ処理することができ、ユーザーに自然な会話に参加しているような印象を与えることができる。

また、音声モードとは異なり、GPT-4oが話している途中で中断できるようになり、まるで人のように反応します。一時停止して耳を傾け、あなたの発言に基づいてリアルタイムで応答します。また、声を通して感情を表現したり、あなたの口調を理解したりすることもできます。

GPT-4oのモデル評価は、その高度さを示しています。最も興味深い結果の1つは、GPT-4oがすべての言語、特にあまり使用されていない言語において、Whisper-v3と比較して音声認識を大幅に改善したことです。

オーディオASR(自動音声認識)のパフォーマンスは、モデルが話し言葉をテキストにどれだけ正確に書き起こすかを測定します。GPT-4oのパフォーマンスは、単語誤り率(WER)によって追跡されます。これは、誤って書き起こされた単語の割合を示します(WERが低いほど品質が向上します)。下のグラフは、GPT-4oがさまざまな地域でWERが低いことを示しており、リソースの少ない言語の音声認識を改善する上での有効性を示しています。

.png)

GPT-4oのよりユニークな機能をいくつかご紹介します。

携帯電話でGPT-4oを取り出し、カメラをオンにして、友達にするようにGPT-4oに顔の表情に基づいて気分を推測するように依頼できます。GPT-4oはカメラを通してあなたを見て答えることができます。

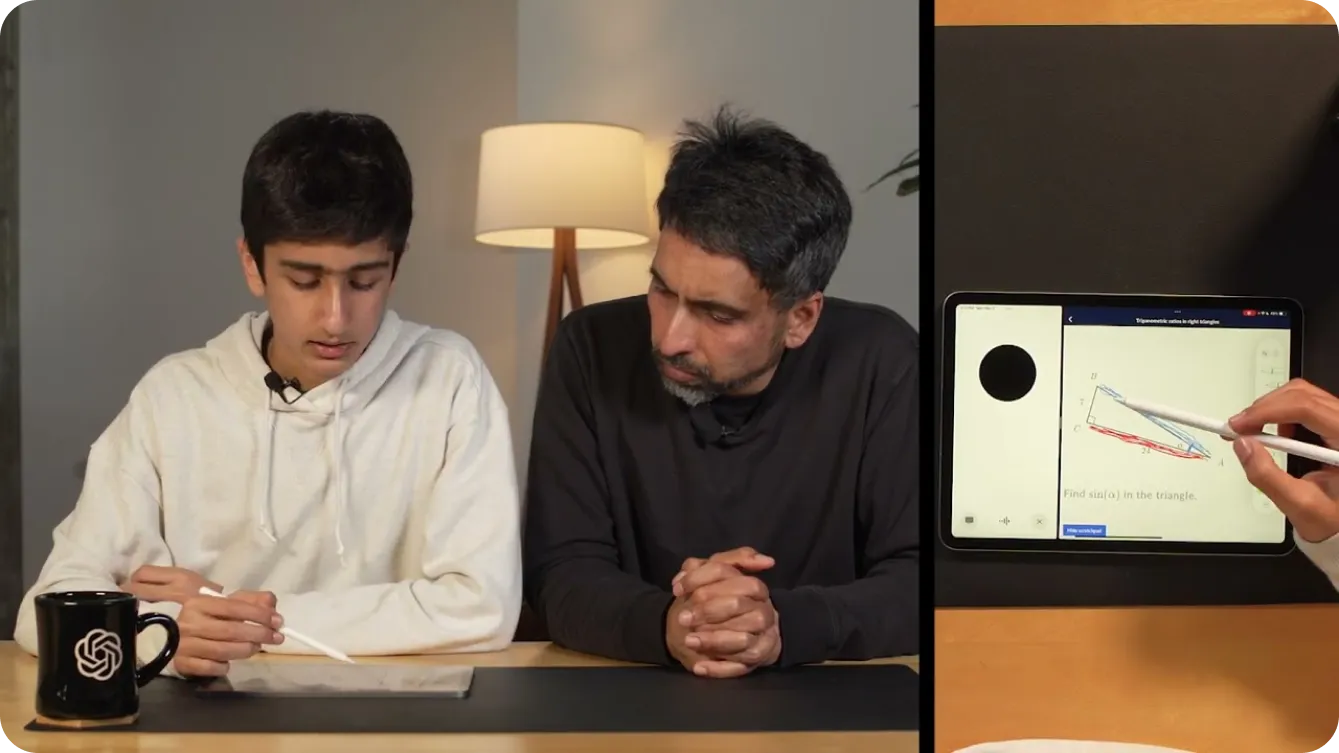

ビデオを通してGPT-4oに書いているものを見せることで、数学の問題を解くのに役立てることさえできます。または、画面を共有して、カーンアカデミーで役立つ家庭教師になってもらい、下の図に示すように、幾何学で三角形のさまざまな部分を指摘してもらうこともできます。

子供たちの算数を手助けするだけでなく、開発者はGPT-4oと会話してコードをデバッグすることができます。これはChatGPT デスクトップアプリとして導入されたおかげで可能になった。デスクトップのGPT-4o音声アプリと会話しながら、CTRL "C "でコードをハイライトしてコピーすれば、コードを読み取ることができる。また、異なる言語を話す開発者同士の会話を翻訳するために使用することもできます。

GPt-4oの可能性は無限にあるようです。OpenAIの最も興味深いデモの1つは、2台の電話を使用して、GPt-4oがそれ自身の異なるインスタンスと会話したり、一緒に歌ったりする様子を示しました。

デモで示されているように、GPT-4oは視覚障害のある人々にとって世界をよりアクセスしやすくすることができます。彼らがより安全かつ独立して対話し、動き回るのを助けることができます。たとえば、ユーザーはビデオをオンにして、GPT-4oに通りの様子を見せることができます。GPT-4oは、障害物の特定、道路標識の読み取り、特定の場所への誘導など、環境のリアルタイムの説明を提供できます。タクシーが近づいているときに警告することで、タクシーを呼ぶことさえできます。

.png)

同様に、GPT-4oは、その高度な機能により、さまざまな業界を変革することができます。小売では、リアルタイムの支援、質問への回答、オンラインおよび店舗での製品検索の支援を提供することで、顧客サービスを向上させることができます。たとえば、棚に並んだ製品を見ていて、探している製品を選ぶことができない場合、GPT-4oが役立ちます。

ヘルスケアにおいて、GPT-4oは患者データを分析し、症状に基づいて考えられる病状を示唆し、治療の選択肢に関するガイダンスを提供することで、診断を支援できます。また、患者記録の要約、医学文献への迅速なアクセス、異なる言語を話す患者とのコミュニケーションのためのリアルタイムな言語翻訳を提供することで、医療従事者をサポートできます。これらはほんの一例にすぎません。GPT-4oのアプリケーションは、調整されたコンテキスト認識型の支援を提供し、情報とコミュニケーションの障壁を取り除くことで、日常生活をより容易にします。

何億もの人々の生活に影響を与えたGPTの以前のバージョンと同様に、GPT-4oはリアルタイムのオーディオおよびビデオとグローバルに対話する可能性が高く、安全性がこれらのアプリケーションにおいて重要な要素となります。OpenAIは、潜在的なリスクを軽減することに重点を置いてGPT-4oを構築することに非常に注意を払ってきました。

安全性と信頼性を確保するために、OpenAIは厳格な安全対策を実施しています。これには、トレーニングデータのフィルタリング、トレーニング後のモデルの動作の改良、音声出力を管理するための新しい安全システムの組み込みが含まれます。さらに、GPT-4oは、社会心理学、偏見と公平性、誤情報などの分野で70人以上の外部専門家によって広範囲にテストされています。外部テストにより、新機能によって導入または増幅されるリスクが特定され、対処されることが保証されます。

高い安全基準を維持するために、OpenAI は今後数週間かけて GPT-4o の機能を段階的にリリースします。段階的なロールアウトにより、OpenAI はパフォーマンスを監視し、問題に対処し、ユーザーからのフィードバックを収集できます。慎重なアプローチをとることで、GPT-4o は高度な機能を提供しながら、最高水準の安全性と倫理的な使用を維持できます。

GPT-4oは無料でご利用いただけます。上記のリアルタイム会話能力を試すには、Google Play StoreまたはApple App StoreからChatGPT アプリを直接携帯電話にダウンロードできます。

ログイン後、画面の右上隅にある3つの点をタップして表示されるリストからGPT-4oを選択できます。GPT-4oが有効になっているチャットに移動した後、画面の左下隅にあるプラス記号をタップすると、複数の入力オプションが表示されます。画面の右下隅には、ヘッドホンアイコンが表示されます。ヘッドホンアイコンを選択すると、GPT-4oのハンズフリーバージョンを体験するかどうかを尋ねられます。同意すると、以下に示すようにGPT-4oを試すことができます。

GPT-4oの高度な機能を自分のプロジェクトに統合したい場合は、開発者向けのAPIとして利用できます。これにより、GPT-4oの強力な音声認識、多言語サポート、リアルタイムの会話機能をアプリケーションに組み込むことができます。APIを使用することで、ユーザーエクスペリエンスを向上させ、よりスマートなアプリを構築し、最先端のAIテクノロジーをさまざまな分野に導入できます。

GPT-4oは以前のAIモデルよりもはるかに進化しているが、GPT-4oには独自の限界があることを忘れてはならない。OpenAIは、GPT-4oが会話中にランダムに言語を切り替え、English フランス語になることがあると述べている。また、GPT-4oが言語間の翻訳を誤ることもあるという。より多くの人がこのモデルを試すことで、GPT-4oが優れている点と、さらに改善が必要な点がわかってくるだろう。

OpenAIのGPT-4oは、高度なテキスト、ビジョン、音声処理により、AIに新たな可能性をもたらし、自然で人間らしいインタラクションを提供します。速度、コスト効率、多言語サポートに優れており、教育、アクセシビリティ、リアルタイム支援に活用できる多用途なツールです。ユーザーがGPT-4oの機能を検証することで、フィードバックがその進化を促進します。GPT-4oは、AIが真に世界を変え、私たちの日常生活の一部になりつつあることを証明しています。

AIについてさらに深く知りたい場合は、GitHubリポジトリをご覧いただき、コミュニティにご参加ください。ソリューションページでは、製造業や農業など、AIが業界をどのように変革しているかをご紹介しています。