AIに倫理的に取り組むことがなぜ重要なのか、AI規制が世界中でどのように扱われているのか、そして倫理的なAIの利用を促進するためにあなたがどのような役割を果たせるのかを学びましょう。

AIに倫理的に取り組むことがなぜ重要なのか、AI規制が世界中でどのように扱われているのか、そして倫理的なAIの利用を促進するためにあなたがどのような役割を果たせるのかを学びましょう。

AI技術がますます普及するにつれ、人工知能(AI)の倫理的な使用に関する議論が非常に一般的になってきました。私たちの多くがChatGPT ようなAIを搭載したツールを日常的に使用しているため、安全で道徳的に正しい方法でAIを導入しているかどうかを懸念する十分な理由がある。データはすべてのAIシステムの根源であり、多くのAIアプリケーションは、あなたの顔の画像、金融取引、健康記録、あなたの仕事に関する詳細、またはあなたの場所などの個人データを使用しています。このデータはどこに行き、どのように扱われるのか?これらは、倫理的なAIが答え、AIのユーザーに認識してもらおうとする疑問の一部である。

AIに関連する倫理的な問題について議論するとき、ターミネーターやロボットが乗っ取るようなシナリオを考えて結論に飛びつきがちです。しかし、倫理的なAIに実際的に取り組む方法を理解するための鍵は、シンプルで非常に簡単です。それはすべて、公正で透明性があり、説明責任のある方法でAIを構築、実装、使用することです。この記事では、AIが倫理的であるべき理由、倫理的なAIイノベーションを創出する方法、そしてAIの倫理的な利用を促進するために何ができるかを探ります。さあ、始めましょう!

倫理的なAIの詳細に入る前に、AIコミュニティでなぜこれほど重要な話題になっているのか、そしてAIが倫理的であるとは正確にはどういう意味なのかを詳しく見ていきましょう。

AIに関連する倫理は、新しい話題ではありません。1950年代から議論されてきました。当時、アラン・チューリングは機械知能の概念と、会話を通じて人間のような知能を示す機械の能力を測るチューリングテストを紹介し、AIに関する初期の倫理的な議論を開始しました。それ以来、研究者たちはAIと技術の倫理的な側面を考慮することの重要性についてコメントし、強調してきました。しかし、ごく最近になって、組織や政府が倫理的なAIを義務付けるための規制を作成し始めています。

これには主に3つの理由があります。

AIの高度化と世界的な注目度の高まりに伴い、倫理的なAIに関する議論は不可避となっています。

AIが倫理的であるとはどういうことかを真に理解するためには、倫理的なAIが直面する課題を分析する必要があります。これらの課題は、偏り、プライバシー、説明責任、セキュリティなど、多岐にわたります。倫理的なAIにおけるこれらの問題点のいくつかは、不公平な慣行を伴うAIソリューションの実装を通じて時間とともに発見されてきましたが、将来的に表面化する可能性のあるものもあります。

.webp)

AIにおける倫理上の主な課題を以下に示します。

これらの課題に対処することで、社会に利益をもたらすAIシステムを開発できます。

次に、上記の各課題に対処する倫理的なAIソリューションを実装する方法について説明します。偏りのないAIモデルの構築、ステークホルダーの教育、プライバシーの優先、データセキュリティの確保といった主要分野に焦点を当てることで、組織は効果的かつ倫理的なAIシステムを構築できます。

偏りのないAIモデルの構築は、トレーニングに多様で代表的なデータセットを使用することから始まります。定期的な監査と偏り検出方法により、偏りを特定して軽減できます。リサンプリングやリウェイトなどの手法を使用すると、トレーニングデータをより公平にすることができます。ドメインの専門家と協力し、多様なチームを開発に含めることも、さまざまな視点から偏りを認識して対処するのに役立ちます。これらの手順は、AIシステムが特定のグループを不当に優遇することを防ぐのに役立ちます。

.webp)

AIのブラックボックスについて知れば知るほど、その脅威は軽減されます。そのため、AIプロジェクトに関わるすべての人が、あらゆるアプリケーションの背後にあるAIの仕組みを理解することが不可欠です。開発者、ユーザー、意思決定者を含むステークホルダーは、さまざまなAIの概念を十分に理解することで、AIの倫理的な影響に適切に対処できます。偏り、透明性、説明責任、データプライバシーなどのトピックに関するトレーニングプログラムやワークショップは、この理解を深めることができます。AIシステムとその意思決定プロセスを説明する詳細なドキュメントは、信頼を構築するのに役立ちます。倫理的なAIの実践に関する定期的なコミュニケーションと最新情報は、組織文化に大きく貢献します。

プライバシーを優先するということは、個人データを保護するための堅牢なポリシーと慣行を開発することを意味します。AIシステムは、適切な同意を得て取得したデータを使用し、処理される個人情報の量を制限するためにデータ最小化手法を適用する必要があります。暗号化と匿名化により、機密データをさらに保護できます。

GDPR(一般データ保護規則)などのデータ保護規制を遵守することが不可欠です。GDPRは、欧州連合内の個人から個人情報を収集および処理するためのガイドラインを設定しています。データの収集、使用、および保存について透明性を保つことも重要です。定期的なプライバシー影響評価は、潜在的なリスクを特定し、プライバシーを優先事項として維持することをサポートできます。

プライバシーに加えて、データセキュリティは倫理的なAIシステムを構築するために不可欠です。強力なサイバーセキュリティ対策は、データ侵害や不正アクセスからデータを保護します。進化する脅威に対応するには、定期的なセキュリティ監査と更新が必要です。

AIシステムには、アクセス制御、安全なデータストレージ、リアルタイム監視などのセキュリティ機能を組み込む必要があります。明確なインシデント対応計画は、組織があらゆるセキュリティ問題を迅速に対処するのに役立ちます。データセキュリティへの取り組みを示すことで、組織はユーザーやステークホルダーの間で信頼と自信を築くことができます。

Ultralytics、倫理的なAIは私たちの仕事を導く基本原則です。創設者兼CEOのグレン・ジョーチャーはこう言います:「倫理的なAIは単なる可能性ではなく、必要不可欠なものです。規制を理解し遵守することで、私たちはAI技術が世界中で責任を持って開発され使用されることを保証することができます。重要なのは、イノベーションと誠実さのバランスをとることであり、AIがポジティブで有益な形で人類に貢献することを保証することです。率先垂範し、AIが善の力となりうることを示そう。"

この理念に基づき、私たちはAIソリューションにおいて、公平性、透明性、説明責任を優先しています。これらの倫理的配慮を開発プロセスに組み込むことで、イノベーションの限界を押し広げ、最高水準の責任を遵守する技術の創造を目指しています。倫理的なAIへのコミットメントは、私たちの活動が社会にポジティブな影響を与え、世界中で責任あるAIの実践のための基準を設定するのに役立ちます。

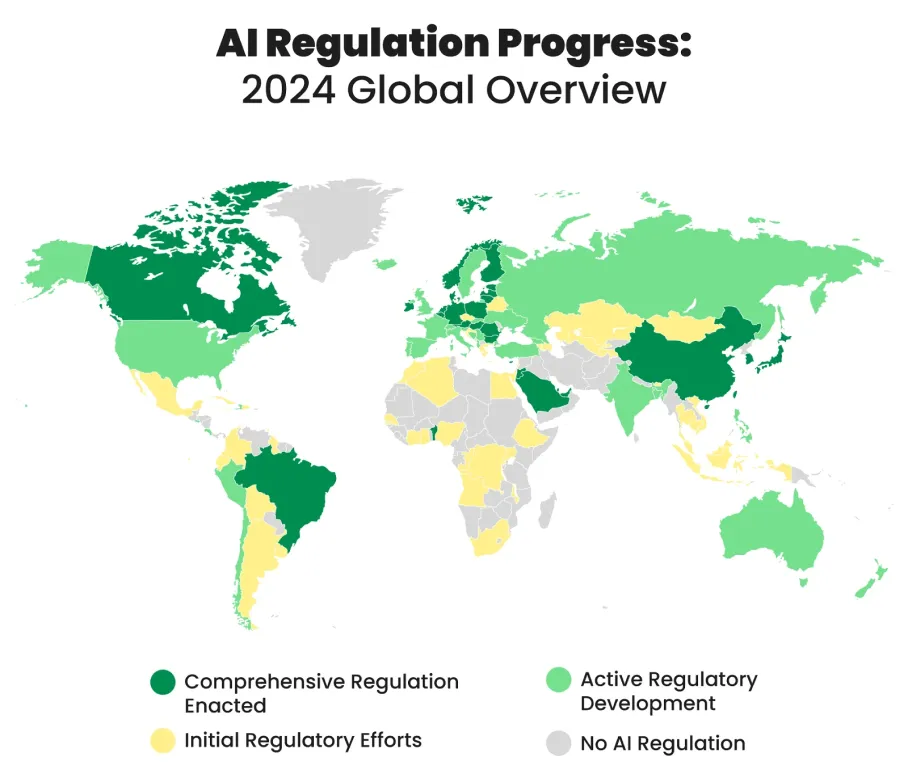

世界中の多くの国が、AI技術の倫理的かつ責任ある利用を導くためのAI規制を開発し、実施しています。これらの規制は、イノベーションと倫理的配慮のバランスを取り、AIイノベーションに関連する潜在的なリスクから個人と社会を保護することを目的としています。

AIの使用を規制するために世界中で講じられている措置の例を以下に示します。

倫理的なAIの推進は、思っているよりも簡単です。バイアス、透明性、プライバシーなどの問題について詳しく学ぶことで、倫理的なAIを取り巻く会話の中で積極的な発言者になることができます。倫理的なガイドラインをサポートし、それに従い、公平性を定期的にチェックし、データのプライバシーを保護する。ChatGPTようなAIツールを使用する際、その使用について透明性を保つことは、信頼を築き、AIをより倫理的なものにします。このようなステップを踏むことで、公正で透明性が高く、責任を持って開発・使用されるAIの普及に貢献することができます。

Ultralytics、倫理的なAIに取り組んでいます。当社のAIソリューションの詳細や、倫理的な考え方を維持する方法をご覧になりたい方は、当社のGitHubリポジトリをチェックし、当社のコミュニティに参加して、ヘルスケアや 製造業などの業界における最新のソリューションを探求してください!🚀