Tìm hiểu về Llama 3.1: Dòng mô hình mã nguồn mở mới nhất của Meta

Khám phá dòng mô hình mã nguồn mở Llama 3.1 mới của Meta, bao gồm 8B linh hoạt, 70B toàn diện và 405B hàng đầu, mô hình lớn nhất và tiên tiến nhất của họ cho đến nay.

Khám phá dòng mô hình mã nguồn mở Llama 3.1 mới của Meta, bao gồm 8B linh hoạt, 70B toàn diện và 405B hàng đầu, mô hình lớn nhất và tiên tiến nhất của họ cho đến nay.

Vào ngày 23 tháng 7 năm 2024, Meta đã phát hành dòng mô hình mã nguồn mở Llama 3.1 mới, bao gồm 8B linh hoạt, 70B có khả năng và các mô hình Llama 3.1 405B, với mô hình mới nhất nổi bật là mô hình ngôn ngữ lớn (LLM) mã nguồn mở lớn nhất cho đến nay.

Bạn có thể tự hỏi điều gì làm cho các mô hình mới này khác biệt so với các mô hình tiền nhiệm của chúng. Chà, khi chúng ta đi sâu vào bài viết này, bạn sẽ khám phá ra rằng việc phát hành các mô hình Llama 3.1 đánh dấu một cột mốc quan trọng trong công nghệ AI. Các mô hình mới được phát hành cung cấp những cải tiến đáng kể trong xử lý ngôn ngữ tự nhiên; hơn nữa, chúng giới thiệu các tính năng và cải tiến mới không có trong các phiên bản trước. Bản phát hành này hứa hẹn sẽ thay đổi cách chúng ta tận dụng AI cho các tác vụ phức tạp, cung cấp một bộ công cụ mạnh mẽ cho các nhà nghiên cứu và nhà phát triển.

Trong bài viết này, chúng ta sẽ khám phá dòng mô hình Llama 3.1, đi sâu vào kiến trúc, những cải tiến chính, các ứng dụng thực tế và so sánh chi tiết về hiệu suất của chúng.

Mô hình ngôn ngữ lớn mới nhất của Meta, Llama 3.1, đang có những bước tiến đáng kể trong lĩnh vực AI, sánh ngang với khả năng của các mô hình hàng đầu như Chat GPT-4o của OpenAI và Anthropic Bài thơ Sonnet 3.5 của Claude .

Mặc dù nó có thể được coi là một bản cập nhật nhỏ so với mô hình Llama 3 trước đó, Meta đã tiến thêm một bước nữa bằng cách giới thiệu một số cải tiến quan trọng cho dòng mô hình mới, cung cấp:

Ngoài tất cả những điểm trên, dòng mô hình Llama 3.1 mới còn nổi bật với một bước tiến vượt bậc với mô hình 405 tỷ tham số ấn tượng. Con số tham số đáng kể này đánh dấu một bước tiến vượt bậc trong phát triển AI, nâng cao đáng kể khả năng hiểu và tạo ra văn bản phức tạp của mô hình. Mô hình 405B bao gồm một loạt các tham số mở rộng, mỗi tham số tham chiếu đến... weights and biases trong mạng nơ-ron mà mô hình học được trong quá trình huấn luyện. Điều này cho phép mô hình nắm bắt các mẫu ngôn ngữ phức tạp hơn, thiết lập một tiêu chuẩn mới cho các mô hình ngôn ngữ lớn và thể hiện tiềm năng tương lai của công nghệ AI. Mô hình quy mô lớn này không chỉ cải thiện hiệu suất trên nhiều tác vụ mà còn mở rộng giới hạn những gì AI có thể đạt được về khả năng tạo và hiểu văn bản.

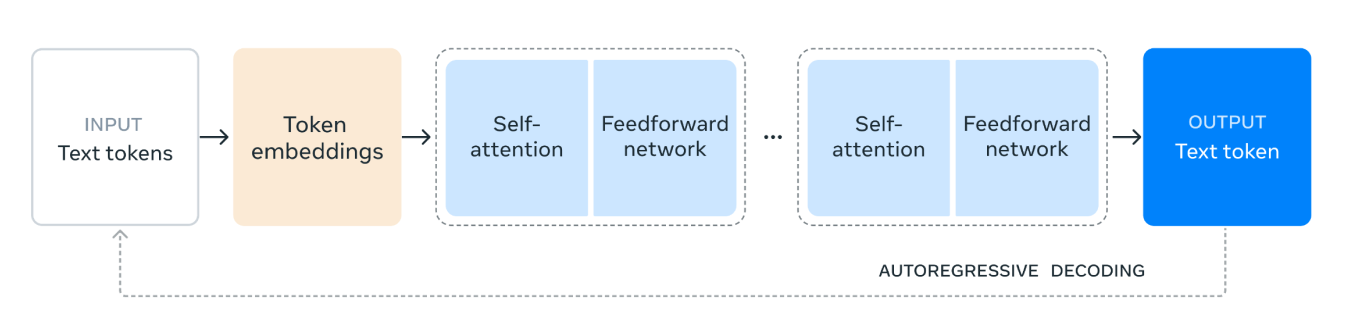

Llama 3.1 tận dụng kiến trúc mô hình transformer chỉ có bộ giải mã (decoder-only), một nền tảng cho các mô hình ngôn ngữ lớn hiện đại. Kiến trúc này nổi tiếng về hiệu quả và tính hiệu quả trong việc xử lý các tác vụ ngôn ngữ phức tạp. Việc sử dụng transformer cho phép Llama 3.1 vượt trội trong việc hiểu và tạo ra văn bản giống con người, mang lại lợi thế đáng kể so với các mô hình sử dụng các kiến trúc cũ hơn như LSTM và GRU.

Ngoài ra, dòng mô hình Llama 3.1 sử dụng kiến trúc Mixture of Experts (MoE), giúp tăng cường hiệu quả và tính ổn định của quá trình huấn luyện. Việc tránh kiến trúc MoE đảm bảo một quy trình huấn luyện nhất quán và đáng tin cậy hơn, vì MoE đôi khi có thể gây ra những phức tạp có thể ảnh hưởng đến tính ổn định và hiệu suất của mô hình.

Kiến trúc mô hình Llama 3.1 hoạt động như sau:

1. Input Text Tokens (Các Token Văn Bản Đầu Vào): Quá trình bắt đầu với đầu vào, bao gồm các token văn bản. Các token này là các đơn vị văn bản riêng lẻ, chẳng hạn như từ hoặc các phần của từ, mà mô hình sẽ xử lý.

2. Token Embeddings (Nhúng Token): Các token văn bản sau đó được chuyển đổi thành các token embeddings. Embeddings là các biểu diễn vector dày đặc của các token, nắm bắt ý nghĩa ngữ nghĩa và mối quan hệ của chúng trong văn bản. Sự chuyển đổi này rất quan trọng vì nó cho phép mô hình làm việc với dữ liệu số.

3. Self-Attention Mechanism (Cơ chế Tự Chú Ý): Self-attention cho phép mô hình cân nhắc tầm quan trọng của các token khác nhau trong chuỗi đầu vào khi mã hóa mỗi token. Cơ chế này giúp mô hình hiểu ngữ cảnh và mối quan hệ giữa các token, bất kể vị trí của chúng trong chuỗi. Trong cơ chế self-attention, mỗi token trong chuỗi đầu vào được biểu diễn dưới dạng một vector số. Các vector này được sử dụng để tạo ra ba loại biểu diễn khác nhau: queries (truy vấn), keys (khóa) và values (giá trị).

Mô hình tính toán mức độ chú ý mà mỗi token nên dành cho các token khác bằng cách so sánh các query vector với các key vector. Sự so sánh này dẫn đến các điểm số cho biết mức độ liên quan của mỗi token so với các token khác.

4. Mạng truyền thẳng : Sau quá trình tự chú ý, dữ liệu sẽ đi qua một mạng truyền thẳng. Mạng này là một mạng nơ-ron kết nối hoàn toàn, áp dụng các phép biến đổi phi tuyến tính lên dữ liệu, giúp mô hình nhận dạng và học các mẫu phức tạp.

5. Repeated Layers (Các Lớp Lặp Lại): Các lớp self-attention và mạng feedforward được xếp chồng lên nhau nhiều lần. Việc áp dụng lặp lại này cho phép mô hình nắm bắt các phụ thuộc và mẫu phức tạp hơn trong dữ liệu.

6. Output Text Token (Token Văn Bản Đầu Ra): Cuối cùng, dữ liệu đã xử lý được sử dụng để tạo ra token văn bản đầu ra. Token này là dự đoán của mô hình cho từ hoặc phần của từ tiếp theo trong chuỗi, dựa trên ngữ cảnh đầu vào.

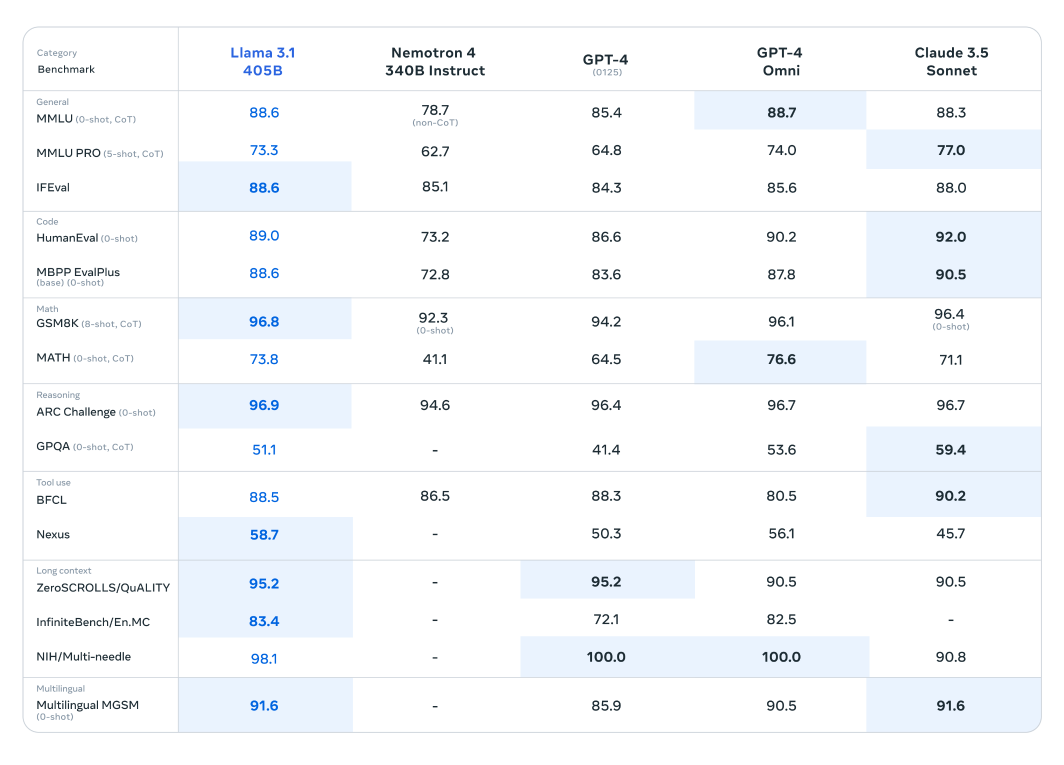

Các bài kiểm tra điểm chuẩn cho thấy Llama 3.1 không chỉ giữ vững vị thế trước các mô hình hiện đại này mà còn vượt trội hơn chúng trong một số tác vụ nhất định, thể hiện hiệu suất vượt trội của nó.

Mô hình Llama 3.1 đã trải qua quá trình đánh giá mở rộng trên hơn 150 bộ dữ liệu chuẩn, nơi nó đã được so sánh một cách nghiêm ngặt với các mô hình ngôn ngữ lớn hàng đầu khác. Mô hình Llama 3.1 405B, được công nhận là mô hình có khả năng nhất trong loạt sản phẩm mới phát hành, đã được so sánh với các ông lớn trong ngành như GPT-4 của OpenAI và Claude 3.5 Sonnet. Kết quả từ những so sánh này cho thấy Llama 3.1 thể hiện lợi thế cạnh tranh, thể hiện hiệu suất và khả năng vượt trội của nó trong nhiều tác vụ khác nhau.

Số lượng tham số ấn tượng và kiến trúc tiên tiến của mô hình này cho phép nó vượt trội trong việc hiểu và tạo văn bản phức tạp, thường vượt qua các đối thủ cạnh tranh trong các điểm chuẩn cụ thể. Những đánh giá này làm nổi bật tiềm năng của Llama 3.1 trong việc thiết lập các tiêu chuẩn mới trong lĩnh vực mô hình ngôn ngữ lớn, cung cấp cho các nhà nghiên cứu và nhà phát triển một công cụ mạnh mẽ cho các ứng dụng đa dạng.

Các mô hình Llama nhỏ hơn và nhẹ hơn cũng thể hiện hiệu suất đáng chú ý khi so sánh với các đối tác của chúng. Mô hình Llama 3.1 70B đã được đánh giá so với các mô hình lớn hơn như Mistral 8x22B và GPT-3.5 Turbo. Ví dụ: mô hình Llama 3.1 70B liên tục thể hiện hiệu suất vượt trội trong các bộ dữ liệu lý luận như bộ dữ liệu ARC Challenge và các bộ dữ liệu mã hóa như bộ dữ liệu HumanEval. Những kết quả này làm nổi bật tính linh hoạt và mạnh mẽ của dòng Llama 3.1 trên các kích thước mô hình khác nhau, khiến nó trở thành một công cụ có giá trị cho nhiều ứng dụng.

Ngoài ra, mô hình Llama 3.1 8B đã được so sánh với các mô hình có kích thước tương tự, bao gồm Gemma 2 9B và Mistral 7B. Những so sánh này cho thấy mô hình Llama 3.1 8B vượt trội hơn các đối thủ cạnh tranh trong nhiều bộ dữ liệu chuẩn khác nhau trong các thể loại khác nhau, chẳng hạn như bộ dữ liệu GPQA để lý luận và MBPP EvalPlus để mã hóa, thể hiện hiệu quả và khả năng của nó mặc dù số lượng tham số nhỏ hơn.

Meta đã cho phép áp dụng các mô hình mới này vào nhiều cách thức thiết thực và hữu ích cho người dùng:

Giờ đây, người dùng có thể tinh chỉnh (fine-tune) các mô hình Llama 3.1 mới nhất cho các trường hợp sử dụng cụ thể. Quá trình này bao gồm huấn luyện (training) mô hình trên dữ liệu bên ngoài mới mà trước đây nó chưa được tiếp xúc, từ đó nâng cao hiệu suất và khả năng thích ứng của mô hình cho các ứng dụng mục tiêu. Tinh chỉnh (fine-tuning) mang lại cho mô hình một lợi thế đáng kể bằng cách cho phép nó hiểu rõ hơn và tạo ra nội dung liên quan đến các lĩnh vực hoặc tác vụ (tasks) cụ thể.

Các mô hình Llama 3.1 giờ đây có thể được tích hợp liền mạch vào hệ thống Tạo Sinh Tăng Cường Tìm Kiếm (Retrieval-Augmented Generation - RAG). Sự tích hợp này cho phép mô hình tận dụng các nguồn dữ liệu bên ngoài một cách linh hoạt, nâng cao khả năng cung cấp các phản hồi chính xác và phù hợp theo ngữ cảnh. Bằng cách truy xuất thông tin từ các tập dữ liệu lớn và kết hợp nó vào quá trình tạo sinh, Llama 3.1 cải thiện đáng kể hiệu suất của nó trong các tác vụ chuyên sâu về kiến thức, cung cấp cho người dùng các kết quả chính xác và đầy đủ thông tin hơn.

Bạn cũng có thể sử dụng mô hình 405 tỷ tham số để tạo dữ liệu tổng hợp (synthetic data) chất lượng cao, nâng cao hiệu suất của các mô hình chuyên dụng cho các trường hợp sử dụng cụ thể. Cách tiếp cận này tận dụng các khả năng mở rộng của Llama 3.1 để tạo ra dữ liệu có mục tiêu và phù hợp, từ đó cải thiện độ chính xác và hiệu quả của các ứng dụng AI được điều chỉnh.

Việc phát hành Llama 3.1 thể hiện một bước tiến đáng kể trong lĩnh vực mô hình ngôn ngữ lớn, thể hiện cam kết của Meta trong việc thúc đẩy công nghệ AI.

Với số lượng tham số đáng kể, quá trình huấn luyện mở rộng trên các tập dữ liệu đa dạng và tập trung vào các quy trình huấn luyện mạnh mẽ và ổn định, Llama 3.1 đặt ra các tiêu chuẩn mới về hiệu suất và khả năng trong xử lý ngôn ngữ tự nhiên. Cho dù là trong tạo văn bản, tóm tắt hay các tác vụ đàm thoại phức tạp, Llama 3.1 đều thể hiện lợi thế cạnh tranh so với các mô hình hàng đầu khác. Mô hình này không chỉ đẩy lùi ranh giới của những gì AI có thể đạt được ngày nay mà còn tạo tiền đề cho những đổi mới trong tương lai trong bối cảnh trí tuệ nhân tạo không ngừng phát triển.

Tại Ultralytics Chúng tôi cam kết mở rộng ranh giới của công nghệ AI. Để khám phá các giải pháp AI tiên tiến và cập nhật những cải tiến mới nhất, hãy truy cập kho lưu trữ GitHub của chúng tôi. Tham gia cộng đồng sôi động của chúng tôi trên Discord và xem cách chúng tôi đang cách mạng hóa các ngành công nghiệp như xe tự lái và sản xuất ! 🚀