了解 Mask R-CNN 如何用于精确segment 图像和视频中的对象,以满足不同领域的各种应用需求。

了解 Mask R-CNN 如何用于精确segment 图像和视频中的对象,以满足不同领域的各种应用需求。

随着 AI 采用率的提高,仓库中的机器人、在繁忙街道上安全行驶的自动驾驶汽车、检查农作物的无人机以及在工厂中检查产品的 AI 系统等创新变得越来越普遍。推动这些创新的关键技术是计算机视觉,它是 AI 的一个分支,使机器能够理解和解释视觉数据。

例如,目标检测是一项计算机视觉任务,可帮助使用边界框识别和定位图像中的对象。虽然边界框提供了有用的信息,但它们仅提供对象位置的粗略估计,无法捕获其精确的形状或边界。这使得它们在需要精确识别的应用中效果较差。

为了解决这个问题,研究人员开发了分割模型,该模型可以捕获对象的精确轮廓,从而提供像素级细节,以实现更准确的检测和分析。

Mask R-CNN 就是这些模型中的一种。它由 Facebook AI Research(FAIR)于 2017 年推出,建立在R-CNN、Fast R-CNN 和 Faster R-CNN 等早期模型的基础上。作为计算机视觉史上的一个重要里程碑,Mask R-CNN 为更先进的模型铺平了道路,例如 Ultralytics YOLO11.

在本文中,我们将探讨什么是 Mask R-CNN、它是如何工作的、它的应用以及它之后的改进,最终形成YOLO11。

Mask R-CNN,即基于掩码区域的卷积神经网络,是一种深度学习模型,专为计算机视觉任务(如对象检测和实例分割)而设计。

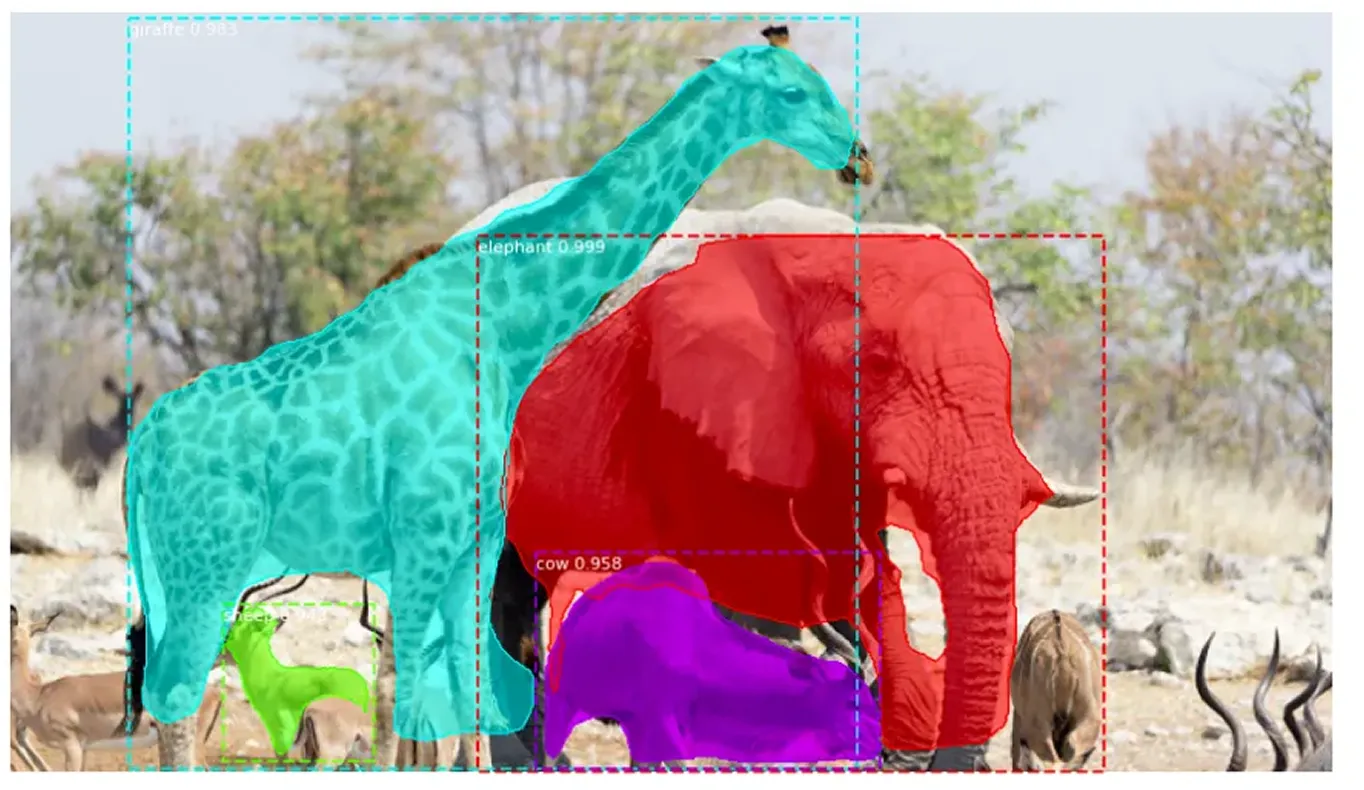

实例分割超越了传统的物体检测,不仅可以识别图像中的物体,还可以准确地勾勒出每个物体。它为每个检测到的物体分配一个唯一的标签,并捕获其像素级的精确形状。这种细致的方法可以清楚地区分重叠的物体,并准确地处理复杂的形状。

Mask R-CNN 以 Faster R-CNN 为基础构建,后者可以检测和标记对象,但不能定义它们的精确形状。 Mask R-CNN 通过识别构成每个对象的精确像素来改进这一点,从而实现更详细和准确的图像分析。

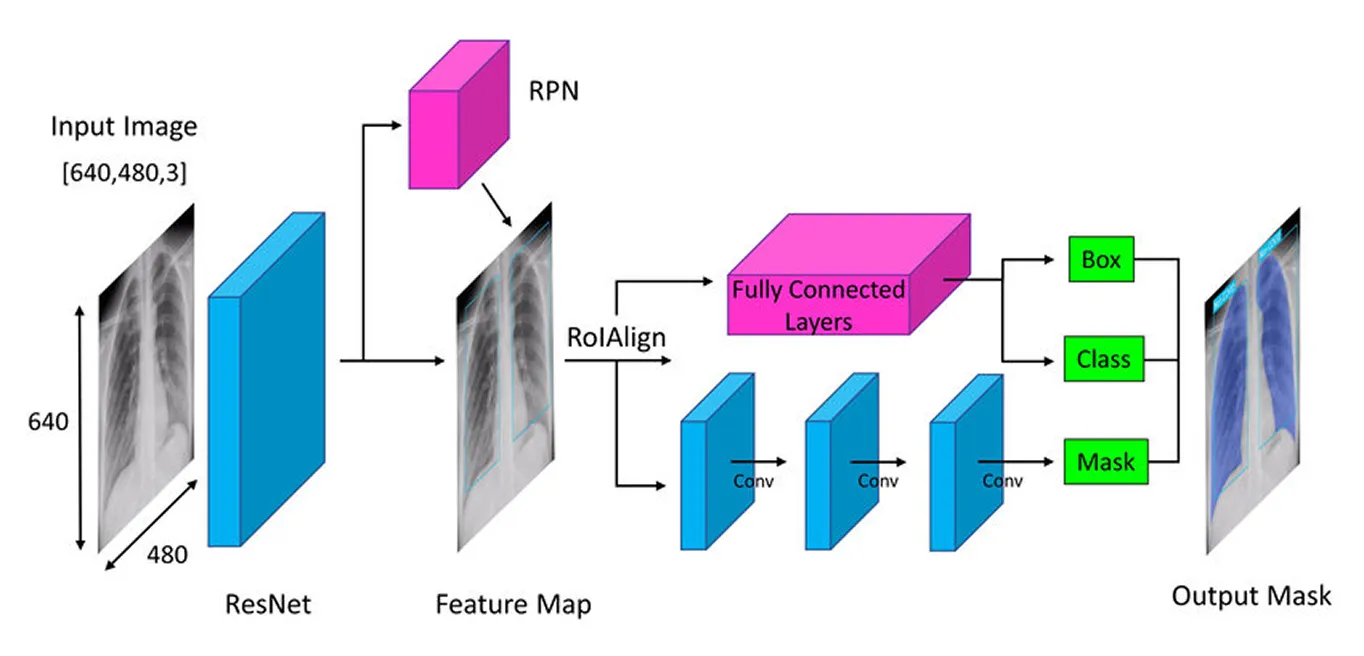

Mask R-CNN 采用循序渐进的方法来准确detect 和segment 物体。它首先使用深度神经网络(一种从数据中学习的多层模型)提取关键特征,然后使用区域建议网络(一种建议可能的物体区域的组件)识别潜在的物体区域,最后通过创建详细的分割蒙版(物体的精确轮廓)来完善这些区域,从而捕捉每个物体的精确形状。

接下来,我们将逐步讲解 Mask R-CNN 的工作原理,以便更好地理解。

Mask R-CNN 架构的第一步是将图像分解为关键部分,以便模型能够理解其中的内容。这就像您看照片时,会自然地注意到形状、颜色和边缘等细节。模型使用一种称为“骨干网络”(通常是 ResNet-50 或 ResNet-101)的深度神经网络来执行类似的操作,它就像模型的眼睛一样扫描图像并提取关键细节。

由于图像中的物体可能非常小或非常大,Mask R-CNN 使用了特征金字塔网络。这就像拥有不同的放大镜,让模型既能看到精细的细节,又能看到更大的画面,确保注意到所有尺寸的物体。

一旦提取了这些重要的 特征,模型就会开始定位图像中潜在的对象,为进一步的分析奠定基础。

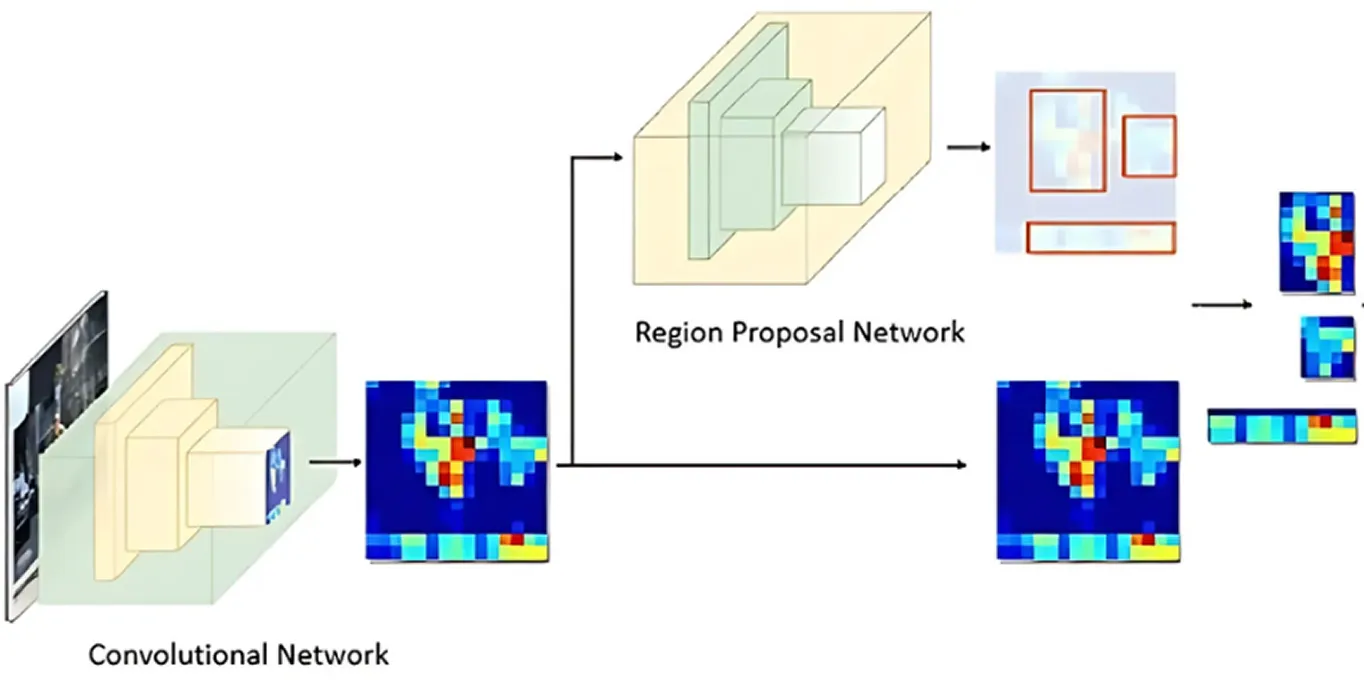

在图像经过关键特征处理后,区域提议网络接管。模型的这一部分会查看图像并建议可能包含对象的区域。

它通过生成多个可能的对象位置(称为锚点)来实现这一点。然后,网络评估这些锚点,并选择最有希望的锚点进行进一步分析。这样,模型只关注最有可能感兴趣的区域,而不是检查图像中的每个点。

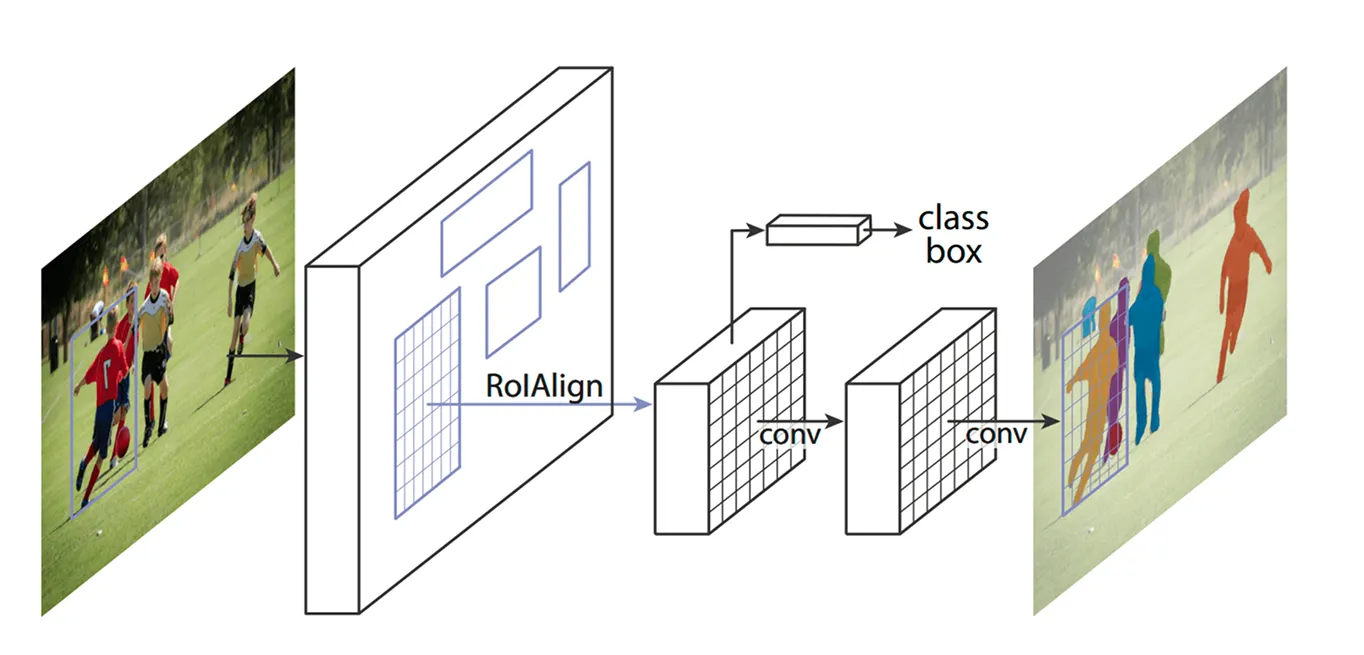

在确定了关键区域之后,下一步是细化从这些区域提取的细节。早期的模型使用一种称为 ROI Pooling(感兴趣区域池化)的方法来获取每个区域的特征,但是这种技术有时会导致在调整区域大小时出现轻微的错位,使其效率降低——尤其是在较小或重叠的物体上。

Mask R-CNN 通过使用一种称为 ROI Align(感兴趣区域对齐)的技术对此进行了改进。 ROI Align 没有像 ROI Pooling 那样对坐标进行四舍五入,而是使用双线性插值来更精确地估计像素值。 双线性插值是一种通过平均其四个最近邻居的值来计算新像素值的方法,从而创建更平滑的过渡。 这使得特征与原始图像正确对齐,从而实现更准确的对象检测和分割。

例如,在足球比赛中,两个站得很近的球员可能会被误认为是一个人,因为他们的边界框重叠。ROI Align 通过保持他们的形状不同来帮助区分他们。

ROI Align 处理完图像后,下一步就是对物体进行classify 并微调其位置。该模型会查看每个提取的区域,并决定其中包含的物体。它为不同类别分配一个概率分值,并挑选出最匹配的对象。

与此同时,它会调整边界框以更好地拟合对象。最初的框可能未理想地放置,因此这有助于通过确保每个框紧密地围绕检测到的对象来提高准确性。

最后,Mask R-CNN 采取了额外的步骤:它并行地为每个对象生成详细的分割掩码。

该模型一经问世,就受到了人工智能界的热烈追捧,并很快被应用于各种领域。其实时detect 和segment 物体的能力改变了各行各业的游戏规则。

例如,追踪野外濒危动物是一项极具挑战性的任务。许多物种在茂密的森林中穿梭,保护主义者很难track 它们。传统方法使用相机陷阱、无人机和卫星图像,但手工整理这些数据非常耗时。错误的识别和遗漏的目击会拖慢保护工作。

通过识别老虎的条纹、长颈鹿的斑点或大象耳朵的形状等独特特征,Mask R-CNN 可以更准确地detect 和segment 图像和视频中的动物。即使动物部分被树木遮挡或站在一起,模型也能将它们分开并逐一识别,从而使野生动物监测工作更快、更可靠。

尽管 Mask R-CNN 在目标检测和分割方面具有历史意义,但它也存在一些主要缺点。以下是与 Mask R-CNN 相关的一些挑战:

掩膜 R-CNN 非常适合分割任务,但许多行业都希望采用计算机视觉,同时优先考虑速度和实时性。在这种要求下,研究人员开发出了能一次性detect 物体的单级模型,大大提高了效率。

与 Mask R-CNN 的多步骤过程不同,YOLO (You Only Look Once)等单阶段计算机视觉模型侧重于实时计算机视觉任务。YOLO 模型可以一次性分析图像,而不是分别处理检测和分割。这使其成为自动驾驶、医疗保健、制造和机器人等应用的理想选择,在这些应用中,快速决策至关重要。

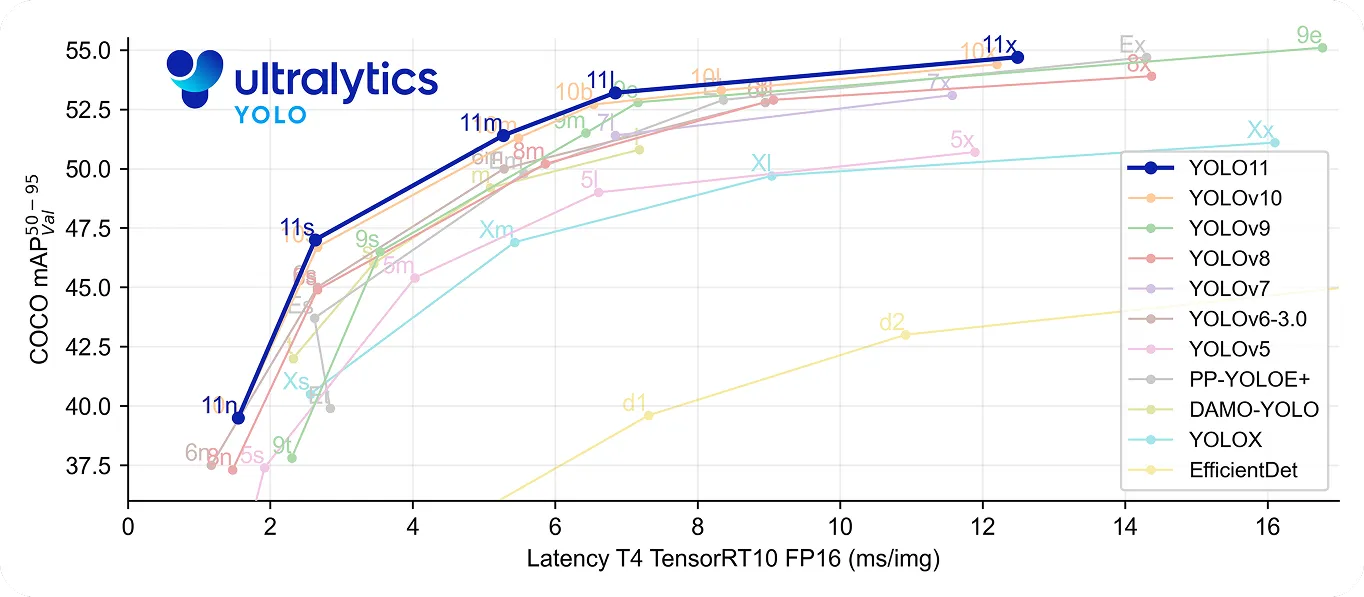

其中,YOLO11 在快速和精确方面更进一步。它使用的参数比YOLOv8m 少 22%,但在COCO 数据集上仍能达到更高的平均精度mAP),这意味着它能更精确地检测到物体。处理速度的提高使它成为每毫秒都很重要的实时应用的理想选择。

回顾计算机视觉的历史,Mask R-CNN 被认为是目标检测和分割领域的一项重大突破。由于其详细的多步骤流程,即使在复杂的设置中也能提供非常精确的结果。

然而,与YOLO 等实时模型相比,这一过程也使其速度较慢。随着对速度和效率的要求越来越高,许多应用现在都使用Ultralytics YOLO11 这样的单级模型,以提供快速、准确的物体检测。虽然 Mask R-CNN 对于了解计算机视觉的发展非常重要,但实时解决方案的发展趋势凸显了对更快、更高效的计算机视觉解决方案的需求日益增长。

加入我们不断壮大的社区!探索我们的GitHub 仓库以了解更多关于人工智能的信息。准备好开始您自己的计算机视觉项目了吗?查看我们的许可选项。通过访问我们的解决方案页面,了解农业领域的人工智能和医疗保健领域的 Vision AI!