与我们一起深入研究 Meta AI 的 Segment Anything Model 2SAM 2),了解它在各行各业的实时应用。

与我们一起深入研究 Meta AI 的 Segment Anything Model 2SAM 2),了解它在各行各业的实时应用。

2024 年 7 月 29 日,Meta AI 发布了第二版SAM Anything Model,即SAM 2。新模型可以在图像和视频中精确定位哪些像素属于目标对象!最棒的是,该模型能够在视频的所有帧中实时一致地跟踪目标。SAM 2 为视频编辑、混合现实体验以及更快地注释视觉数据以训练计算机视觉系统带来了令人兴奋的可能性。

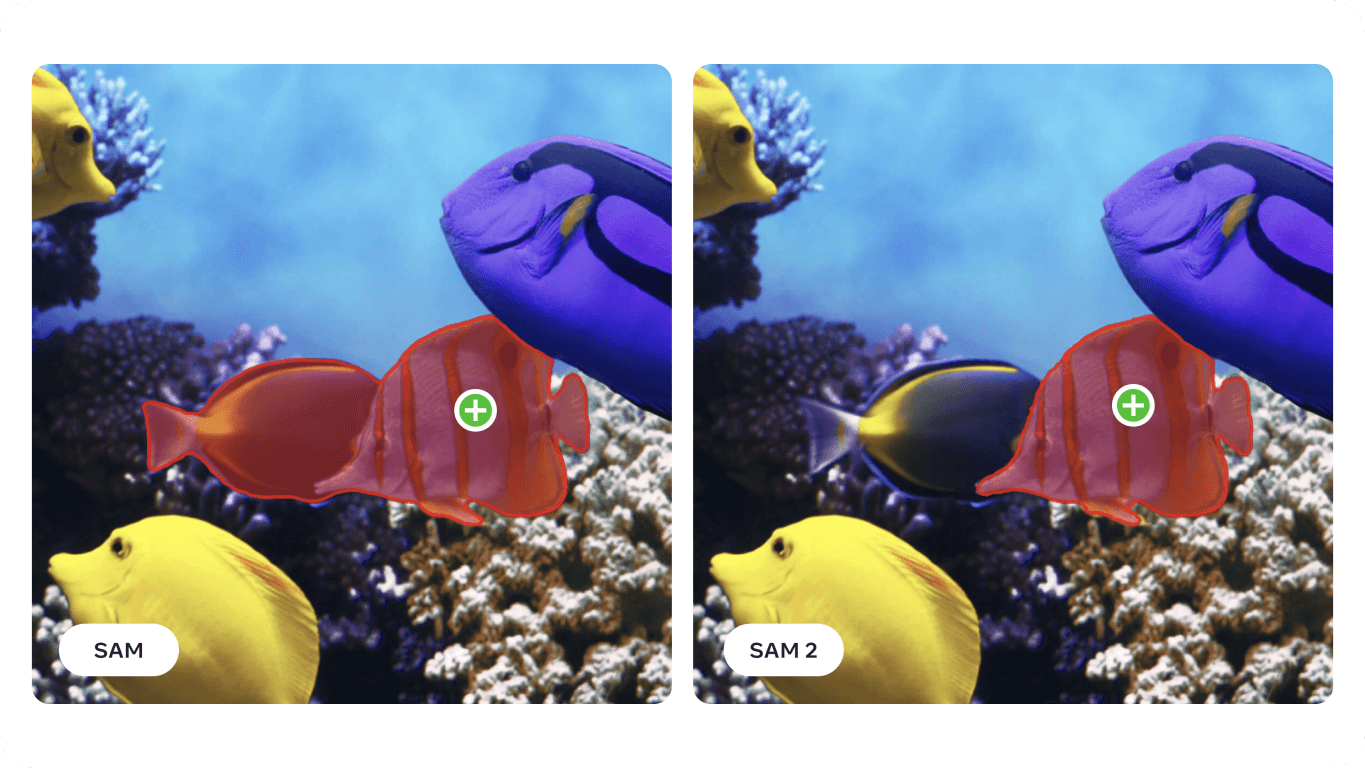

最初的SAM 已成功应用于海洋科学、卫星图像和医学等领域,在此基础上,SAM 2 解决了快速移动物体和外观变化等难题。精度和效率的提高使其成为适用于广泛应用的多功能工具。在本文中,我们将重点介绍SAM 2 的应用领域以及它对人工智能界的重要性。

Segment Anything Model 2 是一种先进的基础模型,支持图像和视频中的可提示视觉分割或 PVS。PVS 是一种技术,在这种技术中,模型可以 segment或识别图像或视频的不同部分。这些提示可以是点击、方框或突出显示感兴趣区域的遮罩等形式。然后,模型会生成一个分割掩码,勾勒出指定区域的轮廓。

SAM 2 架构以最初的SAM 为基础,从图像分割扩展到视频分割。它采用轻量级掩码解码器,使用图像数据和提示来创建分割掩码。在视频方面,SAM 2 引入了一个记忆系统,帮助它记忆前一帧的信息,确保长期精确跟踪。记忆系统包括存储和调用被分割对象细节的组件。SAM 2 还能处理遮挡、通过多帧track 物体,并通过生成多个可能的遮罩来处理模糊提示。SAM 2 的先进架构使其在静态和动态视觉环境中都具有很强的能力。

具体来说,在视频分割方面,与以前的方法相比,SAM 2 的准确率更高,而用户交互次数却减少了三倍。在图像分割方面,SAM 2 优于原始的任意分割模型(SAM),速度快六倍,准确性更高。SAM 2 的研究论文展示了在 37 个不同数据集上的改进,其中包括SAM 之前测试过的 23 个数据集。

有趣的是,Meta AI 的SAM 2 是通过创建迄今为止最大的视频分割数据集SA-V 数据集而开发的。这个庞大的数据集包括 50,000 多个视频和 3550 万个分割掩码,是通过用户的互动贡献收集的。注释者提供提示和修正,帮助模型从各种场景和对象类型中学习。

凭借其在图像和视频分割方面的先进功能,SAM 2 可用于各行各业。让我们来探讨其中的一些应用。

Meta AI 的新细分模型可用于增强现实(AR)和虚拟现实(VR)应用。例如,SAM 2 可以准确识别和segment 现实世界中的物体,并使与虚拟物体的交互感觉更加逼真。它可以在游戏、教育和培训等各个领域发挥作用,在这些领域,虚拟和现实元素之间的逼真互动至关重要。

随着 AR 眼镜等设备越来越先进,SAM 2 的功能很快就能集成到这些设备中。 想象一下,戴上眼镜,环顾客厅四周。如下图所示,当眼镜segment 并注意到狗狗的水盆时,它可能会提醒你为水盆加水。或者,如果您正在烹饪新菜谱,眼镜可以识别台面上的配料,并提供分步说明和提示,从而改善您的烹饪体验,确保您手头有所有必需的物品。

对SAM 模型的研究表明,它可以应用于声纳成像等专业领域。声纳成像具有分辨率低、噪声大以及图像中物体形状复杂等特点,因此面临着独特的挑战。通过针对声纳图像对SAM 进行微调,研究人员已经证明它能够准确segment 各种水下物体,如海洋废弃物、地质构造和其他感兴趣的物体。精确可靠的水下成像技术可用于海洋研究、水下考古、渔业管理和监视等任务,如栖息地绘图、文物发现和威胁探测。

%25252525201.png)

由于SAM 2 在SAM 面临的许多挑战的基础上进行了改进,因此有可能进一步提高声纳成像的分析能力。其精确的分割能力可以帮助各种海洋应用,包括科学研究和渔业。例如,SAM 2 可以有效地勾勒水下结构、detect 海洋废弃物以及识别前视声纳图像中的物体,从而有助于更准确、更高效地进行水下勘探和监测。

以下是使用SAM 2 分析声纳成像的潜在优势:

通过将SAM 2 集成到声纳成像流程中,海洋行业可以在水下勘探和分析中实现更高的效率、精度和可靠性,最终在海洋研究中取得更好的成果。

SAM 2 的另一个应用领域是自动驾驶汽车。SAM 2 可以实时准确地识别行人、其他车辆、路标和障碍物等物体。SAM 2 能够提供的详细程度对于做出安全导航和避免碰撞的决策至关重要。通过精确处理视觉数据,SAM 2 可以帮助创建详细可靠的环境地图,从而做出更好的决策。

SAM 2 能够在不同的光照条件、天气变化和动态环境下良好工作,这使它成为自动驾驶汽车的可靠保障。无论是繁忙的城市街道,还是雾气弥漫的高速公路,SAM 2 都能持续准确地识别和segment 物体,使车辆能够正确应对各种情况。

不过,也有一些局限性需要注意。对于复杂、快速移动的物体,SAM 2 有时会漏掉一些细节,而且其预测结果在不同帧之间会变得不稳定。此外,在拥挤的场景中,SAM 2 有时会混淆多个外观相似的物体。这些挑战正是集成更多传感器和技术在自动驾驶应用中至关重要的原因。

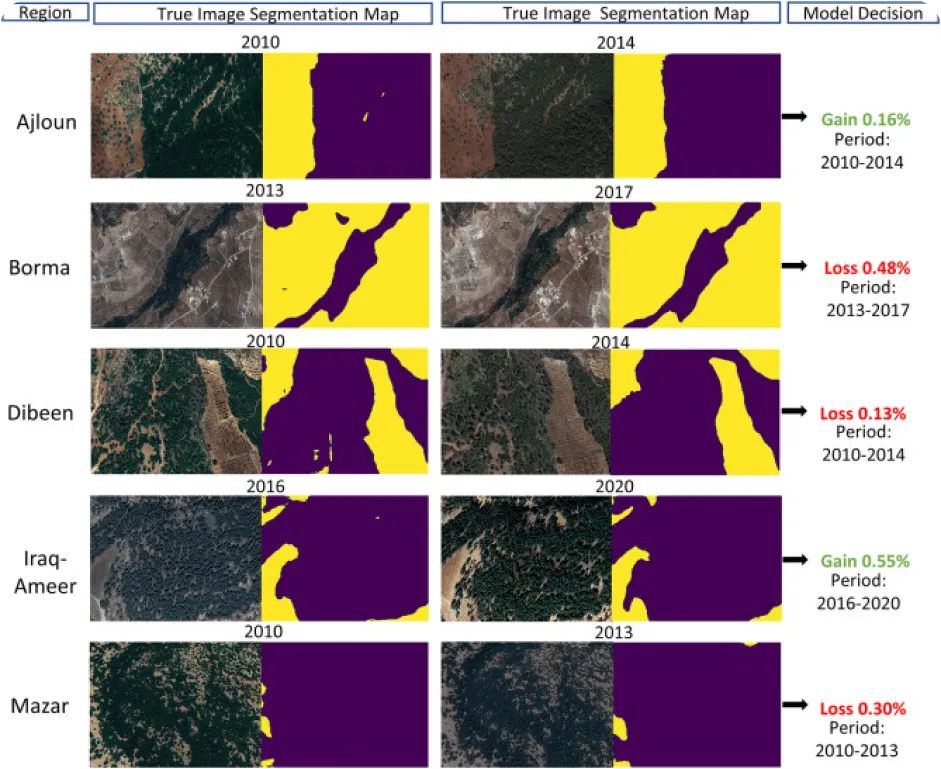

利用计算机视觉进行环境监测可能很棘手,尤其是在缺乏注释数据的情况下,但这也正是SAM 2 的有趣应用之处。通过从卫星或无人机图像中精确分割和识别森林、水体、城市区域和农田等各种环境特征,SAM 2 可用于track 和分析自然景观的变化。具体来说,精确分割有助于监测森林砍伐、城市化和土地使用随时间推移发生的变化,为环境保护和规划提供有价值的数据。

以下是使用SAM 2 等模型分析环境随时间变化的一些好处:

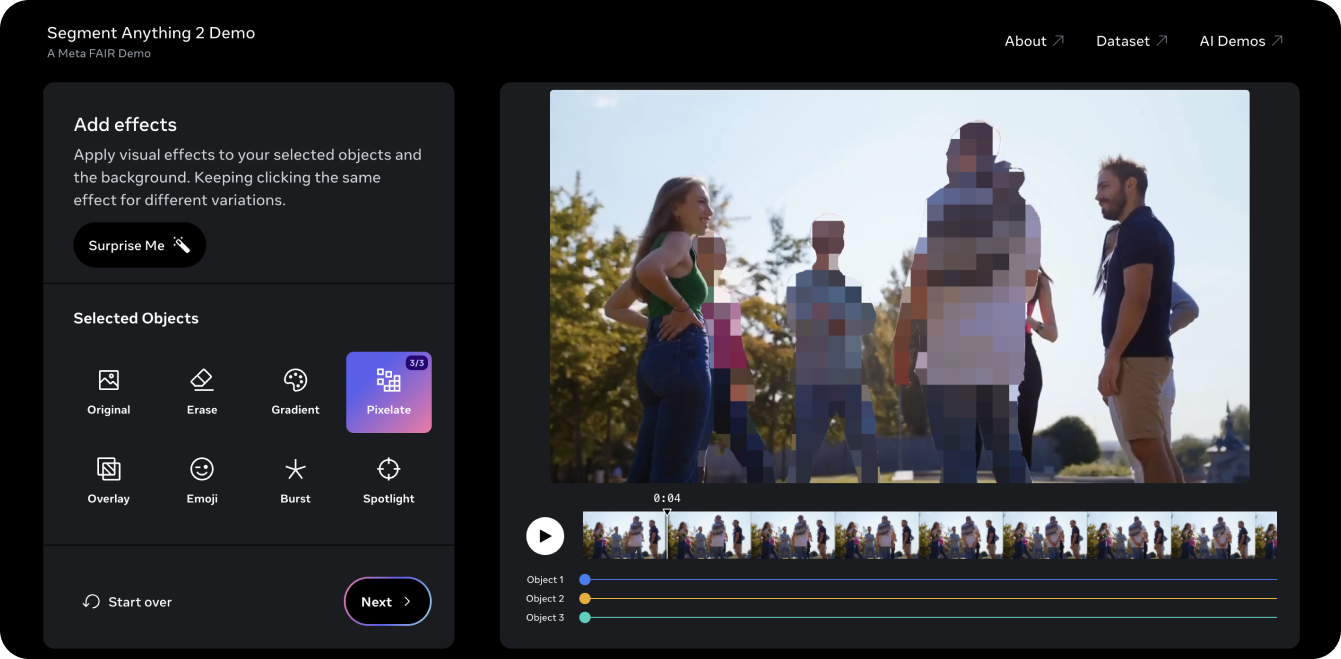

Segment Anything 2 演示是在视频中试用该模型的好方法。利用SAM 2 的 PVS 功能,我们截取了一段旧的Ultralytics YouTube 视频,并对视频中的三个物体或人物进行了segment 和像素化处理。传统上,从这样的视频中剪辑出三个人既费时又乏味,还需要手动逐帧屏蔽。然而,SAM 2 简化了这一过程。只需在演示程序上点击几下,就能在几秒钟内保护三个相关对象的身份。

在演示中,你还可以尝试一些不同的视觉效果,比如把聚光灯打在你选择跟踪的物体上,或者擦除被跟踪的物体。如果你喜欢这个演示,并准备开始使用SAM 2 进行创新,请查看Ultralytics SAM 2 模型文档页面,了解有关模型实际操作的详细说明。探索功能、安装步骤和示例,充分发挥SAM 2 在项目中的潜力!

Meta AI 的 Segment Anything Model 2SAM 2)正在改变视频和图像分割。随着物体跟踪等任务的改进,我们发现了视频编辑、混合现实、科学研究和医学成像领域的新机遇。通过简化复杂任务和加快注释速度,SAM 2 将成为人工智能界的重要工具。随着我们对SAM 2 等模型的不断探索和创新,我们可以预见在各个领域会有更多突破性的应用和进步!

通过浏览我们的 GitHub 仓库 并加入 我们的社区,了解更多关于 AI 的信息。查看我们的解决方案页面,了解关于 AI 在 制造业 和 医疗保健 领域的详细见解。🚀